如何有效绕过CDN反爬措施?

- 行业动态

- 2024-10-19

- 10

CDN(内容分发网络)是一种通过将内容缓存到全球多个服务器上来提高网站访问速度和可靠性的技术。反爬机制是指网站为了防止自动化程序(爬虫)抓取数据而采取的措施,如限制IP访问频率、使用验证码等。要应对CDN反爬,可以尝试以下方法:,,1. 使用代理IP:通过更换IP地址来绕过访问限制。,2. 设置UserAgent:模拟浏览器行为,降低被识别为爬虫的风险。,3. 添加请求头:如Referer、Cookie等,增加请求的可信度。,4. 使用动态加载技术:如AJAX、WebSocket等,减少对CDN的依赖。,5. 分析网页结构:了解目标网站的布局和数据加载方式,有针对性地抓取数据。,6. 使用第三方库:如Scrapy、BeautifulSoup等,简化爬虫开发过程。,7. 遵守Robots协议:尊重网站的爬虫规则,避免给网站带来不必要的负担。

CDN反爬

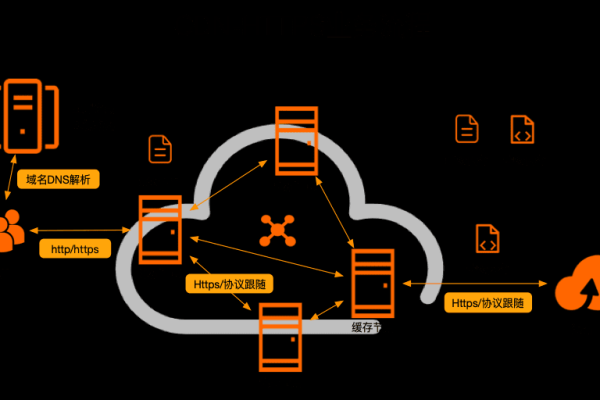

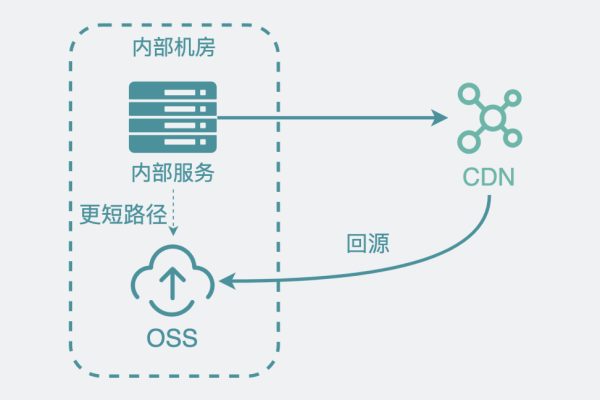

CDN(内容分发网络)通过在多个地理位置分布的服务器上缓存网站内容,从而加快用户访问速度并减轻源服务器的负载,CDN同样面临爬虫带来的挑战,爬虫是自动访问网页资源的机器人,它们会消耗大量的网络资源和服务器带宽,影响网站的正常运行和用户体验。

为了应对这一问题,CDN服务提供商通常会采用多种反爬虫机制,以下是一些常见的CDN反爬虫策略:

| 反爬虫策略 | 描述 |

| UserAgent检测 | CDN可以通过检查请求的UserAgent字段来识别爬虫,如果UserAgent字段包含已知的反面爬虫标识,则可以拒绝该请求,Cloudflare就使用UserAgent检测来识别和阻止某些爬虫。 |

| IP行为分析 | CDN可以根据IP地址的行为模式来判断是否为爬虫,来自同一IP地址的大量重复请求可能被认为是爬虫活动,因此会被限制或封禁。 |

| 验证码 | 在访问受保护的资源之前,要求用户输入验证码是一种有效的反爬虫手段,这可以有效防止自动化工具的访问。 |

| 请求限速 | 通过限制每个IP地址或账户单位时间内的请求次数,可以减少爬虫对服务器的压力,这种方法可以有效地防止暴力破解和DDoS攻击。 |

| Referer检查 | CDN可以通过检查Referer字段来确保请求来自合法的来源,非规或伪造的Referer字段可能会被拒绝。 |

| Cookie验证 | 通过设置和验证Cookie,CDN可以识别和阻止未经授权的访问,某些CDN服务会在响应中设置特定的Cookie,只有携带这个Cookie的请求才会被允许访问。 |

| JavaScript挑战 | 有些CDN会要求客户端执行特定的JavaScript代码才能继续访问,这对大多数自动化工具来说是一个挑战,因为它们通常无法执行复杂的JavaScript代码。 |

这些反爬虫措施不仅可以提高网站的安全性和稳定性,还能保护用户的隐私和数据安全,对于网站管理员来说,合理配置和使用这些策略,可以在不影响正常用户访问的前提下,有效阻止反面爬虫的活动。