CDN如何应对反爬虫策略的挑战?

- 行业动态

- 2025-03-09

- 13

一、CDN反爬虫技术

CDN(Content Delivery Network,内容分发网络)通过全球范围内的服务器节点来加速网站内容的访问速度,这也使得网站更容易受到爬虫程序的攻击,这些爬虫可能会对网站的数据进行反面抓取,导致数据泄露或服务器负载过高,CDN反爬虫技术应运而生,旨在防止爬虫程序对CDN上的内容进行非规访问和抓取。

二、CDN反爬虫的主要方法

1、IP黑名单与白名单:

IP黑名单:通过分析访问日志,识别出异常的访问行为,如短时间内大量的请求,将这些IP地址加入黑名单,阻止其访问。

IP白名单:将可信的IP地址加入白名单,确保正常用户的访问。

2、用户行为分析:

正常用户和爬虫程序的行为模式存在显著差异,正常用户通常会在页面上停留较长时间,进行点击、滚动等操作;而爬虫程序的行为则更加机械化,通常表现为快速浏览多个页面、无用户交互等,通过行为模式识别,可以有效区分两者,并采取相应的防护措施。

3、验证码验证:

图形验证码是最常见的形式,要求用户识别图片中的字符或图案,动态验证码则是图形验证码的进阶形式,通过动态生成验证码内容,增加破解难度。

4、生成:

通过在服务器端生成不同的页面内容,使得爬虫程序无法预料页面内容的变化,从而增加爬取的难度,可以在页面中插入随机生成的元素,如随机排列的文字或图片。

5、访问频率限制:

通过设置每个IP地址在一定时间内的最大请求次数,可以有效地防止爬虫程序的频繁访问,请求频率限制通常结合IP黑名单使用,当某个IP地址超过限制时,将其加入黑名单。

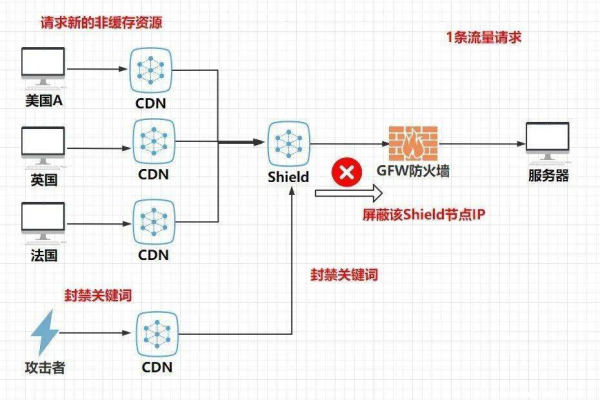

6、防火墙和WAF(Web应用防火墙):

防火墙可以控制访问权限,阻止不明来源的请求,WAF则能够识别并过滤反面流量,包括爬虫程序的流量,通过定期更新防火墙和WAF的规则集,可以抵御新型爬虫的攻击。

7、Token机制:

在请求中加入Token,验证请求的合法性,只有携带合法Token的请求才能访问CDN资源,防止爬虫未经授权的访问。

8、防盗链技术:

通过设置HTTP请求头中的Referer字段,只允许特定来源的请求访问CDN资源。

三、CDN反爬虫的挑战与解决方案

尽管CDN反爬虫技术已经取得了一定的成效,但仍面临一些挑战,如爬虫技术的不断进化、新型爬虫的出现等,为了应对这些挑战,需要不断更新和优化反爬虫策略,采用多种技术手段的结合,形成多重防护机制,也需要关注法律法规和道德规范,确保反爬虫措施的合法性和合理性。

四、相关问题与解答

问题1:什么是CDN反爬虫?

答:CDN反爬虫是指通过一系列技术手段来保护CDN上的内容免受反面爬取的攻击。

问题2:CDN反爬虫的主要方法有哪些?

答:主要方法包括IP黑名单与白名单、用户行为分析、验证码验证、动态内容生成、访问频率限制、防火墙和WAF、Token机制以及防盗链技术等。

问题3:如何应对CDN反爬虫的挑战?

答:需要不断更新和优化反爬虫策略,采用多种技术手段的结合形成多重防护机制,并关注法律法规和道德规范。