如何使用C进行网站数据爬取?

- 行业动态

- 2025-01-19

- 3670

使用C#爬取网站数据可以通过HttpClient类和HtmlAgilityPack库来实现。

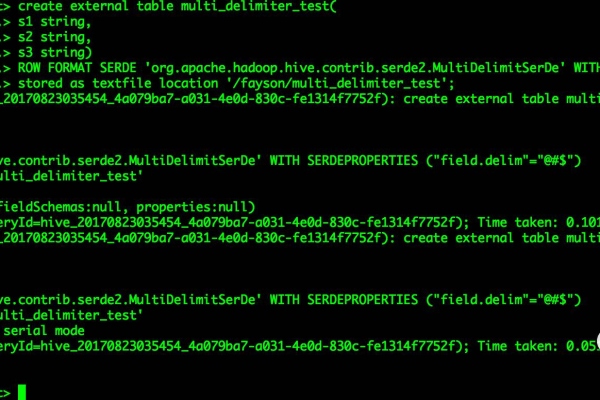

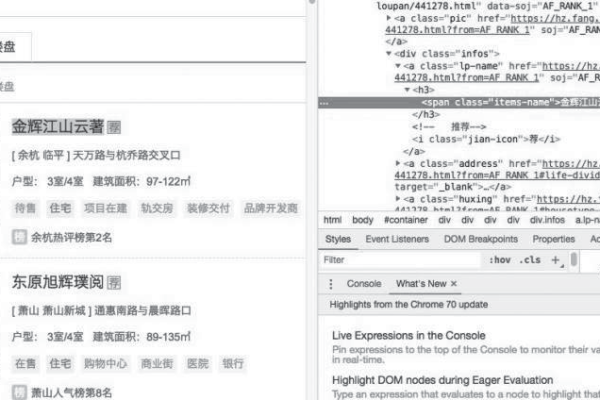

在C#中爬取网站数据通常需要使用一些第三方库,如HtmlAgilityPack来解析HTML文档,以及HttpClient来进行网络请求,以下是一个详细的步骤说明,包括代码示例:

1、安装必要的NuGet包:

打开你的Visual Studio项目。

右键点击解决方案资源管理器中的项目名称,选择“管理NuGet包”。

搜索并安装HtmlAgilityPack和System.Net.Http。

2、**创建一个新的C#类文件**:

在你的项目中添加一个新的C#类文件,例如WebScraper.cs。

3、编写代码以爬取网站数据:

using System;

using System.Net.Http;

using System.Threading.Tasks;

using HtmlAgilityPack;

namespace WebScrapingExample

{

public class WebScraper

{

private static readonly HttpClient httpClient = new HttpClient();

public async Task<string> GetWebsiteContentAsync(string url)

{

var response = await httpClient.GetAsync(url);

response.EnsureSuccessStatusCode();

return await response.Content.ReadAsStringAsync();

}

public async Task<HtmlDocument> ParseHtmlAsync(string htmlContent)

{

var htmlDoc = new HtmlDocument();

htmlDoc.LoadHtml(htmlContent);

return htmlDoc;

}

public void ScrapeData(string url)

{

var contentTask = GetWebsiteContentAsync(url);

contentTask.Wait(); // 等待异步操作完成

var htmlContent = contentTask.Result;

var htmlDoc = ParseHtmlAsync(htmlContent).Result;

// 假设我们要抓取所有的段落文本

var paragraphs = htmlDoc.DocumentNode.SelectNodes("//p");

foreach (var paragraph in paragraphs)

{

Console.WriteLine(paragraph.InnerText);

}

}

}

class Program

{

static async Task Main(string[] args)

{

string url = "http://example.com"; // 替换为你要爬取的网址

var scraper = new WebScraper();

await scraper.ScrapeData(url);

}

}

}4、运行程序:

确保你有互联网连接,并且目标网站可以访问。

运行程序,查看控制台输出,你应该能看到从指定网页抓取到的数据。

FAQs

Q1: 如果目标网站有反爬虫机制怎么办?

A1: 如果目标网站有反爬虫机制(如CAPTCHA验证、IP封锁等),你可能需要采取一些措施来绕过这些限制,使用代理服务器轮换IP地址,或者模拟浏览器行为(如设置User-Agent头),但请注意,尊重网站的robots.txt文件和使用条款是非常重要的,不要进行反面爬取。

Q2: 如何提高爬取效率?

A2: 为了提高爬取效率,你可以采取以下措施:

使用并发请求:通过Task或线程池并行发送多个HTTP请求。

优化选择器:确保你的XPath或CSS选择器尽可能高效,避免不必要的复杂查询。

减少不必要的网络请求:只请求你需要的资源,避免下载整个页面的所有资源。

使用缓存:对于不经常变化的数据,可以使用缓存机制减少重复请求。

小编有话说:爬取网站数据是一项强大的技术,但请务必遵守法律法规和道德规范,在进行数据爬取时,始终尊重网站所有者的权利和隐私政策,合理合法地使用这项技术,可以为你的项目带来巨大的价值。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:https://www.xixizhuji.com/fuzhu/397562.html