安卓局域网视频通信

- 行业动态

- 2025-04-23

- 1

安卓局域网视频通信基于RTSP/WebRTC协议,利用FFmpeg处理音 视频流,通过Wi-Fi/LAN IP传输,需信令服务器交换SDP/ICE,配合NAT穿透技术,采用H.264编解码,可借助LibVLC/ExoPlayer实现低延迟

技术基础与核心概念

局域网通信原理

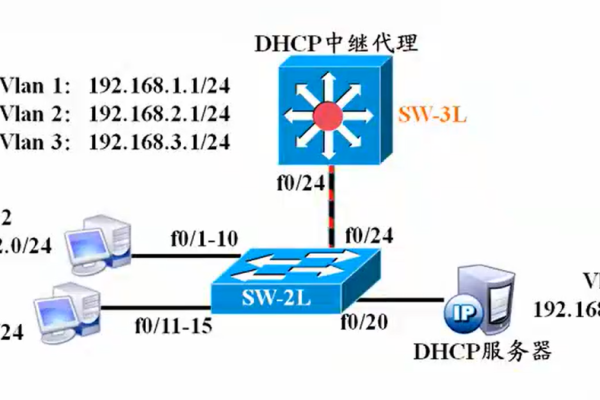

- 局域网(LAN):指小范围网络(如家庭、办公室),设备通过路由器/交换机连接,支持高速数据传输。

- 视频通信流程:

- 采集:通过摄像头和麦克风获取音视频数据。

- 编码:将原始数据压缩为适合传输的格式(如H.264)。

- 传输:通过UDP/TCP协议发送数据包。

- 解码:接收端解压缩数据并还原画面/声音。

- 渲染:将解码后的数据输出到屏幕和扬声器。

关键技术点

| 技术模块 | 功能描述 | 常用方案 |

|---|---|---|

| 音视频采集 | 获取设备音视频流 | CameraX、MediaRecorder |

| 编码/解码 | 数据压缩与解压缩 | MediaCodec(硬编解码) |

| 网络传输 | 数据包分发与接收 | UDP(低延迟)、WebRTC |

| 渲染播放 | 解码后数据输出 | ExoPlayer、SurfaceView |

实现步骤与代码结构

环境准备

- 依赖配置:

- 添加

CameraX库(摄像头采集)。 - 集成

ExoPlayer(视频渲染)。 - 使用

MediaCodec(硬件编码H.264)。 - 网络层可选

WebRTC(简化信令和NAT穿透)或DatagramSocket(UDP传输)。

- 添加

核心模块设计

// 伪代码结构示例

public class VideoCommunicator {

private CameraProvider camera; // 摄像头采集

private MediaCodec encoder; // 视频编码器

private DatagramSocket socket; // UDP传输

private ExoPlayer player; // 视频播放器

public void startCommunication(String targetIP, int port) {

initCamera();

initEncoder();

startNetwork(targetIP, port);

}

}关键代码片段

(1)摄像头初始化与数据采集

// 使用CameraX采集预览数据

CameraSelector lensFacing = new CameraSelector.Builder()

.requireLensFacing(CameraSelector.LENS_FACING_FRONT)

.build();

cameraProviderFuture = ProcessCameraProvider.getInstance(context);

cameraProviderFuture.addListener(() -> {

Camera camera = cameraProviderFuture.get().bindToLifecycle(this, lensFacing, preview);

}, ContextCompat.getMainExecutor(this));(2)H.264硬件编码

// 配置MediaCodec为H.264编码器 MediaFormat format = MediaFormat.createVideoFormat(MediaFormat.MIMETYPE_VIDEO_AVC, width, height); format.setInteger(MediaFormat.KEY_COLOR_FORMAT, MediaCodecInfo.CodecCapabilities.COLOR_FormatSurface); format.setInteger(MediaFormat.KEY_BIT_RATE, 1500_000); // 1.5Mbps format.setInteger(MediaFormat.KEY_FRAME_RATE, 25); // 25fps encoder = MediaCodec.createEncoderByType(MediaFormat.MIMETYPE_VIDEO_AVC); encoder.configure(format, null, null, MediaCodec.CONFIGURE_FLAG_ENCODE);

(3)UDP数据包发送

// 发送编码后的视频帧

byte[] buffer = new byte[1024 64]; // 64KB缓冲区

DatagramPacket packet = new DatagramPacket(buffer, buffer.length, targetAddress, targetPort);

encoder.start();

while (isRunning) {

MediaCodec.BufferInfo info = new MediaCodec.BufferInfo();

int outputIndex = encoder.dequeueOutputBuffer(info, TIMEOUT_USEC);

if (outputIndex >= 0) {

ByteBuffer encodedData = encoder.getOutputBuffer(outputIndex);

packet.setData(encodedData.array(), info.offset, info.size);

socket.send(packet); // 发送UDP包

encoder.releaseOutputBuffer(outputIndex, false);

}

}常见问题与解决方案

延迟过高或卡顿

| 原因 | 解决方案 |

|---|---|

| 编码效率低(软编码) | 启用MediaCodec硬件编码,优先选择H.264格式。 |

| 网络带宽不足 | 降低视频分辨率(如720p→480p)或帧率(25fps→15fps)。 |

| 缓冲区设置不合理 | 调整MediaCodec的BUFFER_SIZE,优化UDP包大小(建议1-10KB)。 |

音视频不同步

- 原因:音视频数据时间戳未对齐。

- 解决方案:

- 在编码时为每帧添加

MediaCodec.BufferInfo时间戳。 - 接收端按时间戳排序后再渲染。

- 在编码时为每帧添加

测试与调试

测试环境搭建

- 设备要求:两台安卓设备(或模拟器)处于同一局域网。

- 步骤:

- 固定一台设备为服务器(监听端口),另一台为客户端(主动连接)。

- 使用

adb shell命令查看设备IP地址(如168.1.100:8080)。 - 在客户端设置目标IP和端口,启动通信。

抓包分析工具

- Wireshark:监听UDP流量,验证数据包是否准确发送。

- 命令行工具:

tcpdump捕获设备网络包。

相关问题与解答

问题1:如何优化视频传输的流畅度?

解答:

- 降低编码复杂度:使用

MediaCodec的HEVC(H.265)替代H.264,减少码率。 - 动态调整分辨率:根据网络带宽动态切换分辨率(如1080p→720p)。

- 跳帧策略:在网络拥堵时丢弃非关键帧(B帧),优先传输I帧。

问题2:如何实现多设备同时观看同一视频流?

解答:

- 组播传输:使用UDP组播(如

0.0.1:8080),所有设备加入同一组播组。 - 转发架构:一台设备作为服务器,其他设备作为客户端,服务器转发同一流数据。

- WebRTC扩展:利用

WebRTC的SFU(多点分发单元)模式支持多