光学计算深度学习

- 行业动态

- 2025-04-22

- 2

光学计算与深度学习融合,利用光并行处理加速神经网络运算,突破传统电子计算能效

技术原理

光学计算与深度学习的结合

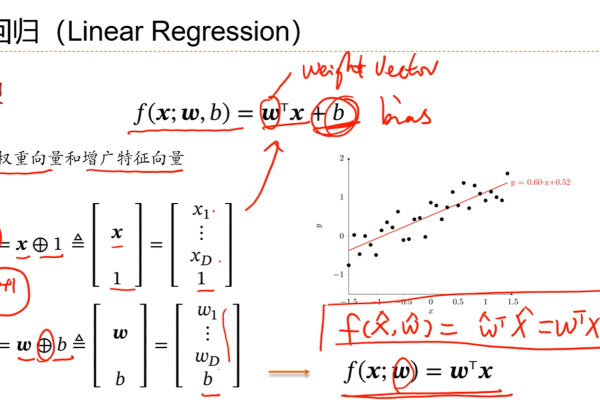

光学计算利用光的物理特性(如干涉、衍射、偏振)进行信息处理,具有高并行性和低能耗的特点,深度学习依赖大量矩阵运算,而光学计算天然适合处理此类计算任务,两者结合的核心思路是:

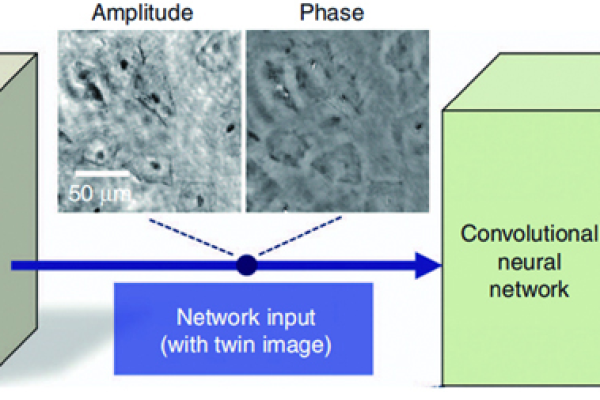

- 光信号替代电信号:通过光电转换将神经网络输入编码为光强、相位或偏振态,利用光学系统(如透镜、波导、非线性材料)完成矩阵乘法或卷积操作。

- 物理层加速:光的波动性允许单次操作处理整个向量或张量,突破电子电路的串行瓶颈,光学卷积层可通过透镜的傅里叶变换特性直接实现。

关键器件与系统

| 器件类型 | 功能 | 示例 |

|---|---|---|

| 光子晶体芯片 | 调控光路、实现权重调制 | 硅基光子晶体波导 |

| 空间光调制器(SLM) | 动态调整光场分布 | 液晶SLM、数字微镜器件(DMD) |

| 非线性光学材料 | 实现光-光相互作用(如激活函数) | 铌酸锂(LiNbO₃)、石墨烯 |

| 光电探测器 | 光信号转电信号 | 单光子雪崩二极管(SPAD) |

核心优势

- 超高并行度:光波前向传播时可同时处理所有像素,理论上加速比随问题规模指数级增长。

- 低功耗:光计算无电容充放电开销,单次运算能耗仅为电子计算的千分之一。

- 抗电磁干扰:光信号传输不受电磁场影响,适合高辐射环境(如航天、核工业)。

典型应用场景

| 场景 | 需求 | 光学计算方案 |

|---|---|---|

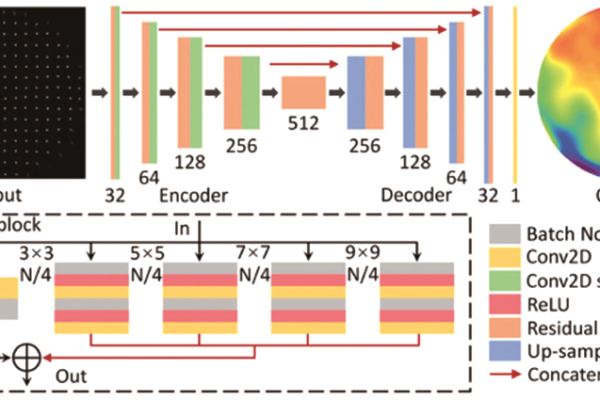

| 云端AI推理 | 低延迟、高吞吐量 | 基于SLM的光学卷积加速器 |

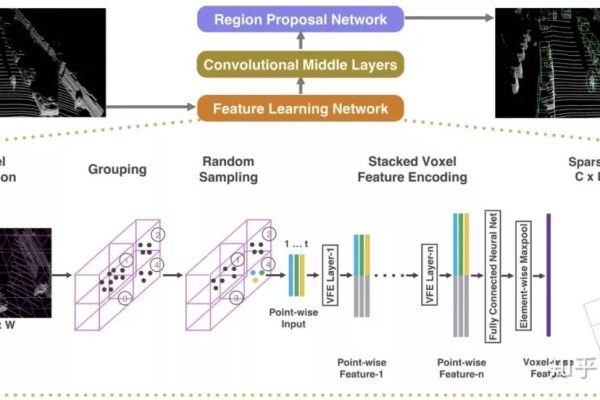

| 边缘设备(自动驾驶) | 低功耗、小型化 | 光子晶体集成光路+CMOS混合芯片 |

| 科学计算(气候建模) | 大规模矩阵运算 | 自由空间光学系统(如光学傅里叶变换) |

技术挑战

- 器件集成难度:光学元件(如透镜、波导)与CMOS工艺不兼容,导致封装成本高。

- 动态范围限制:光强受物理约束,难以表达极端值(如ReLU激活函数的陡峭梯度)。

- 误差累积:光路中的散射、衰减会降低计算精度,需依赖纠错算法补偿。

问题与解答

问题1:光学计算如何提升深度学习模型的推理速度?

解答:光学计算通过物理并行性加速矩阵运算,二维光场可直接映射为神经网络的权重矩阵,单次光传播完成整个矩阵-向量乘法,而电子计算需逐行扫描,以1024维向量计算为例,光学系统仅需一次光传播时间(约纳秒级),而GPU需数千个时钟周期。

问题2:当前光学计算深度学习的主要瓶颈是什么?如何突破?

解答:

- 瓶颈:器件集成度低(光元件与电子电路异构)、动态范围不足(光强受限)、算法适配性差(传统模型未针对光学特性优化)。

- 突破方向:

- 异质集成技术:开发光子-电子联合封装工艺(如3D堆叠芯片)。

- 动态范围增强:采用多波长编码或非线性光学效应扩展光强表达范围。

- 算法-硬件协同设计:设计适配光学特性的神经网络(如稀疏连接、模拟权重