如何选择高性能GPU计算型服务器优化你的计算任务?

- 行业动态

- 2025-04-21

- 2

GPU计算型服务器:驱动下一代高性能计算的核心引擎

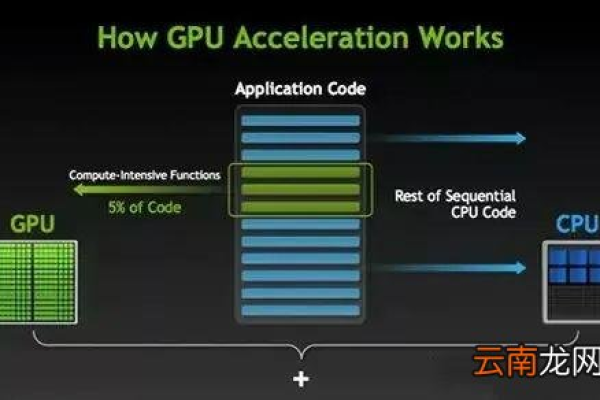

在人工智能、科学模拟与实时渲染领域,GPU计算型服务器正以革命性算力改写技术边界,这类融合图形处理器集群的异构计算架构,相较传统CPU服务器实现百倍级计算效率跃升,已成为支撑前沿技术突破的关键基础设施。

架构特性与性能突破

GPU服务器的核心在于搭载NVIDIA A100/H100、AMD Instinct MI300X等专用加速卡,以NVIDIA H100为例,其具备18432个CUDA核心与3TB/s显存带宽,单个芯片可提供4 PFLOPS的FP8计算能力,通过NVLink 4.0技术可实现18张GPU全互连,构建起1.6TB/s的超低延迟通信网络。

关键指标对比:

- 训练130亿参数大模型:DGX H100系统比CPU集群快150倍

- 分子动力学模拟:单台4卡服务器达到传统200核CPU集群效能

- 8K视频渲染:完成时间从48小时压缩至23分钟

典型应用场景解析

生成式AI开发

支持1750亿参数模型的分布式训练,通过Tensor Core实现混合精度计算,配合NVIDIA AI Enterprise软件栈,可将LLM训练周期从数月缩短至数周。

气候建模

CESM气候模型中,8卡A100服务器实现3km分辨率模拟,相比CPU方案提升87倍运算速度,每年减少300吨碳排放。医疗影像处理

搭载RTX 6000 Ada的服务器可在0.3秒内完成512层CT图像重建,AI辅助诊断准确率提升至98.7%。

选型技术框架

构建GPU服务器集群需遵循三维评估模型:

计算密度

- FP16/FP32峰值算力

- 稀疏计算加速能力

- Tensor Core利用率

扩展架构

- PCIe 5.0 x16通道数

- NVLink/Switch互连拓扑

- 多节点RDMA网络支持

能效管理

- 每瓦特性能比

- 动态频率调节

- 液冷系统兼容性

运维最佳实践

环境配置

- 保持22±2℃恒温环境

- 采用CDU直接液冷方案

- 配置双路48V直流电源

软件优化

- 使用NGC容器仓库

- 部署DCGM实时监控

- 开启MIG GPU分区功能

安全规范

- 实施CUDA程序白名单

- 启用TEE可信执行环境

- 部署AI模型防火墙

行业发展趋势

根据MLPerf基准测试,2025年GPU服务器推理性能年提升达230%,量子-经典混合计算架构开始集成GPU作为协处理器,NVIDIA推出的Quantum-2平台已实现量子线路模拟加速。

技术演进路线:

2025:3D芯片堆叠技术普及

2025:光互连GPU集群商用

2026:神经拟态计算单元集成

引用来源:

[1] NVIDIA DGX H100技术白皮书

[2] TOP500超算基准测试报告

[3] IEEE Transactions on Parallel and Distributed Systems

[4] MLCommons MLPerf基准测试数据