服务器同时访问

- 行业动态

- 2025-04-09

- 1

服务器同时访问指的是多个客户端或用户在同一时间段内对

服务器发起请求,进行数据交互或资源获取。这要求服务器具备高并发处理能力,以保障响应速度和服务质量。

服务器同时访问的详细说明

一、概念理解

服务器同时访问是指多个客户端在同一时刻向服务器发起请求,以获取数据或使用服务的情况,在现代网络环境中,这是非常常见的现象,例如热门网站在高峰时段会面临大量用户的同时访问。

二、影响因素

| 影响因素 | 说明 |

| 服务器硬件配置 | 包括 CPU、内存、磁盘 I/O 等,高性能的硬件可以处理更多的并发请求,多核 CPU 能够同时处理多个任务,大容量内存可以存储更多的数据和运行更多的程序,快速的磁盘 I/O 可以加快数据的读写速度。 |

| 服务器软件优化 | 如操作系统、Web 服务器软件等的设置和配置,合理的软件配置可以提高服务器的处理效率,调整操作系统的文件缓存大小、优化 Web 服务器的线程池等。 |

| 网络带宽 | 足够的网络带宽可以保证数据在客户端和服务器之间快速传输,如果网络带宽不足,会导致数据传输延迟,影响访问速度。 |

| 应用程序设计 | 高效的应用程序代码可以减少服务器的负载,采用异步编程、缓存技术等。 |

三、可能产生的问题

| 问题 | 表现 |

| 响应时间延长 | 由于大量请求同时到达,服务器处理每个请求的时间可能会变长,导致客户端等待时间增加。 |

| 服务器过载 | 当同时访问量超过服务器的承受能力时,服务器可能会出现性能下降、甚至崩溃的情况,CPU 使用率达到 100%、内存耗尽等。 |

| 数据不一致 | 在高并发情况下,如果对数据的读写操作没有进行良好的控制,可能会导致数据的不一致,多个用户同时修改同一个数据记录。 |

四、解决方案

| 方案 | 具体措施 |

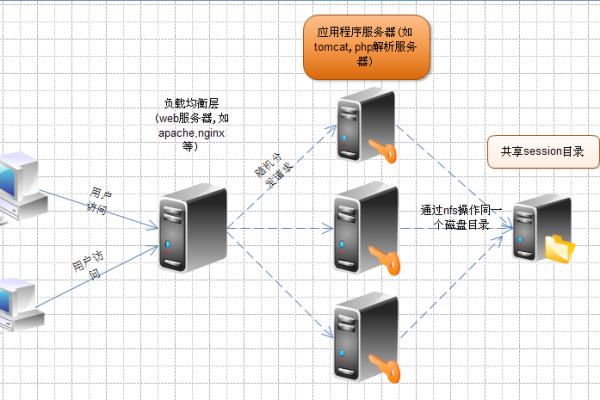

| 硬件升级 | 增加服务器的硬件资源,如添加 CPU、内存、硬盘等,也可以考虑采用集群技术,将多个服务器组成一个集群,共同处理请求。 |

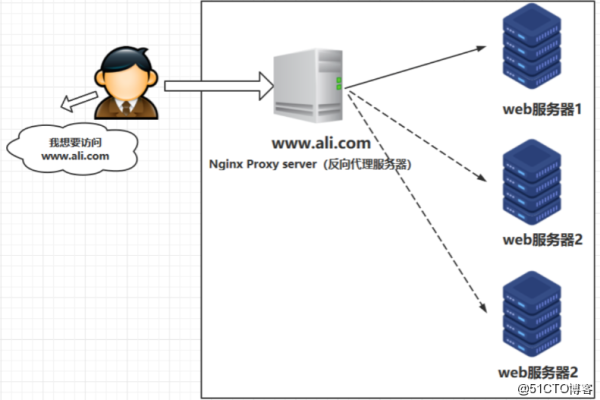

| 软件优化 | 对服务器软件进行性能调优,如优化数据库查询语句、调整服务器参数等,还可以采用负载均衡技术,将请求均匀地分配到多个服务器上。 |

| 网络优化 | 增加网络带宽,优化网络拓扑结构,减少网络延迟。 |

| 应用层优化 | 在应用程序中采用缓存技术,减少对服务器的重复请求,对应用程序进行性能测试和优化,提高其处理效率。 |

相关问题与解答

问题 1:如何判断服务器是否处于同时访问过载状态?

解答:可以通过监控服务器的各项性能指标来判断,如 CPU 使用率、内存使用率、磁盘 I/O 等,如果这些指标长时间处于较高水平,CPU 使用率持续超过 80%、内存使用率接近饱和,那么就可能存在服务器过载的情况,还可以观察服务器的响应时间,如果响应时间明显变长,也可能是由于过载导致的。

问题 2:负载均衡技术是如何实现服务器同时访问的压力分担的?

解答:负载均衡技术通过将客户端的请求按照一定的算法(如轮询、加权轮询、最小连接数等)分配到多个服务器上,轮询算法会依次将请求发送到不同的服务器,这样每个服务器都可以承担一部分请求压力,从而实现压力的分担,提高整个系统的处理能力和稳定性。