如何通过负载均衡原理优化服务器部署?

- 行业动态

- 2025-04-16

- 2

在当今互联网应用中,服务器的高效稳定运行是保障用户体验的关键。负载均衡技术作为服务器部署的核心策略之一,通过合理分配流量、优化资源利用率,显著提升了系统的可靠性和响应速度,以下内容将详细解析负载均衡的原理、实现方式及实际应用价值。

什么是负载均衡?

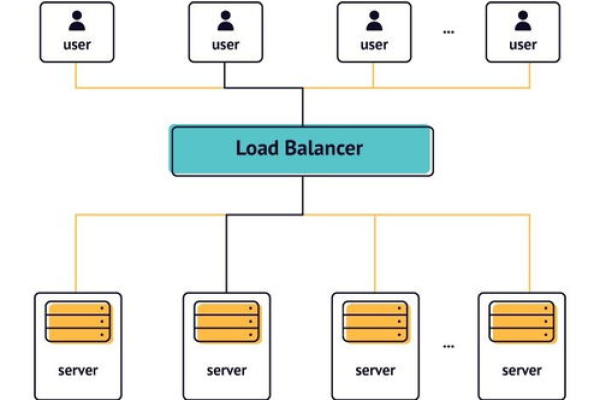

负载均衡(Load Balancing)是一种将网络请求或数据流量智能分发到多台服务器的技术,其核心目标是避免单一服务器因过载而崩溃,同时缩短用户请求的响应时间,当大量用户同时访问一个网站时,负载均衡设备会将请求按预设策略分配到不同的服务器节点,确保每台服务器的负载处于合理范围内。

负载均衡的核心原理

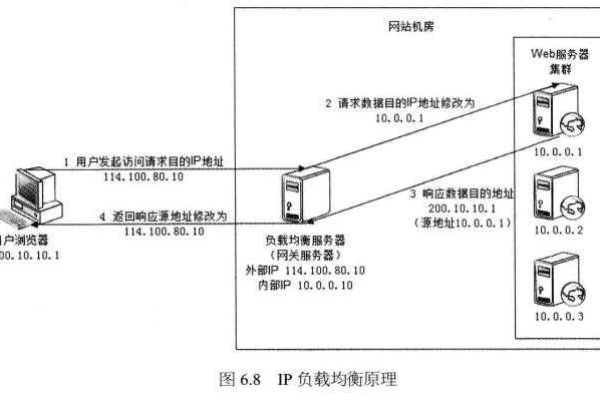

流量分发机制

负载均衡器根据算法(如轮询、加权轮询、最小连接数、IP哈希等)决定将请求发送到哪台服务器。- 轮询算法:按顺序将请求分配给每台服务器,适用于性能相近的服务器集群。

- 最小连接数:优先将请求分配给当前连接数最少的服务器,适合长连接场景(如即时通讯)。

健康检查与容灾

负载均衡器会定期检测后端服务器的运行状态(如CPU、内存、网络延迟),若某台服务器故障,流量会自动切换到其他正常节点,保障服务不中断。

会话保持(Session Persistence)

通过Cookie或IP绑定技术,确保同一用户的多次请求被分配到同一服务器,避免会话丢失(如购物车数据)。

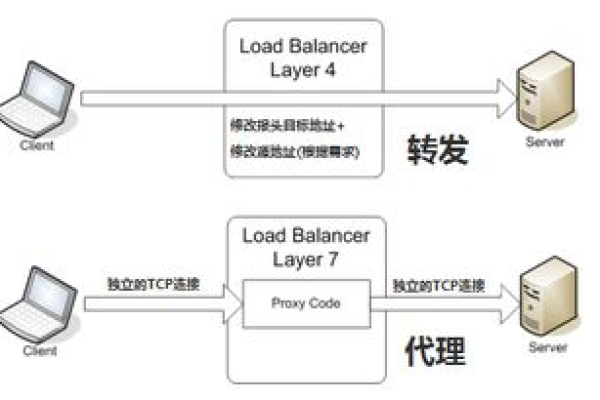

负载均衡的常见类型

硬件负载均衡

采用专用设备(如F5、A10),性能强、稳定性高,但成本昂贵,适合大型企业或金融级应用。软件负载均衡

基于开源工具(如Nginx、HAProxy)实现,部署灵活、成本低,适合中小型网站,Nginx可通过反向代理功能,轻松实现HTTP请求的分发。

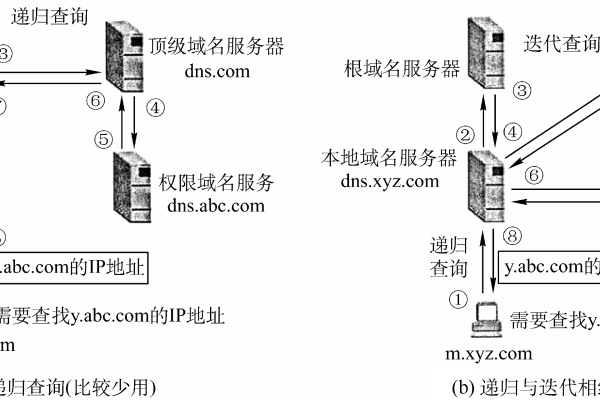

DNS负载均衡

通过域名解析将用户请求分配到不同IP地址的服务器,但存在缓存延迟问题,通常作为辅助方案。云服务负载均衡

主流云平台(如阿里云SLB、AWS ELB)提供的托管服务,支持自动扩缩容,与云服务器无缝集成。

负载均衡的应用场景

- 高并发网站:新闻门户、社交平台通过负载均衡应对突增流量。

- 电商大促:双十一期间,流量被均匀分配至数百台服务器,避免宕机。

- 游戏服务器:分区匹配玩家请求,降低延迟,提升游戏体验。

- 金融系统:保障交易服务的高可用性,避免单点故障导致数据丢失。

负载均衡的部署步骤

- 需求分析:评估业务流量峰值、服务器性能及冗余要求。

- 选择方案:根据预算和场景选择硬件、软件或云服务方案。

- 配置策略:设定分发算法、健康检查阈值和会话保持规则。

- 测试验证:模拟高并发场景,确保流量切换和容灾机制生效。

- 监控与优化:通过日志和性能监控工具(如Prometheus),持续调整参数以适配业务变化。

优化负载均衡的进阶策略

- 动态权重调整:根据服务器实时负载(如CPU使用率),动态分配流量权重。

- 基于地理位置的智能路由:将用户请求导向最近的机房,减少网络延迟。

- 安全防护集成:结合WAF(Web应用防火墙)防御DDoS攻击,过滤反面流量。

- 多维监控与分析:通过APM(应用性能管理)工具追踪请求链路,识别性能瓶颈。

负载均衡技术通过科学的流量管理与资源调度,成为现代服务器架构中不可或缺的一环,无论是初创企业还是大型平台,合理运用负载均衡方案均可显著提升服务的稳定性、扩展性与用户体验,随着云计算和AI技术的发展,未来负载均衡将更加智能化,为数字化业务提供坚实支撑。

参考文献

- Nginx官方文档 – 《HTTP Load Balancing》

- AWS白皮书 – 《弹性负载均衡最佳实践》

- 书籍《高性能网站构建实战》(人民邮电出版社)