GPU云计算架构核心技术解析与实战应用指南

- 行业动态

- 2025-04-15

- 2

GPU云计算架构通过整合图形处理器的高性能并行计算能力与云平台弹性资源,构建分布式计算系统,其核心依托虚拟化技术将物理GPU资源动态分配,支持多任务并发处理,适用于人工智能训练、科学仿真等计算密集型场景,实现算力资源的高效利用与按需扩展,显著降低硬件投入成本。

随着人工智能、大数据分析和科学计算的快速发展,GPU云计算架构逐渐成为支撑现代数字经济的核心技术之一,本文将从技术原理、核心优势、应用场景及未来趋势等角度,深入解析这一架构的底层逻辑与行业价值。

GPU云计算架构的核心组成

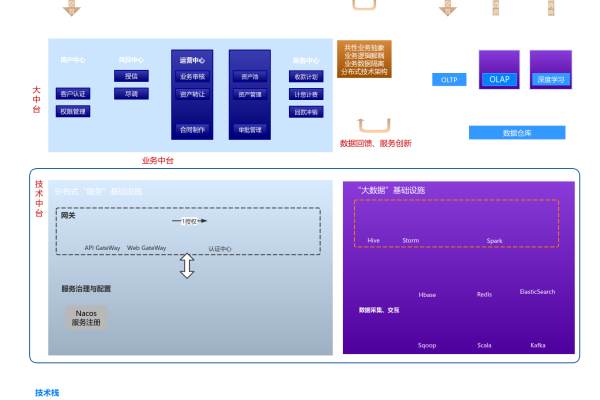

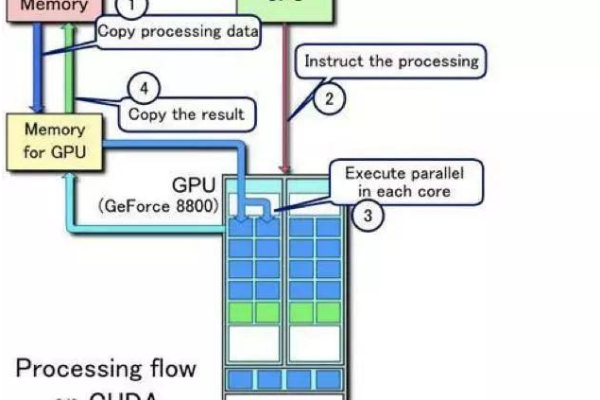

GPU(图形处理器)云计算架构以高性能并行计算为核心,通过云服务模式提供弹性算力,其技术栈包含以下关键模块:

硬件层

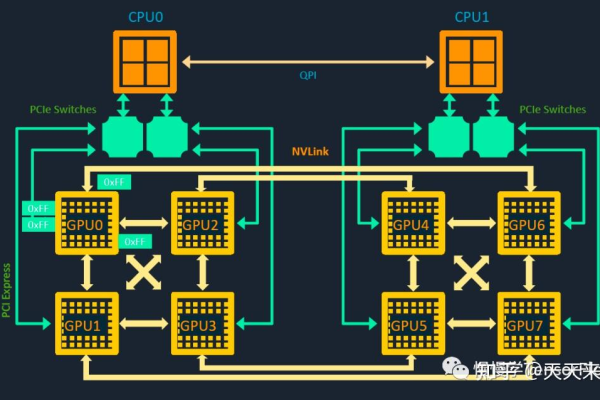

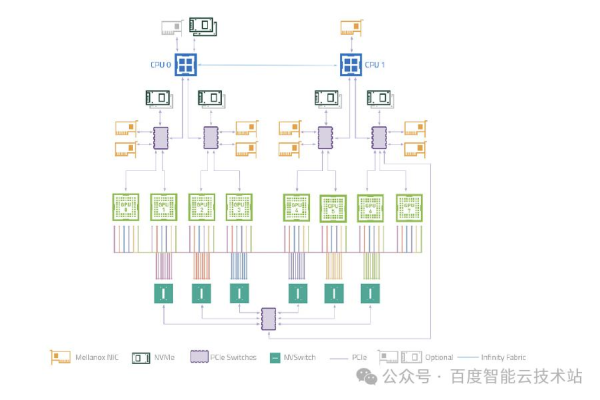

- 采用NVIDIA A100、H100或AMD Instinct系列等专用GPU芯片,支持CUDA、ROCm并行计算框架。

- 通过NVLink或InfiniBand实现多GPU高速互联,单集群算力可达PFLOPS(每秒千万亿次浮点运算)。

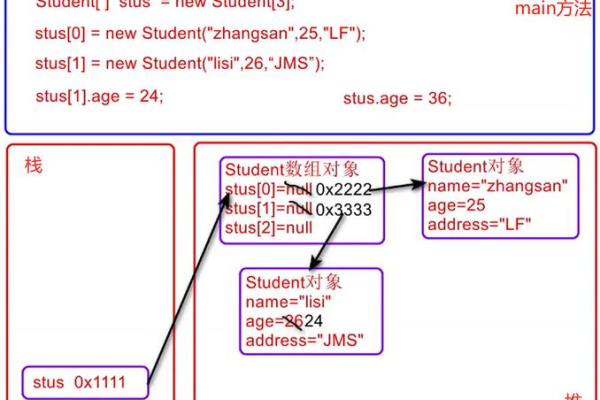

虚拟化层

- 基于KVM、Xen等虚拟化技术,结合NVIDIA vGPU或MxGPU实现GPU资源分片。

- 支持动态分配算力,例如将一块物理GPU分割为多个虚拟实例,供不同租户使用。

分布式计算框架

- 集成Kubernetes、Apache Spark等调度工具,优化任务分配与负载均衡。

- 利用Horovod、NCCL库加速多节点训练,降低跨服务器通信延迟。

云管理平台

提供自动化部署、监控告警及计费系统,如AWS EC2 GPU实例、阿里云GN6系列。

GPU云架构的四大技术优势

| 优势 | 说明 | 典型场景 |

|---|---|---|

| 高性能计算 | 单GPU提供数千计算核心,并行处理能力比CPU提升10-50倍 | AI模型训练、流体力学仿真 |

| 弹性扩展 | 按需分钟级扩容千卡集群,成本降低40%-70% | 双十一实时推荐系统 |

| 成本优化 | 采用竞价实例或混合云模式,闲置资源利用率提升至90% | 中小型企业AI开发 |

| 生态支持 | 兼容TensorFlow、PyTorch等主流框架,预装优化镜像 | 科研机构算法研究 |

行业应用场景与案例

AI模型训练

- OpenAI训练GPT-4时采用微软Azure NDm A100 v4集群,单任务调用数千GPU,将训练周期从数月缩短至数周。

- 自动驾驶公司Waymo利用GPU云模拟百万公里道路场景,算力成本降低60%。

科学计算

欧洲气象中心使用GPU云进行气候建模,1小时完成传统超算6小时的任务。

实时图形渲染

影视公司通过云GPU集群渲染《阿凡达2》,渲染农场规模缩小80%。

挑战与未来演进方向

现存挑战

- 硬件成本:A100 GPU单价超1万美元,中小用户门槛较高

- 网络瓶颈:跨区域数据传输延迟影响分布式训练效率

- 软件生态:部分传统行业应用尚未适配GPU加速

技术趋势

- 异构计算:GPU+DPU+Quantum计算混合架构(如NVIDIA Grace Hopper)

- 绿色算力:液冷技术降低PUE至1.1以下(阿里云杭州数据中心案例)

- 算法优化:Megatron-Turing NLG模型实现1750亿参数训练效率提升3倍

GPU云计算架构正在重塑算力供给模式,根据IDC预测,2025年全球GPU云服务市场规模将突破800亿美元,年复合增长率达32.6%,企业需结合业务需求选择公有云、混合云或专属集群方案,同时关注MaaS(Model as a Service)等新兴服务形态。

参考文献

- NVIDIA技术白皮书《Accelerated Computing in the Cloud》

- Gartner报告《Hype Cycle for Cloud Computing, 2024》

- IDC市场分析《Global GPU Cloud Infrastructure Forecast》

- AWS官方文档《Best Practices for GPU Optimization》

- OpenAI研究论文《Scaling Laws for Neural Language Models》