如何在MapReduce中加载词典?

- 行业动态

- 2024-12-30

- 4310

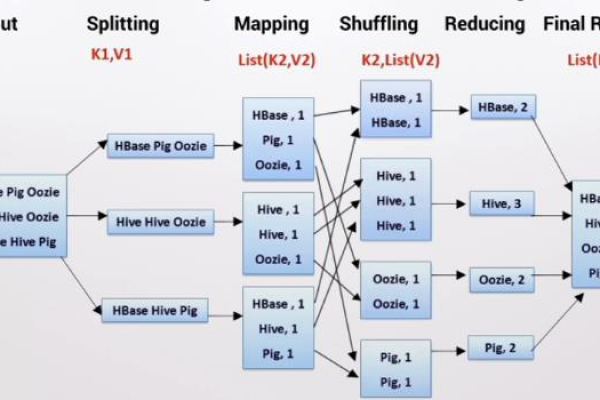

mapreduce 是一种编程模型,用于处理和生成大数据集。加载词典是 mapreduce 作业的一部分,可以通过将词典文件放入 hadoop 分布式文件系统 (hdfs) 中,然后在 mapreduce 程序中引用该文件来实现。在 mapreduce 程序中,可以使用 hadoop 的 filesplit 类来读取词典文件,并将其分发给各个 map 任务进行处理。

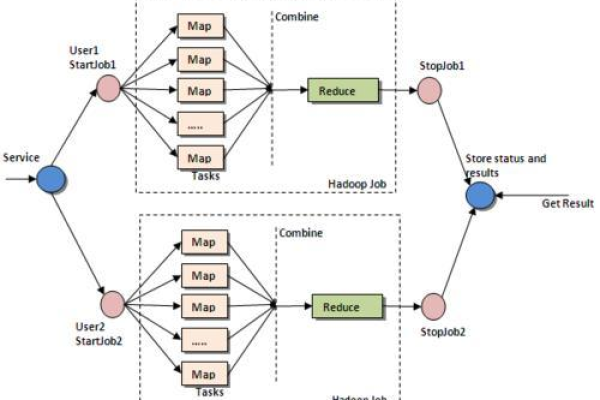

MapReduce是一种面向大数据并行处理的计算模型,它通过将大规模数据集的操作分发给集群中的每个节点来实现可靠性和高效性,在实际应用中,MapReduce常用于处理海量数据,如文本处理、图形处理等,加载词典是MapReduce任务中的一个关键环节,尤其是在进行自然语言处理(NLP)时,词典的加载和管理尤为重要。

一、MapReduce与词典加载的基本概念

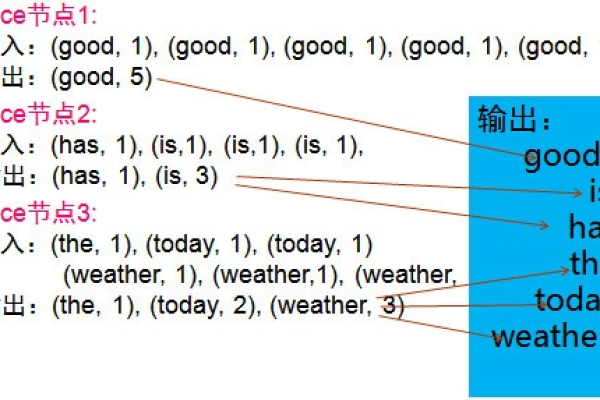

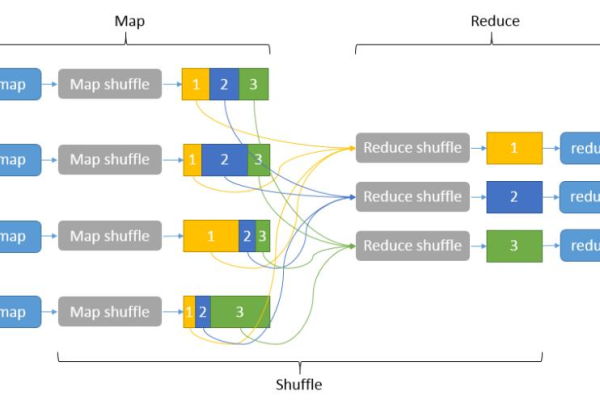

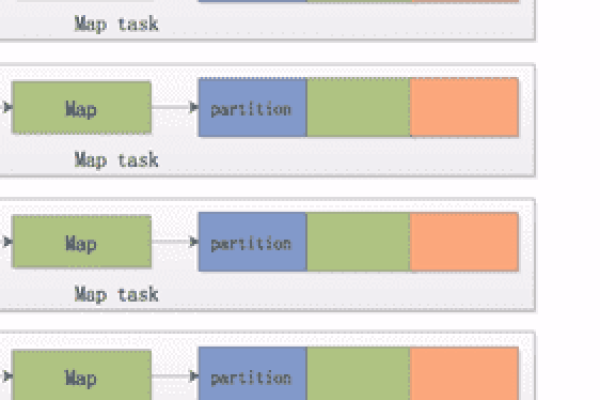

MapReduce框架由Google公司提出,主要用于处理大规模数据集的并行运算问题,它包括两个主要阶段:Map阶段和Reduce阶段,在Map阶段,输入数据被分解成多个小片段,并由不同的节点并行处理;在Reduce阶段,这些处理结果被汇总和整合。

词典加载则是在MapReduce任务开始前,将所需的词典文件加载到内存或分布式存储中,以便在Map和Reduce过程中快速访问,词典通常包含了大量的词汇及其相关的属性(如词频、词义等),是NLP任务中不可或缺的资源。

二、MapReduce加载词典的方法

1、本地加载:在单机模式下,可以直接将词典文件加载到内存中,这种方法适用于小规模数据集或测试环境,在大规模集群环境中,由于内存限制和网络传输开销,本地加载可能不是最佳选择。

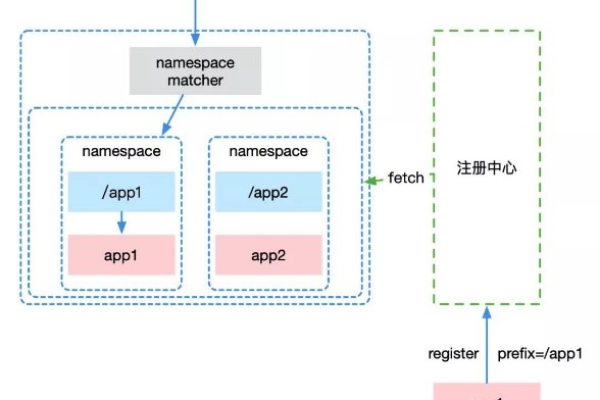

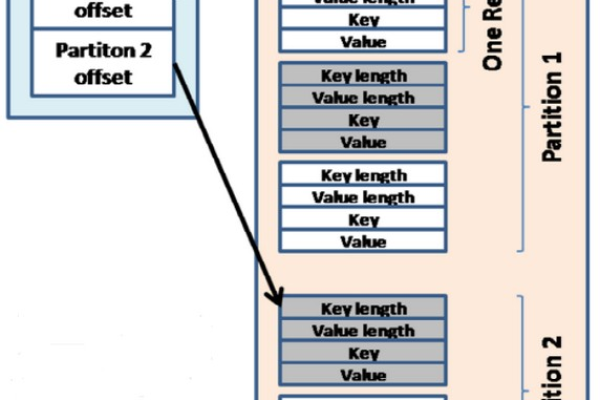

2、分布式加载:在MapReduce框架下,可以将词典文件存储在分布式文件系统(如HDFS)中,并在任务启动时将其加载到各个节点的内存或本地存储中,这样可以实现词典的共享和快速访问,具体步骤如下:

将词典文件上传到HDFS。

在MapReduce任务的配置阶段,指定词典文件的路径。

在任务执行前,通过自定义的InputFormat或Mapper类来加载词典文件。

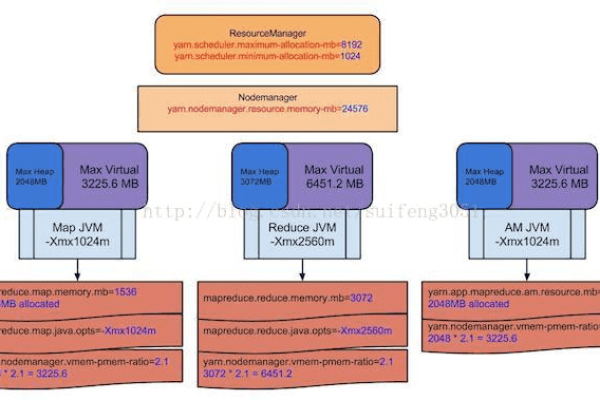

3、缓存机制:为了提高词典加载的效率,可以采用缓存机制,在任务执行前,先将词典文件缓存到各个节点的本地磁盘上,然后在任务执行过程中直接从本地磁盘读取词典数据,这样可以大大减少网络传输的开销。

三、MapReduce加载词典的注意事项

1、词典文件的大小:词典文件通常较大,因此在加载时需要考虑内存和存储的限制,如果词典文件过大,可以考虑将其拆分成多个小文件进行加载。

2、词典文件的更新:在实际应用中,词典文件可能需要定期更新,在设计MapReduce任务时,需要考虑词典文件的动态更新机制,可以设置定时任务来检查词典文件的更新情况,并在必要时重新加载词典。

3、错误处理:在加载词典的过程中,可能会遇到各种错误(如文件不存在、格式错误等),需要设计合理的错误处理机制来确保任务的稳定性和可靠性。

四、MapReduce加载词典的实践案例

以下是一个使用Hadoop MapReduce框架加载词典并进行文本处理的简单示例:

1、将词典文件上传到HDFS:

hadoop fs -put /path/to/dictionary.txt /user/hadoop/dictionary/

2、编写Mapper类来加载词典并进行文本处理:

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

import java.io.BufferedReader;

import java.io.InputStreamReader;

import java.util.HashMap;

import java.util.Map;

public class DictionaryMapper extends Mapper<LongWritable, Text, Text, LongWritable> {

private Map<String, Integer> dictionary = new HashMap<>();

@Override

protected void setup(Context context) throws IOException, InterruptedException {

// 加载词典文件

BufferedReader br = new BufferedReader(new InputStreamReader(context.getConfiguration().get("dictionary.file")));

String line;

while ((line = br.readLine()) != null) {

String[] parts = line.split("t");

if (parts.length == 2) {

dictionary.put(parts[0], Integer.parseInt(parts[1]));

}

}

br.close();

}

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

String[] words = value.toString().split("\s+");

for (String word : words) {

if (dictionary.containsKey(word)) {

context.write(new Text(word), new LongWritable(dictionary.get(word)));

}

}

}

}3、配置并运行MapReduce任务:

<!-mapred-site.xml -->

<configuration>

<property>

<name>dictionary.file</name>

<value>hdfs:///user/hadoop/dictionary/dictionary.txt</value>

</property>

</configuration>hadoop jar my-mapreduce-job.jar com.example.DictionaryMapper /input/path /output/path

五、FAQs

Q1: MapReduce加载词典时如何优化性能?

A1: 可以通过以下几种方式优化性能:一是使用分布式文件系统(如HDFS)存储词典文件,以减少网络传输开销;二是采用缓存机制,将词典文件缓存到本地磁盘上;三是对词典文件进行压缩和索引,以提高加载速度和查询效率。

Q2: 如果词典文件很大,无法一次性加载到内存中怎么办?

A2: 如果词典文件很大,可以考虑将其拆分成多个小文件进行加载,也可以尝试使用外部存储系统(如Redis、Memcached等)来存储和管理词典数据,以便在需要时进行快速访问和查询。

Q3: MapReduce任务执行过程中如何更新词典文件?

A3: 在MapReduce任务执行过程中更新词典文件是一个比较复杂的问题,一种可能的解决方案是设置定时任务来检查词典文件的更新情况,并在必要时重新加载词典,也可以考虑使用版本控制系统来管理词典文件的不同版本,以便在需要时进行回滚或升级。

六、小编有话说

MapReduce作为一种强大的大数据处理框架,为处理海量数据提供了有效的解决方案,在实际应用中,加载词典是MapReduce任务中的一个重要环节,它直接影响到任务的性能和效果,我们需要根据具体情况选择合适的加载方法和优化策略,以确保任务的稳定性和可靠性,我们也需要不断学习和探索新的技术和方法,以应对日益复杂的数据处理需求。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:https://www.xixizhuji.com/fuzhu/377941.html