如何从MySQL数据源中获取数据进行分析?

- 行业动态

- 2024-12-28

- 2890

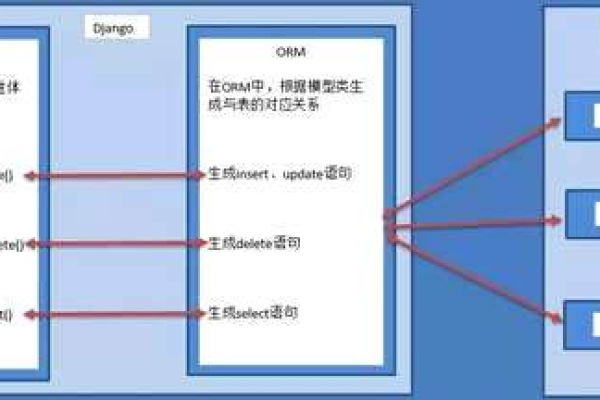

MySQL中,使用SELECT语句从数据源获取数据进行分析。

在现代数据驱动的世界中,从MySQL数据库中获取数据并进行深入分析是许多业务决策过程中不可或缺的一环,MySQL作为一种广泛使用的开源关系型数据库管理系统,因其高效、稳定和易于使用而受到众多企业和开发者的青睐,本文将详细介绍如何从MySQL数据源中获取数据,并探讨几种常见的数据分析方法。

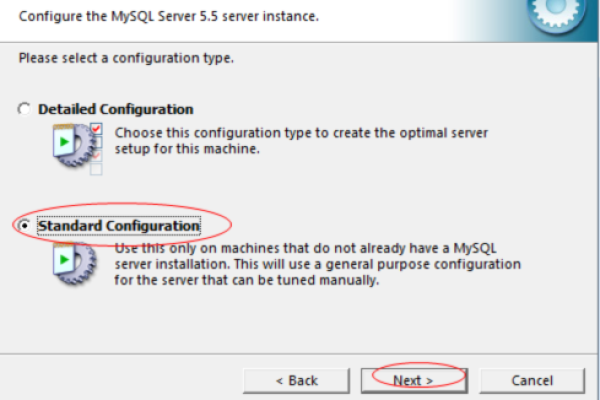

一、连接MySQL数据库

我们需要建立与MySQL数据库的连接,这通常通过编程语言中的数据库连接库来实现,如Python中的mysql-connector-python或pymysql库,以下是一个使用Python和mysql-connector-python库连接MySQL数据库的示例代码:

import mysql.connector

配置数据库连接参数

config = {

'user': 'your_username',

'password': 'your_password',

'host': '127.0.0.1',

'database': 'your_database',

'raise_on_warnings': True

}

建立连接

cnx = mysql.connector.connect(**config)

cursor = cnx.cursor()

查询数据

query = "SELECT * FROM your_table"

cursor.execute(query)

获取所有行数据

rows = cursor.fetchall()

关闭连接

cursor.close()

cnx.close()

打印数据

for row in rows:

print(row)二、数据预处理

从数据库中获取的数据往往需要进行一定的预处理,以便更好地进行分析,预处理步骤可能包括数据清洗(去除重复值、处理缺失值)、数据转换(如日期格式转换、数值标准化)等,以下是一个简单的数据清洗示例,使用Pandas库来处理缺失值:

import pandas as pd

from sqlalchemy import create_engine

创建数据库引擎

engine = create_engine('mysql+mysqlconnector://your_username:your_password@127.0.0.1/your_database')

查询数据并加载到DataFrame中

df = pd.read_sql("SELECT * FROM your_table", engine)

数据清洗:去除重复值和处理缺失值

df.drop_duplicates(inplace=True)

df.fillna(method='ffill', inplace=True)

显示清洗后的数据

print(df.head())三、数据分析

一旦数据被成功获取并预处理,我们就可以开始进行数据分析了,数据分析可以包括但不限于描述性统计、趋势分析、关联规则挖掘等,以下是一些常见的数据分析方法和相应的Python代码示例:

1. 描述性统计分析

描述性统计分析可以帮助我们快速了解数据的基本情况,如均值、中位数、标准差等。

计算描述性统计量 descriptive_stats = df.describe() print(descriptive_stats)

2. 趋势分析

趋势分析可以帮助我们识别数据随时间的变化趋势,我们可以使用时间序列分析来预测未来的销售额。

import matplotlib.pyplot as plt

假设df有一个时间戳列'timestamp'和一个数值列'sales'

df['timestamp'] = pd.to_datetime(df['timestamp'])

df.set_index('timestamp', inplace=True)

绘制时间序列图

df['sales'].plot()

plt.title('Sales Trend Over Time')

plt.xlabel('Date')

plt.ylabel('Sales')

plt.show()3. 关联规则挖掘

关联规则挖掘可以帮助我们发现数据集中不同项之间的有趣关联,在零售行业中,我们可以使用Apriori算法来发现哪些商品经常一起被购买。

from mlxtend.frequent_patterns import apriori, association_rules

假设df有一个列'basket',其中包含了每个交易的商品列表(以字符串形式存储)

basket = df['basket'].apply(lambda x: x.split(','))

使用mlxtend进行关联规则挖掘

frequent_itemsets = apriori(basket, min_support=0.01, use_colnames=True)

rules = association_rules(frequent_itemsets, metric="lift", min_threshold=1)

print(rules[['antecedents', 'consequents', 'support', 'confidence', 'lift']])四、结果可视化与报告

数据分析的结果通常需要以直观的方式呈现给决策者或团队成员,数据可视化是实现这一目标的重要手段,我们可以使用Matplotlib、Seaborn、Plotly等库来创建各种图表和图形,以下是一个简单的柱状图示例,展示不同类别的销售情况:

import seaborn as sns

假设df有一个列'category'和一个列'sales'

sns.barplot(x='category', y='sales', data=df)

plt.title('Sales by Category')

plt.xlabel('Category')

plt.ylabel('Sales')

plt.show()五、FAQs

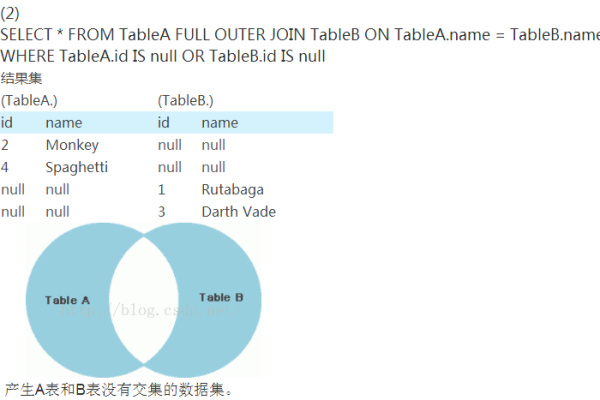

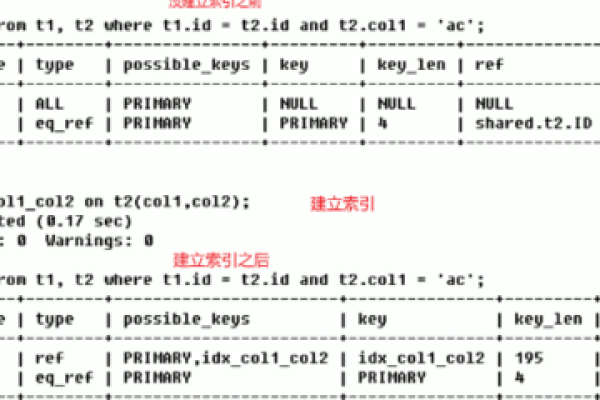

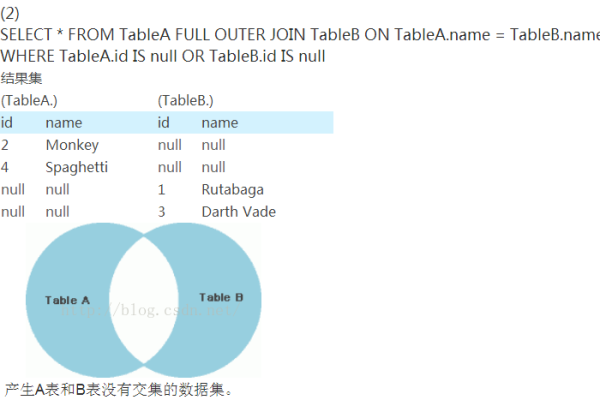

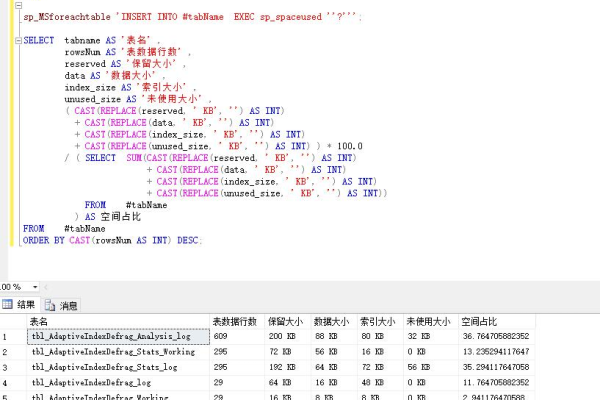

Q1: 如何优化MySQL查询以提高数据获取速度?

A1: 优化MySQL查询的方法有很多,包括但不限于以下几点:使用索引加快查询速度;避免在WHERE子句中使用SELECT *;尽量使用LIMIT限制返回的行数;对于大型数据集,可以考虑分页查询或使用游标逐步获取数据,定期对数据库进行维护,如重建索引、更新统计信息等,也有助于提高查询性能。

Q2: 在进行数据分析时,如何处理大量的缺失值?

A2: 处理大量缺失值的方法取决于具体的数据和分析需求,一种常见的方法是删除包含缺失值的行或列,但这可能会导致信息丢失,另一种方法是使用插值或填充技术来估计缺失值,如使用均值、中位数、众数或基于模型的预测值进行填充,在选择处理方法时,应考虑数据的分布特性和缺失值的原因,以确保分析结果的准确性和可靠性。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:https://www.xixizhuji.com/fuzhu/377414.html