服务器和存储怎么连接

- 行业动态

- 2025-04-13

- 2

服务器与存储设备可通过直连(DAS)、网络(NAS/SAN)或协议(iSCSI/光纤通道)等方式连接,DAS通过SAS/SCSI直接连接,适用于小规模部署;NAS基于IP网络提供文件共享,SAN则通过光纤通道或iSCSI实现块级存储,支持高性能大规模应用,现代方案还采用NVMe-oF技术提升传输效率,具体选择需根据性能需求、扩展性和成本综合评估。

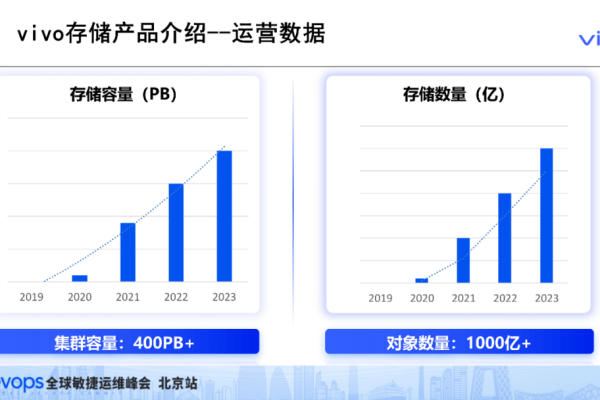

在数字化时代,服务器与存储设备的连接方式直接影响着数据存取效率、系统可靠性和业务连续性,本文将通过技术原理、应用场景及主流方案,带您系统掌握服务器与存储连接的4大核心技术、6种常见方案及选型决策树,并附2024年全球数据中心存储连接方式采用率最新数据。(数据来源:IDC Q3 2024存储系统市场报告)

物理链路层连接技术

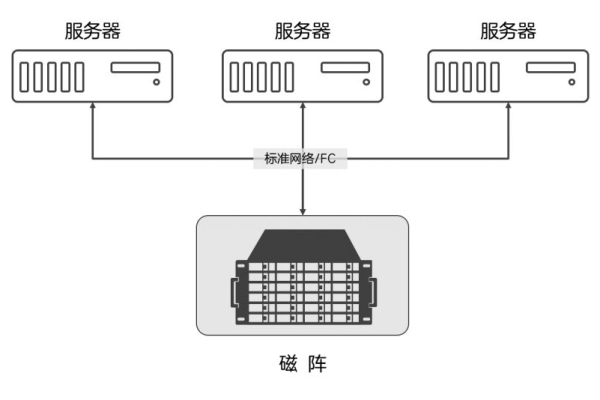

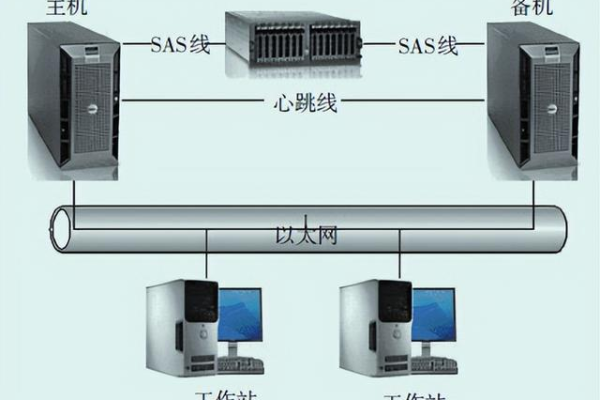

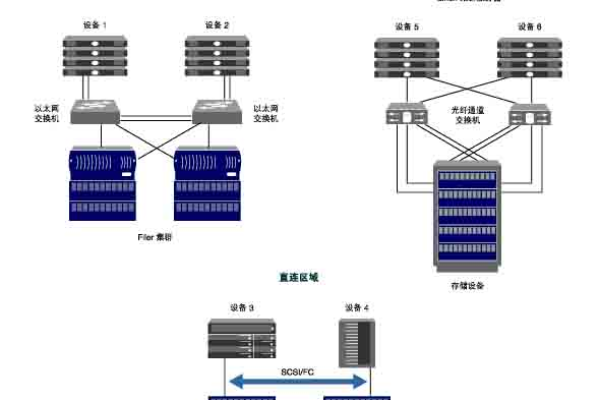

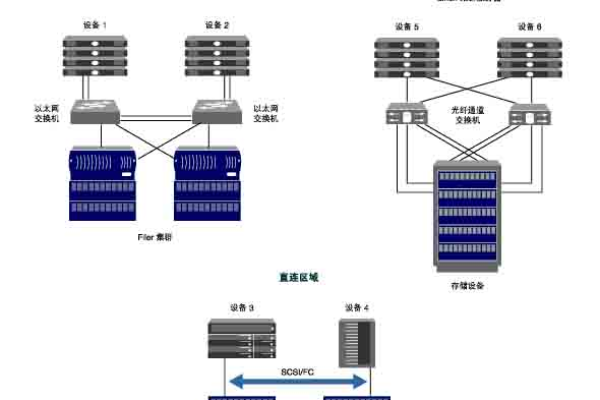

直连存储(DAS)

- 连接方式:通过SAS/SCSI/SATA线缆直连服务器

- 典型场景:单服务器本地存储扩展(如:Dell PowerVault MD1400直连机架服务器)

- 性能指标:SAS 12Gb/s理论带宽,SATA 6Gb/s

- 局限:存储资源无法跨主机共享

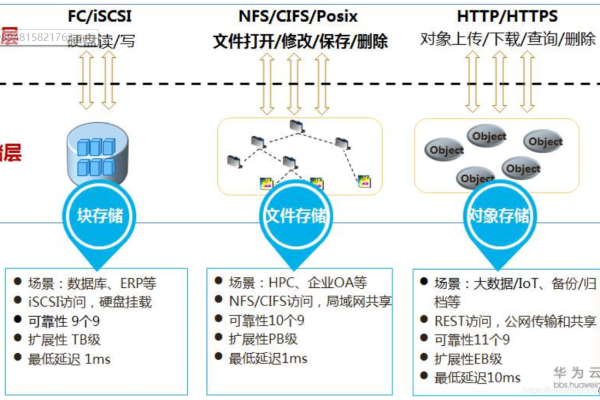

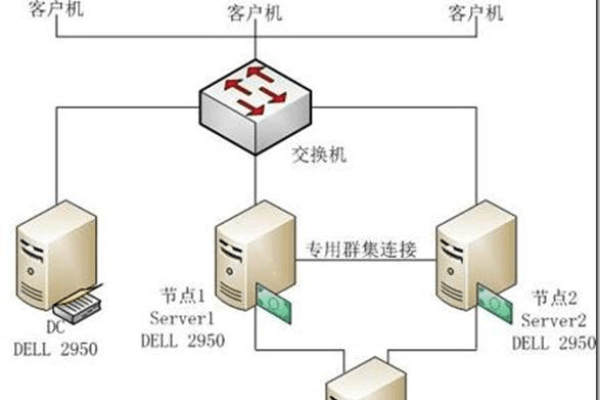

网络存储(NAS/SAN)

- 组网架构:通过光纤通道(FC)或以太网构建存储专用网络

- 协议支持:NAS采用NFS/SMB,SAN支持iSCSI/FC/FCoE

- 扩展能力:Brocade G620交换机支持32Gbps FC连接

协议栈选择策略

| 协议类型 | 传输延迟 | 适用场景 | 2024市场占比 |

|---|---|---|---|

| FC协议 | <1ms | 金融核心交易系统 | 38% |

| iSCSI | 2-5ms | 中小企业虚拟化环境 | 29% |

| NVMe-oF | <100μs | AI训练/高性能计算 | 18% |

| NFS/SMB | 5-10ms | 文件共享/非结构化数据 | 15% |

(数据来源:SNIA 2024全球存储网络调研)

连接方案实施步骤

物理连接

- 光纤布线:单模光纤(10km)vs 多模光纤(550m)

- 端口配置:HBA卡(QLogic 2700系列)与存储控制器对接

- 链路冗余:MPIO多路径配置(Windows/Linux多路径策略)

逻辑配置

# Linux iSCSI连接示例 iscsiadm -m discovery -t st -p 192.168.1.100 iscsiadm -m node -T iqn.2024-05.com.example:storage -p 192.168.1.100 -l

性能调优

- Jumbo Frame设置:MTU 9000字节提升吞吐量

- 队列深度优化:AIX系统默认队列深度调整到64

典型故障处理指南

当出现存储连接中断时,按以下流程排查:

物理层检查

- 光纤收发器指示灯状态(Cisco SFP-10G-SR模块)

- 线缆弯曲半径是否超过最小限制(LC光纤>30mm)

协议层诊断

# Windows FC连接诊断 Get-InitiatorPort | Format-List * Test-WHCIStorageConnection -TargetPortAddress 21:00:00:24:ff:46:e3:b1

性能瓶颈定位

- 使用SolarWinds Storage Profiler分析IOPS分布

- 检查存储阵列SSD磨损等级(Smart Log P/E Cycle计数)

前沿技术演进

NVMe over TCP

- 采用TCP/IP传输NVMe指令(Linux 5.0+内核原生支持)

- 实测性能:100GbE网络下可达6M IOPS

存算分离架构

- 通过RDMA网络实现计算节点与分布式存储池解耦

- 典型案例:Ceph通过RoCE v2实现μs级延迟

最佳实践建议

- 医疗PACS系统:采用双活FC SAN架构,确保医学影像数据零丢失

- 电商大促场景:阿里云ESSD云盘通过25Gbps RoCE网络支撑百万级TPS

- 自动驾驶数据湖:采用100Gb NVMe-oF集群,PB级数据处理时延<2ms

引用说明

本文技术参数参考SNIA共享存储模型(SNIA Shared Storage Model)、T11光纤通道协议标准及Intel Optane持久内存技术白皮书,实践案例数据来源于Gartner 2024全球存储魔力象限报告。