服务器支持的并发量

- 行业动态

- 2025-04-14

- 1

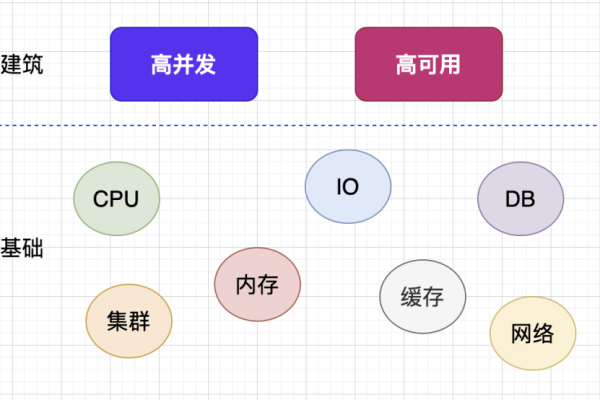

服务器支持的并发量指同一时间内能处理的请求数量,由硬件性能、软件架构及网络带宽等因素决定,高并发需优化代码、数据库设计和负载均衡策略,采用缓存、分布式系统等技术提升处理能力,确保系统稳定性和响应速度。

什么是并发量?

并发量指服务器在同一时间内能处理的有效请求数量,某服务器每秒可响应500个用户登录请求,其并发量为500,当超过这一阈值时,可能出现响应延迟、服务崩溃等问题。

影响并发量的核心因素

硬件性能

- CPU与内存:多核处理器和高频内存能加快任务处理速度。

- 网络带宽:带宽不足会导致数据传输拥堵,降低吞吐量。

- 磁盘I/O:SSD硬盘的读写速度远高于机械硬盘,适合高并发场景。

软件架构设计

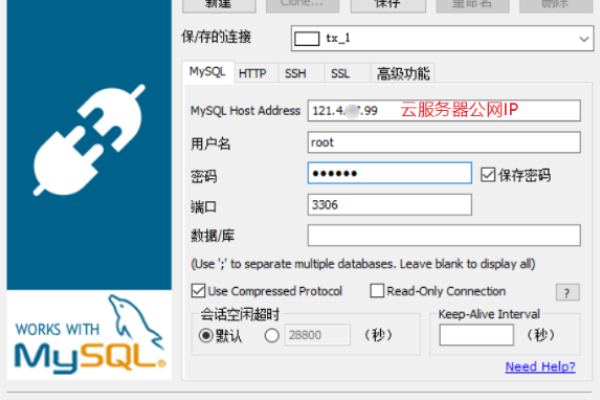

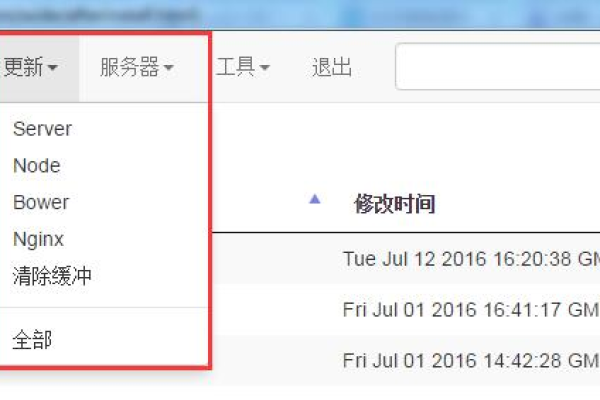

- 负载均衡:通过Nginx、HAProxy等工具分发请求,避免单节点过载。

- 数据库优化:使用缓存(如Redis)、分库分表、读写分离减少数据库压力。

- 异步处理:消息队列(如Kafka、RabbitMQ)解耦任务,提升响应效率。

代码质量

- 避免冗余计算、内存泄漏等问题,例如使用连接池管理数据库访问。

- 采用高效的算法和框架(如Node.js异步I/O、Golang协程)。

如何评估服务器并发能力?

压力测试工具

- Apache JMeter:模拟多用户请求,统计响应时间和错误率。

- LoadRunner:适用于复杂业务场景的全面测试。

- 测试指标:

- QPS(Query Per Second):每秒处理的请求数。

- TPS(Transaction Per Second):每秒完成的事务数。

- 响应时间:用户从发起请求到接收结果的时间。

真实场景推演

根据业务峰值(如双11促销)预估并发量,按1.5倍冗余设计系统。

提升并发量的实战方案

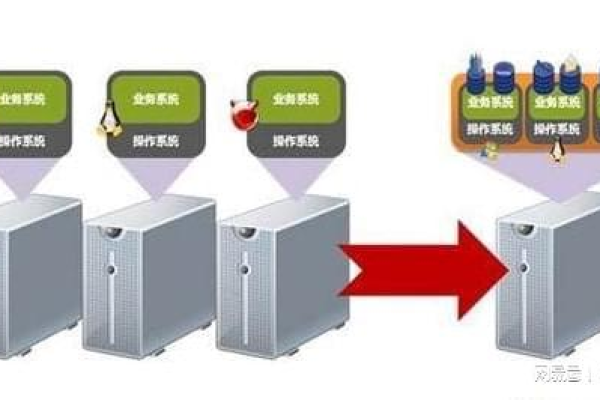

横向扩展(Scale-out)

- 通过增加服务器节点分散负载,云服务(如AWS Auto Scaling)支持弹性扩容。

- 微服务架构将系统拆分为独立模块,降低耦合度。

垂直优化(Scale-up)

- 升级单台服务器配置(如CPU从8核升至16核)。

- 使用更高效的编程语言(如C++替代Python处理计算密集型任务)。

缓存策略

- CDN加速:静态资源(图片、JS/CSS)分发至边缘节点。

- 本地缓存:Guava Cache或Memcached存储高频访问数据。

协议与连接优化

- 启用HTTP/2多路复用,减少TCP连接数。

- 设置合理的Keep-Alive超时时间,复用已有连接。

常见误区与避坑指南

盲目堆砌硬件

单纯增加服务器数量可能因架构不合理导致性能瓶颈转移(如数据库锁竞争)。

忽视慢查询优化

一条未加索引的SQL语句可能拖垮整个数据库,需定期分析慢日志。

低估突发流量

未配置自动扩容或降级策略时,流量洪峰易引发雪崩效应。

行业案例参考

- 电商瞬秒系统

采用Redis预扣库存、限流(令牌桶算法)、请求合并等技术,支撑百万级QPS。

- 直播平台弹幕

使用WebSocket长连接+消息队列,实现千万用户实时互动。

服务器并发量的优化需结合硬件、架构、代码多维度改进,并通过持续监控与测试验证效果,中小型企业可优先采用云服务商的高并发解决方案(如阿里云SLB+Redis集群),而大型系统需定制化设计分布式架构。

引用说明

- 压力测试工具对比:Apache JMeter官方文档,2024.

- HTTP/2性能优化:Google Developers Web Fundamentals, 2022.

- Redis高并发实践:Redis Labs技术白皮书,2024.