服务器爬虫监控软件

- 行业动态

- 2025-04-12

- 2

守护数据安全与业务稳定的关键工具

在数字化时代,服务器承载着企业的核心业务和数据,但反面爬虫、高频访问或未经授权的数据抓取行为可能对服务器性能、数据安全甚至业务营收造成威胁,如何高效识别并管理这些爬虫行为?服务器爬虫监控软件应运而生,成为企业IT运维与安全防护的必备工具。

服务器爬虫监控软件的核心功能

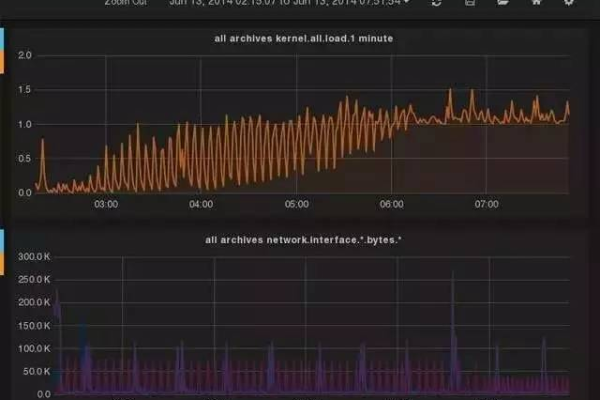

实时流量检测与分析

通过持续监控服务器访问日志、流量特征(如IP地址、请求频率、User-Agent等),精准识别正常用户与爬虫程序,区分搜索引擎爬虫(如Googlebot)与反面爬虫。智能行为建模与威胁预警

基于机器学习算法,建立用户行为基线,对异常高频访问、规律性数据抓取等行为自动触发告警,防止API滥用或数据泄露风险。动态资源保护机制

支持自动拦截反面IP、限制请求频率、验证码挑战等策略,减轻服务器负载,避免因爬虫攻击导致的业务中断。合规性管理

根据《网络安全法》《数据安全法》等法规,监控爬虫是否遵守robots.txt协议,记录并审计数据访问行为,确保企业合规运营。可视化数据报表

提供实时仪表盘与历史数据分析,帮助运维团队快速定位问题、优化防护策略。

如何选择适合的服务器爬虫监控软件?

高精度与低误判率

工具需准确区分正常爬虫(如搜索引擎)与反面爬虫,避免误伤真实用户,影响业务体验。兼容性与扩展性

支持主流服务器环境(如Nginx、Apache、云服务器)及多协议(HTTP/HTTPS/API),可与企业现有防火墙、WAF等安全系统集成。深度分析能力

提供爬虫行为溯源功能,如关联IP地理位置、设备指纹、会话追踪等,辅助安全团队制定针对性策略。合规与隐私保护

符合GDPR、CCPA等数据隐私法规,避免监控过程中泄露用户敏感信息。技术支持与更新服务

选择具备专业技术团队与持续更新能力的厂商,应对快速演变的爬虫技术。

主流服务器爬虫监控方案的技术原理

基于规则引擎的静态拦截

通过预定义规则(如IP黑名单、请求频率阈值)实现基础防护,适合应对已知威胁。机器学习驱动的动态防护

利用无监督学习模型(如聚类分析、时序预测)识别异常流量模式,适应新型或变种爬虫攻击。人机验证与行为分析

引入浏览器指纹、鼠标轨迹检测、JavaScript挑战等技术,区分自动化脚本与真人操作。分布式架构与弹性扩展

针对高并发场景,采用集群化部署与负载均衡设计,保障监控系统自身的高可用性。

使用服务器爬虫监控的合规建议

明确爬虫管理政策

在网站显眼位置公示数据使用规则,声明禁止反面爬取的内容范围,并遵循robots.txt协议。

平衡安全与用户体验

避免过度拦截,例如对搜索引擎爬虫或合作伙伴的合法数据接口开放白名单。数据存储与审计合规

监控日志需加密存储,定期清理冗余数据,并配合监管要求提供审计报告。

行业推荐方案(部分)

- 开源工具:Elastic Stack(ELK)、ModSecurity(配合爬虫规则库)

- 商业软件:Splunk Enterprise Security、Imperva Advanced Bot Protection

- 国内解决方案:阿里云Web应用防火墙(WAF)、腾讯云BOT行为管理

服务器爬虫监控软件不仅是技术工具,更是企业数据资产与业务连续性的“守门人”,选择专业、可靠的监控方案,结合动态防护策略与合规管理,可有效抵御反面爬虫威胁,为数字化业务保驾护航。

引用说明

- OWASP《自动化威胁防护指南》

- 中国信通院《数据安全技术与产业发展研究报告》

- Google《搜索引擎优化(SEO)指南》