存储字

- 行业动态

- 2025-04-12

- 2

存储技术通过高效管理数据支持现代信息社会,涵盖硬盘、闪存、云存储等介质,具备容量扩展、访问速度优化及数据安全保障功能,广泛应用于个人设备、企业服务器和云计算平台,其发展直接影响人工智能、物联网等领域的数据处理能力。

计算机系统中的数据存储基石

在计算机科学与硬件工程领域,“存储字”(Memory Word)是一个基础但至关重要的概念,它直接关系到数据处理效率、系统架构设计以及软硬件协同工作的性能,本文将深入解析存储字的定义、作用、技术演进及其在现代计算中的应用,帮助读者建立系统化的认知。

存储字的定义与核心特征

存储字是计算机存储器中可一次性存取、传输或处理的数据单元,其长度由系统的体系结构决定。

- 32位系统的存储字长度为32位(4字节);

- 64位系统的存储字长度为64位(8字节)。

核心特征包括:

- 固定长度:同一系统中所有存储字的位数一致;

- 寻址基础:内存地址通常以存储字为单位分配;

- 操作效率:CPU对存储字的读写通常在一个时钟周期内完成。

存储字的作用与意义

提升数据处理效率

CPU与内存间的数据交换以存储字为单位,较长的存储字意味着单次操作可处理更多数据,64位系统相比32位系统,单次数据传输量翻倍,显著减少访问内存的次数。

系统设计的基础规范

- 指令集设计:处理器指令的操作数通常基于存储字长度;

- 总线宽度:数据总线宽度需与存储字长度匹配,避免资源浪费;

- 兼容性保障:软件开发者需根据存储字长度优化数据结构(如对齐访问)。

影响计算性能的关键因素

存储字长度直接决定:- 单次运算的数据吞吐量;

- 内存带宽利用率;

- 并行计算能力(如SIMD指令集)。

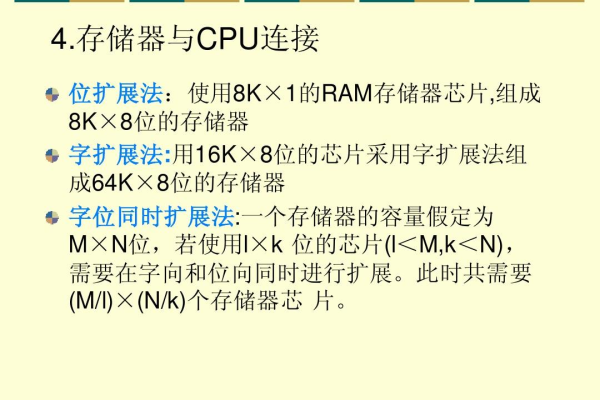

存储字的技术演进

从早期计算机到现代超算,存储字长度的扩展推动着计算能力的跃进:

| 时代 | 存储字长度 | 典型应用 |

|---|---|---|

| 1950s-1970s | 8位、12位 | 早期科学计算、工业控制 |

| 1980s-1990s | 16位、32位 | 个人电脑、图形工作站 |

| 2000s至今 | 64位、128位 | 云计算、AI训练、量子模拟 |

当前趋势:

- 可变长存储字:为适应AI计算需求,部分芯片支持动态调整字长(如NVIDIA Tensor Core);

- 非二进制存储字:量子计算机中采用量子位(Qubit)作为存储单元,突破传统二进制限制。

存储字在实际应用中的体现

硬件设计

- 内存芯片(如DDR4)的Bank结构以存储字为操作单元;

- CPU缓存行(Cache Line)通常包含多个存储字,减少访存延迟。

软件开发

- 数据对齐:结构体设计时需考虑存储字边界,避免“跨字访问”导致的性能损失;

- 位域操作:通过位掩码提取存储字中的特定字段(如网络协议解析)。

新兴技术场景

- 边缘计算:低功耗设备通过优化存储字访问降低能耗;

- 异构计算:GPU与CPU的存储字协同管理(如统一内存架构)。

常见问题解答

存储字与字节、位的区别?

- 位(Bit)是二进制最小单位;

- 字节(Byte)= 8位;

- 存储字是系统定义的操作单元,可能是多个字节的组合。

存储字长度能否自定义?

普通用户无法修改,其由CPU架构决定,但在FPGA等可编程硬件中,开发者可自定义字长。为何64位系统逐渐成为主流?

长存储字支持更大内存寻址(超过4GB),并优化浮点运算、加密计算等场景。

参考文献

- Patterson, D. A., & Hennessy, J. L. (2017). 计算机组成与设计:硬件/软件接口(第5版). 机械工业出版社.

- IEEE Standard 754-2008. 浮点数算术标准.

- ARM Architecture Reference Manual. 存储系统与数据访问规范.

完)