bp神经网络预测程序

- 行业动态

- 2025-04-11

- 3

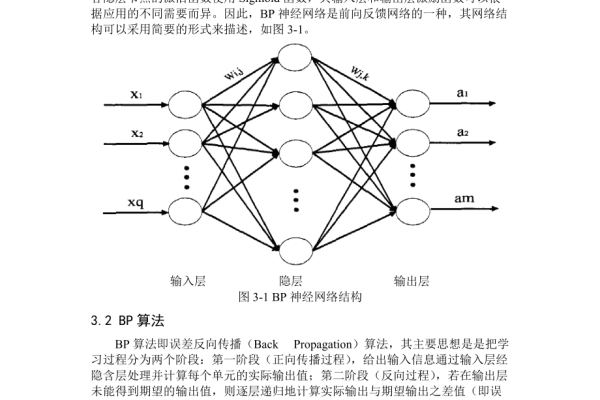

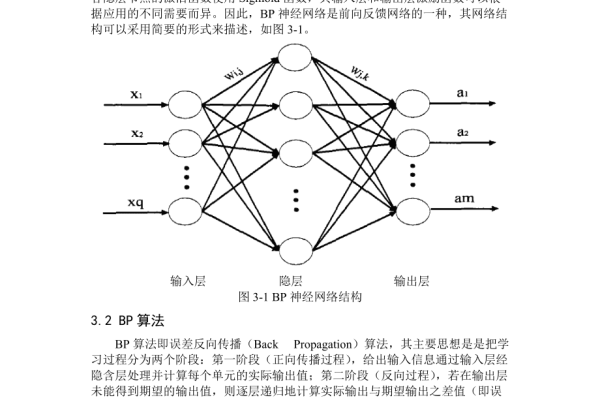

BP神经网络是一种多层前馈神经网络,基于反向传播算法调整权重参数,适用于数据预测与分析,其结构包含输入层、隐含层和输出层,通过梯度下降法优化误差函数,能处理非线性关系,程序实现需数据预处理、模型训练和

预测验证,广泛用于股票、销售等复杂预测场景,具有自适应学习和泛化能力。

BP神经网络预测程序:原理、开发与应用全解析

在人工智能与机器学习领域,BP神经网络(反向传播神经网络)凭借其强大的非线性拟合能力和广泛的应用场景,成为预测建模的核心工具之一,无论是金融风控、气象预测,还是医疗诊断、工业质检,BP神经网络均展现了卓越的预测性能,本文将深入解析其原理、开发流程与实际应用,为读者提供系统化的认知。

什么是BP神经网络?

BP神经网络是一种多层前馈神经网络,通过误差反向传播算法(Backpropagation)调整网络参数,其核心结构包括:

- 输入层:接收外部数据(如温度、股价等特征)。

- 隐含层:通过激活函数(如Sigmoid、ReLU)提取非线性特征。

- 输出层:输出预测结果(如分类标签、连续数值)。

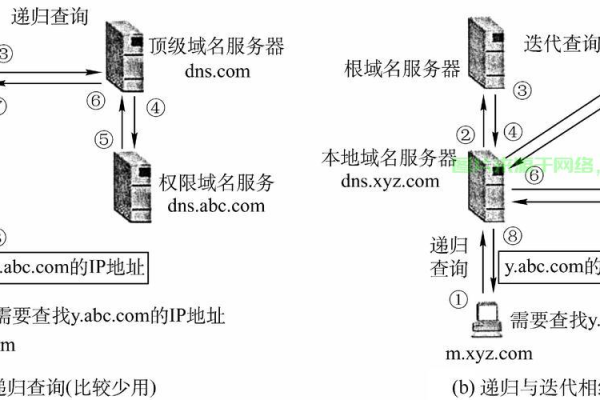

工作原理:

- 前向传播:数据从输入层逐层计算至输出层,生成预测值。

- 误差计算:通过损失函数(如均方误差)衡量预测值与真实值的差距。

- 反向传播:根据误差,利用梯度下降法逐层更新权重和偏置,最小化损失。

(示意图:数据流与参数更新过程)

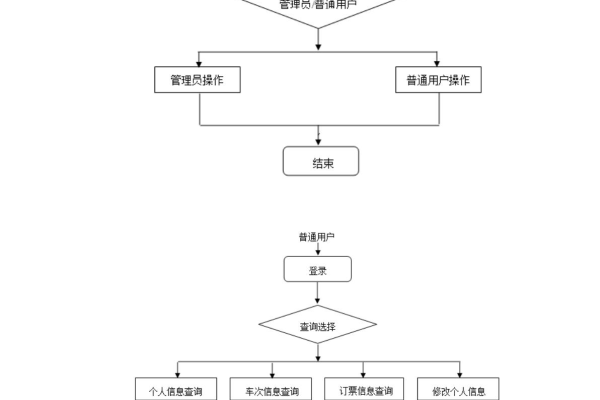

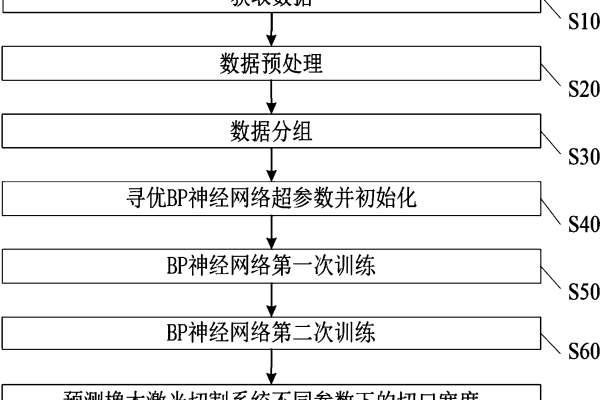

如何开发BP神经网络预测程序?

开发一个高效的BP神经网络预测程序,需遵循以下步骤:

数据准备与预处理

- 收集历史数据,确保覆盖预测目标的多种场景。

- 归一化或标准化数据(如Min-Max缩放),加速模型收敛。

- 划分训练集、验证集和测试集(典型比例:7:2:1)。

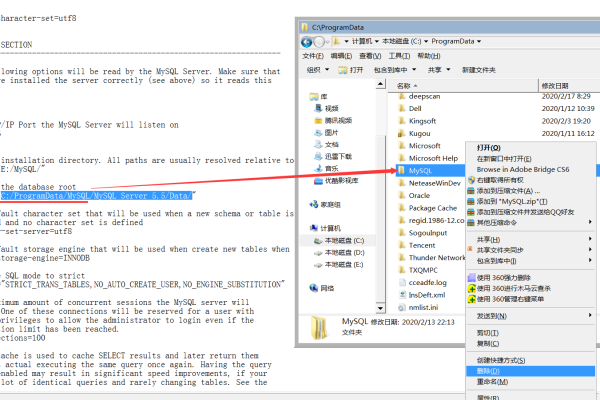

模型构建

- 选择网络结构:输入/输出层节点数由数据维度决定,隐含层数通常为1-3层。

- 设置超参数:学习率(0.001-0.1)、迭代次数(100-1000)、激活函数等。

# Python伪代码示例(基于TensorFlow) model = Sequential() model.add(Dense(64, activation='relu', input_shape=(input_dim,))) model.add(Dense(32, activation='relu')) model.add(Dense(1, activation='linear')) # 回归任务输出层

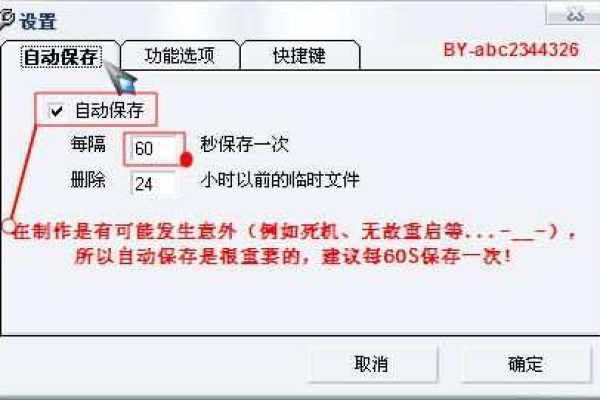

模型训练与调优

- 使用优化器(如Adam、SGD)更新参数。

- 监控验证集损失,防止过拟合(可引入早停法Early Stopping)。

- 调整隐含层节点数、学习率等参数,平衡精度与效率。

模型评估与部署

- 测试集评估指标:均方误差(MSE)、准确率(Accuracy)、R²分数等。

- 导出模型文件(如HDF5格式),集成到业务系统中实现实时预测。

BP神经网络预测的核心应用场景

| 场景类型 | 典型案例 | 预测目标 |

|---|---|---|

| 分类问题 | 图像识别(如手写数字分类) | 离散标签(0-9) |

| 回归问题 | 房价预测、销量预估 | 连续数值(如万元、件数) |

| 时序预测 | 股票价格波动、气象数据预测 | 未来时间段内的趋势 |

优化BP神经网络预测性能的4大方法

- 数据增强

通过插值、噪声添加或SMOTE算法扩充数据集,提升模型泛化能力。 - 正则化技术

使用L1/L2正则化、Dropout层抑制过拟合。 - 自适应学习率

采用Adam、RMSprop等优化器动态调整学习率。 - 集成学习

将多个BP神经网络结果融合(如Bagging、Stacking),降低方差。

开发注意事项

- 数据质量优先:缺失值、异常值需清洗,避免“垃圾进,垃圾出”。

- 避免过拟合:监控训练/验证损失曲线,及时调整模型复杂度。

- 硬件资源:大规模数据集需GPU加速(如使用CUDA加速库)。

BP神经网络预测程序的价值在于其灵活性与普适性,但成功的关键在于对业务场景的深入理解与数据的精细处理,随着深度学习框架(如TensorFlow、PyTorch)的普及,开发者可快速搭建高效模型,但仍需持续关注模型解释性、计算效率等挑战。

参考文献

- Rumelhart, D. E., Hinton, G. E., & Williams, R. J. (1986). Learning representations by back-propagating errors. Nature.

- Goodfellow, I., Bengio, Y., & Courville, A. (2016). Deep Learning. MIT Press.

- TensorFlow官方文档:https://www.tensorflow.org/

- Scikit-learn数据预处理指南:https://scikit-learn.org/stable/modules/preprocessing.html