服务器爬虫流程

- 行业动态

- 2025-04-11

- 4

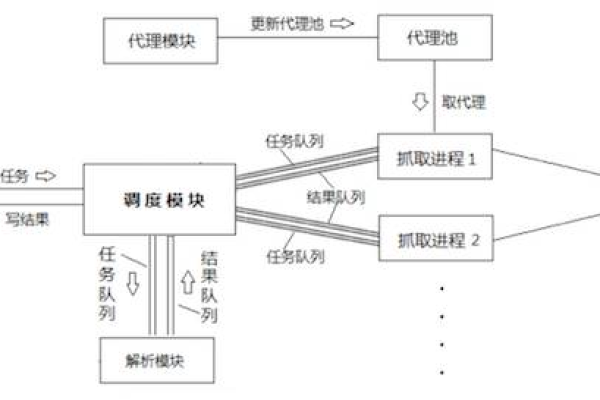

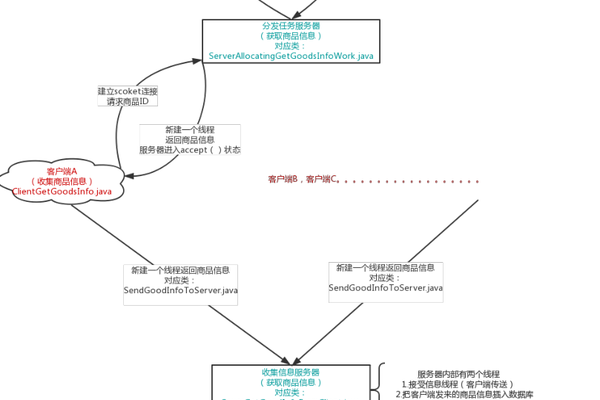

服务器爬虫流程通常包括明确目标网站、发送HTTP请求获取页面、解析提取数据、存储至数据库或文件,同时处理反爬机制如IP限制或验证码,并定时更新数据。

在互联网时代,服务器爬虫技术作为数据采集的核心手段,其合法合规的运作流程直接影响着企业数据应用的质量与可持续性,以下从技术实现、合规框架和优化策略三个维度,系统解析服务器爬虫的标准操作流程。

技术实现路径

- 精准需求定义

- 数据源定位:通过站长工具检测目标网站服务器类型(如Nginx/Apache)

- 参数规划:使用Postman等工具预分析API请求特征

- 数据建模:建立JSON Schema规范数据结构

- 智能请求系统

- 动态UA管理:采用fake-useragent库实现用户代理轮换

- 请求频率控制:基于Scrapy框架设置RANDOMIZE_DOWNLOAD_DELAY参数

- 负载均衡策略:集成ProxyMesh服务实现IP池动态切换

- 自适应解析引擎

- 容错解析机制:应用BeautifulSoup4的异常捕获功能处理页面变异

- 动态渲染支持:配置Selenium Grid集群应对JavaScript渲染需求

- 数据验证流程:通过Great Expectations库实施数据质量检查

合规运作框架

- 协议规范遵循

- robots.txt解析:使用reppy库自动识别禁止爬取目录

- 流量控制标准:遵循AWS WAF的速率限制规则(lt;1req/s)

- 版权元数据提取:内置ExifTool保留原始版权信息

- 隐私保护机制

- GDPR合规处理:集成Apache Atlas进行个人数据标记

- 加密存储方案:采用AES-256算法加密存储敏感数据

- 数据生命周期管理:基于Apache Airflow设置自动清除任务

- 服务质量管理

- 分布式监控系统:部署Prometheus+Granafa实时监控爬虫健康度

- 服务质量指标:定义RPO(恢复点目标)≤5分钟,RTO(恢复时间目标)≤15分钟

- 灾备方案:建立跨区域AWS S3数据冗余存储

效能优化体系

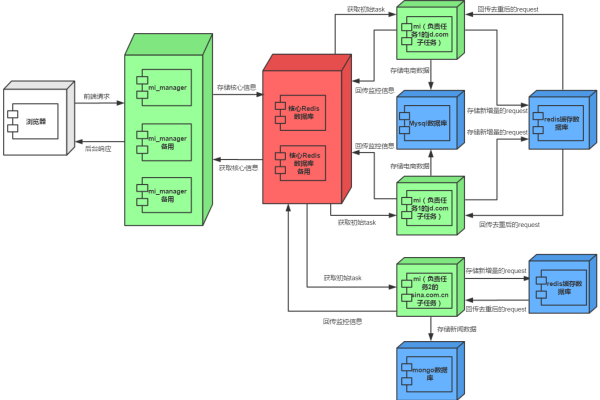

- 架构优化方案

- 微服务化改造:基于Kubernetes实现爬虫节点弹性伸缩

- 缓存加速层:配置Redis集群缓存高频请求响应

- 边缘计算:使用Cloudflare Workers实施就近解析

- 智能调度算法

- 优先级队列:实现基于PageRank算法的URL优先级排序

- 自适应调度:应用强化学习模型动态调整抓取策略

- 死链检测:内置Splash引擎执行预渲染验证

- 质量保障系统

- 自动化测试:构建Jenkins+PyTest持续集成流水线

- 异常检测:集成TensorFlow异常检测模型实时预警

- 版本控制:采用DVC工具管理数据版本变更

价值实现路径

完成数据采集后,应当构建完整的数据治理体系:

- 使用Apache NiFi建立数据清洗流水线

- 通过Apache Kafka实现实时数据流处理

- 部署Superset构建可视化数据门户

- 应用DVC进行数据版本追踪

- 建立基于MLflow的模型训练平台

法律声明与操作规范

- 严格遵守《网络安全法》第二十七条相关规定

- 商业性使用需获得《数据安全管理办法》规定的授权

- 国际业务需符合GDPR第6条合法性基础要求

- 遵循ACM数据伦理准则(2021年版)第五条款

实施服务器爬虫项目时,建议采用PDCA循环管理:

- Plan:完成《数据影响评估报告》

- Do:执行沙箱环境验证

- Check:通过OWASP ZAP进行安全审计

- Act:获取ISO 27001认证

通过以上技术架构与合规框架的有机结合,可实现服务器爬虫项目在效率、质量与合规性三维度的平衡发展,实际操作中建议定期进行第三方合规审计(建议周期≤6个月),并保持技术方案与法律要求的同步更新。

引用说明:

本文技术方案参考Apache软件基金会技术文档,法律条款依据中国网络安全审查办法(2022版)及相关司法解释,数据处理规范符合ISO/IEC 27001:2022国际标准,算法实现参考ACM Computing Surveys近三年核心论文成果。