为何服务器百度蜘蛛抓取会不稳定?

- 行业动态

- 2024-12-03

- 2018

服务器百度蜘蛛抓取不稳定可能是由于服务器性能、网络连接或网站设置问题导致的。

服务器百度蜘蛛抓取不稳定是一个常见的问题,可能由多种因素导致,以下是一些可能的原因以及相应的解决方案:

1、服务器稳定性:服务器的稳定性是影响百度蜘蛛抓取的关键因素之一,如果服务器经常出现故障或响应时间过长,百度蜘蛛可能无法正常抓取网站内容,为了解决这个问题,可以选择更可靠的服务器提供商,或者升级服务器配置以提高性能和稳定性。

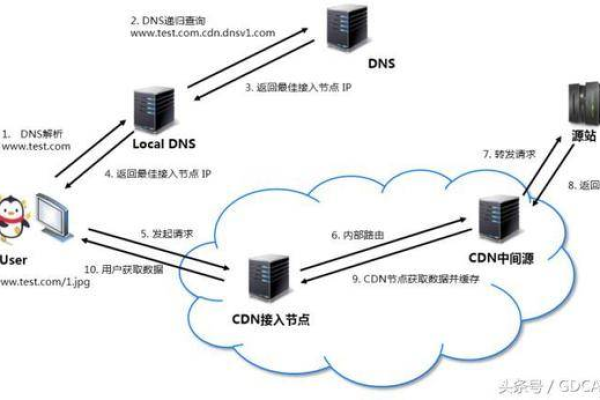

2、网络连接问题:网络连接的不稳定也可能导致百度蜘蛛抓取失败,这包括本地网络问题、DNS解析异常以及与百度服务器之间的网络延迟等,针对这些问题,可以检查本地网络设置,确保DNS解析正常,并尝试优化与百度服务器之间的网络连接。

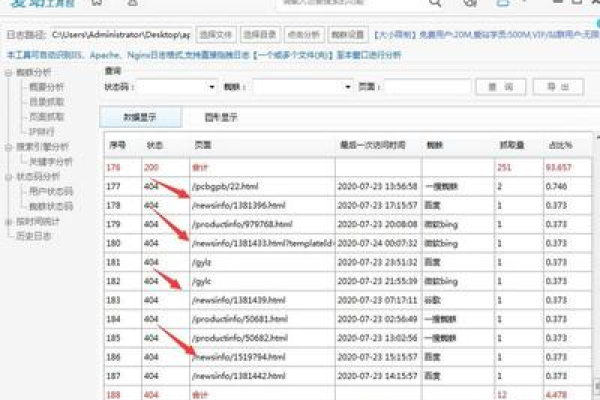

3、更新频率:百度蜘蛛会根据网站内容的更新频率来调整抓取频次,如果网站长时间不更新,百度蜘蛛可能会减少抓取次数,保持网站内容的定期更新对于提高百度蜘蛛抓取频次至关重要。

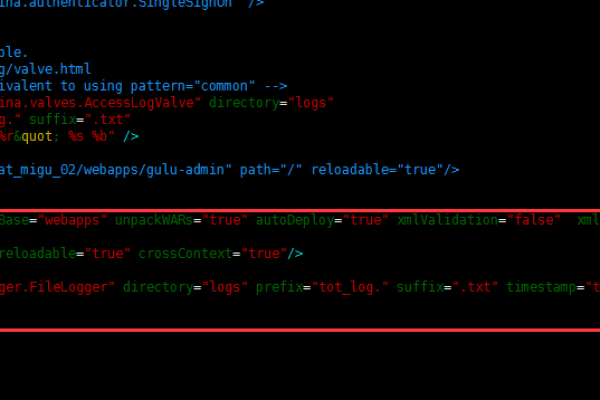

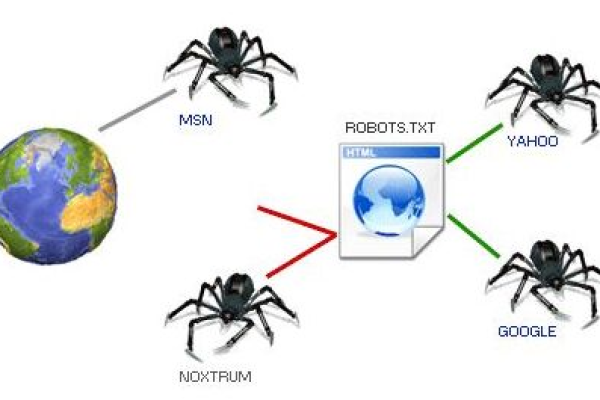

4、robots.txt文件设置:robots.txt文件用于告诉搜索引擎哪些页面可以抓取,哪些不可以抓取,如果robots.txt文件设置不当,可能会阻止百度蜘蛛抓取重要页面,需要仔细检查robots.txt文件的设置,确保没有误屏蔽重要页面。

5、网站结构复杂:网站结构过于复杂也可能导致百度蜘蛛抓取困难,深层嵌套的页面、动态生成的URL等都可能增加百度蜘蛛的抓取难度,为了解决这个问题,可以优化网站结构,使页面更加扁平化,并使用静态或伪静态URL。

6、外部链接质量:高质量的外部链接可以引导百度蜘蛛更频繁地访问网站,如果网站的外部链接质量较低或数量不足,可能会影响百度蜘蛛的抓取频次,需要积极寻求高质量的外部链接,并避免与低质量网站建立链接。

7、百度算法更新:百度会不断更新其算法以改进搜索结果的质量,算法的更新可能会导致百度蜘蛛对某些网站的抓取策略发生变化,在这种情况下,需要密切关注百度算法的更新动态,并根据需要调整网站优化策略。

服务器百度蜘蛛抓取不稳定是由多种因素共同作用的结果,为了解决这个问题,需要从服务器稳定性、网络连接、网站内容更新、robots.txt文件设置、网站结构优化、外部链接质量和百度算法更新等多个方面进行综合考虑和优化,通过这些措施的实施,可以提高百度蜘蛛对网站的抓取频次和效率,从而提升网站的收录和排名效果。

到此,以上就是小编对于“服务器百度蜘蛛抓取不稳地”的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位朋友在评论区讨论,给我留言。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/359735.html