如何在Linux系统中快速打开命令行界面?

- 行业动态

- 2024-10-09

- 3

Ctrl + Alt + T打开终端,从而进入命令行界面。

Linux如何进入命令行界面?Linux打开命令行界面的方法

在Linux操作系统中,命令行界面(Command Line Interface,简称CLI)是一种基于文本的用户界面,用户通过输入命令与计算机进行交互,命令行界面是Linux系统中最常用的操作方式之一,具有高效、灵活的特点,本文将介绍如何在Linux系统中进入命令行界面,以及打开命令行界面的方法。

进入命令行界面的方法

1、使用快捷键

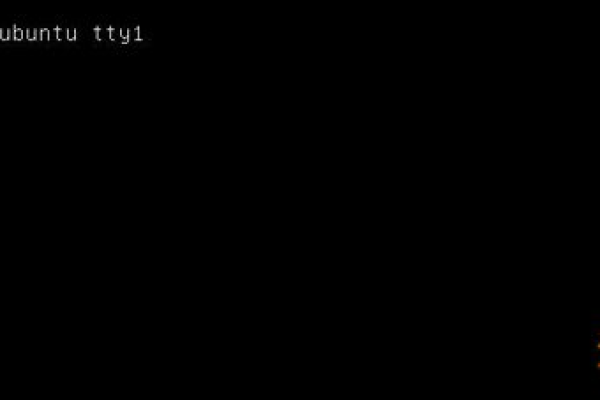

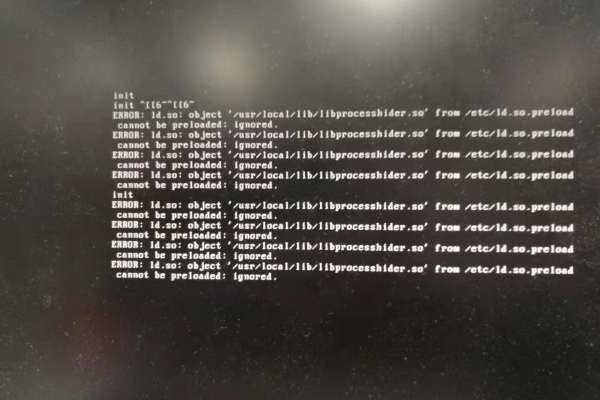

在大多数Linux发行版中,可以使用快捷键Ctrl +Alt +F1至F6来切换到不同的虚拟控制台,这些虚拟控制台都是命令行界面,用户可以在这些虚拟控制台中执行命令。F1至F6分别对应不同的虚拟控制台,F7通常会返回到图形界面。

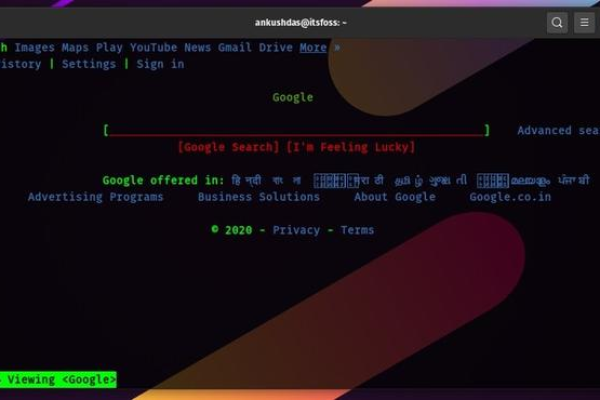

2、使用终端模拟器

在Linux的图形界面中,可以通过启动终端模拟器来访问命令行界面,常见的终端模拟器有:Gnome Terminal、Konsole、xterm等,以下是一些常见桌面环境及其默认终端模拟器:

Gnome: Gnome Terminal

KDE: Konsole

Xfce: xterm

LXDE: lxterminal

3、使用SSH远程登录

如果需要远程访问Linux服务器的命令行界面,可以使用SSH(Secure Shell)协议,通过SSH客户端(如PuTTY、OpenSSH等),可以连接到远程服务器并访问其命令行界面,连接时需要输入远程服务器的IP地址或域名、端口号(默认为22)、用户名和密码。

打开命令行界面的方法

1、使用命令行启动图形界面程序

在命令行界面中,可以使用startx命令启动图形界面,这个命令会调用X Server和用户的桌面环境,从而进入图形界面,需要注意的是,startx命令通常只在没有运行X Server的情况下有效。

2、使用系统设置工具

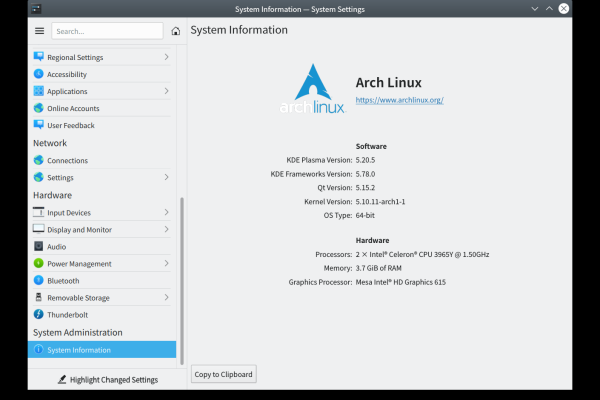

在图形界面中,可以使用系统设置工具来配置和管理命令行界面,在Gnome桌面环境中,可以使用“启动应用程序”功能来配置自动启动的应用程序,包括终端模拟器,在KDE桌面环境中,可以使用“系统设置”中的“窗口行为”选项卡来配置虚拟控制台的行为。

常见问题与解答

问题1:如何在Linux系统中切换虚拟控制台?

答:在Linux系统中,可以使用快捷键Ctrl +Alt +F1至F6来切换到不同的虚拟控制台,这些虚拟控制台都是命令行界面,用户可以在这些虚拟控制台中执行命令。F1至F6分别对应不同的虚拟控制台,F7通常会返回到图形界面。

问题2:如何在Linux系统中启动图形界面?

答:在Linux系统中,可以使用startx命令启动图形界面,这个命令会调用X Server和用户的桌面环境,从而进入图形界面,需要注意的是,startx命令通常只在没有运行X Server的情况下有效,还可以通过修改系统的启动配置来实现自动启动图形界面,具体方法因Linux发行版和桌面环境而异。

小伙伴们,上文介绍了“Linux如何进入命令行界面 Linux打开命令行界面的方法”的内容,你了解清楚吗?希望对你有所帮助,任何问题可以给我留言,让我们下期再见吧。