储存服务器测评标准是什么

- 行业动态

- 2024-07-24

- 7

储存服务器是企业信息系统中不可或缺的部分,它们负责存储和管理大量数据,测评储存服务器的标准是一个多维度、复杂的过程,涉及性能、可靠性、可扩展性、功能、兼容性和能耗等多个方面,以下是对这些测评标准的具体分析:

1、性能评估

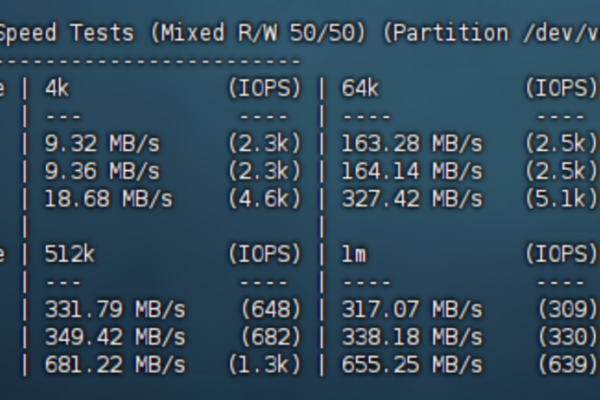

吞吐量:衡量储存服务器在单位时间内处理数据的能力,通常以每秒传输的数据量来计算。

响应时间:指储存服务器响应请求的速度,即从接收到数据请求到开始传输数据的间隔时间。

并发访问能力:评估储存服务器能够同时处理多个数据请求的能力。

2、可靠性评估

数据完整性:确保数据在存储和传输过程中不发生错误或损坏的能力。

系统稳定性:储存服务器在长时间运行下的稳定运行能力,包括硬件和软件的稳定性。

故障恢复能力:在发生故障时,系统能够快速恢复到正常状态的能力。

3、可扩展性评估

存储容量扩展:储存服务器增加存储容量的便捷性和灵活性。

架构扩展:系统架构支持横向或纵向扩展以适应不断增长的数据量和处理需求。

4、功能评估

数据备份和恢复:评估储存服务器的数据备份效率以及数据恢复的便捷性和完整性。

数据迁移:评估将数据迁移到储存服务器的易用性和迁移过程中的数据安全性。

安全功能:包括数据加密、访问控制等安全措施的完善程度和有效性。

5、兼容性评估

操作系统兼容性:储存服务器与不同操作系统之间的兼容情况,确保数据可以无缝迁移和访问。

网络环境适应性:在不同网络环境下,储存服务器的性能表现和稳定性。

第三方软件兼容性:与业界常见的数据库、应用软件等的兼容性。

6、能耗评估

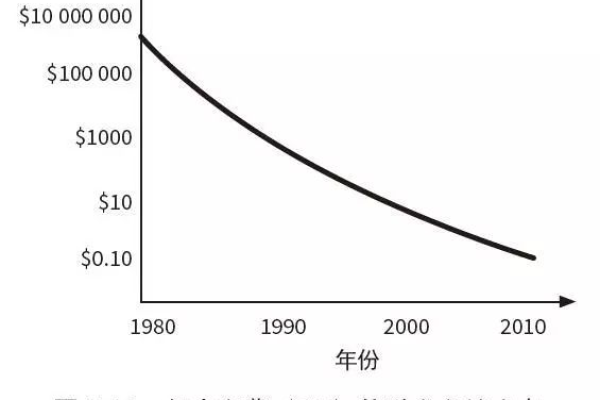

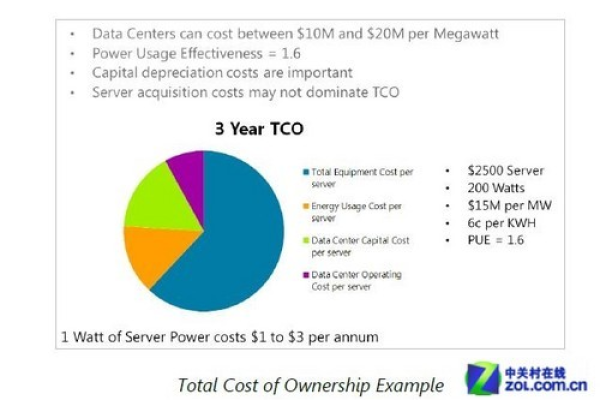

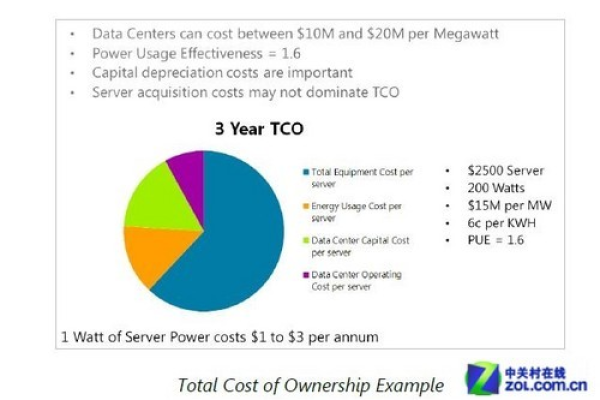

能源效率:评估储存服务器在处理存储任务时的能源消耗率,鼓励选择能效比较高的产品以降低运营成本。

散热效能:评估储存服务器的散热设计是否合理,是否能在高负载下保持稳定运行。

在选择合适的储存服务器时,除了上述测评标准外,还需要考虑以下几点:

考虑未来数据增长的需求,选择可扩展性强的储存服务器。

根据企业的IT环境和预算,确定合理的性能指标和功能要求。

重视能耗评估,选择能效高的储存服务器,以降低长期运营成本。

关注产品的售后服务和支持,确保在遇到问题时能够获得及时有效的帮助。

选择储存服务器时,应综合考虑性能、可靠性、可扩展性、功能、兼容性和能耗等多个方面的测评标准,通过这些标准的全面评估,企业可以选择出最合适的储存服务器,以满足其存储需求,保障数据的安全和可靠性,同时优化总体拥有成本(TCO),在选择过程中,还应考虑供应商的技术支持和服务,确保在部署和使用过程中能够获得必要的帮助,从而最大化储存服务器的价值。