上一篇

如何利用Java编写高效的网络爬虫?探索源码实例!

- 行业动态

- 2024-10-09

- 3333

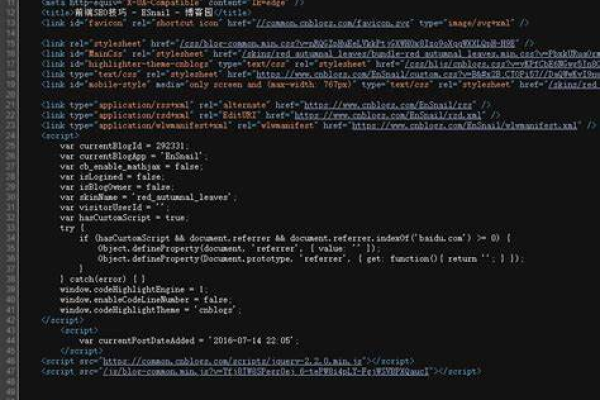

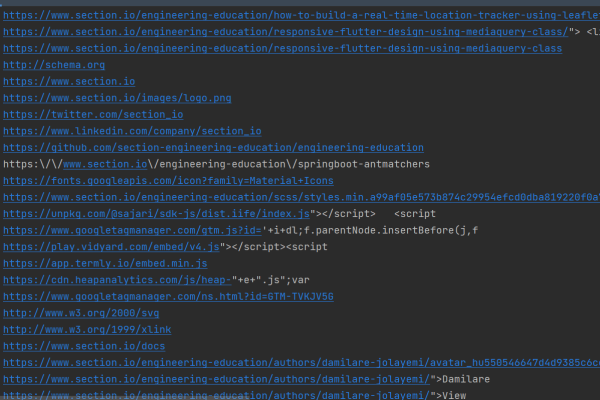

Java爬虫源码通常使用Jsoup、HttpClient等库,通过发送HTTP请求获取网页内容,解析HTML并提取所需数据。

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.IOException;

public class WebCrawler {

public static void main(String[] args) {

String url = "https://www.example.com"; // 需要爬取的网站URL

try {

// 获取网页内容

Document document = Jsoup.connect(url).get();

// 选择需要爬取的元素,所有的链接

Elements links = document.select("a[href]");

// 遍历并打印所有链接

for (Element link : links) {

System.out.println("链接: " + link.attr("abs:href"));

}

} catch (IOException e) {

e.printStackTrace();

}

}

}这个示例代码会爬取指定URL的网页内容,然后提取所有的链接(<a>标签)并打印出来,你可以根据需要修改选择器和处理逻辑来满足你的爬虫需求。

到此,以上就是小编对于“java 爬虫 源码”的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位朋友在评论区讨论,给我留言。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:https://www.xixizhuji.com/fuzhu/13392.html