金铲铲服务器爆满时无法进入的原因是什么?

- 行业动态

- 2024-07-31

- 12

金铲铲是一款广受欢迎的游戏,当其服务器显示爆满而无法进入时,通常会让玩家感到困惑和无奈,这种情况下,通常涉及到多个技术问题和实际操作的难点,下面将深入分析导致这一现象的原因,并提供针对性的解决方案:

1、服务器容量限制

硬件资源有限:金铲铲的服务器承载能力基于其硬件配置,包括CPU处理能力、内存大小及网络带宽等,这些硬件资源限制了服务器能够同时处理的游戏会话数量。

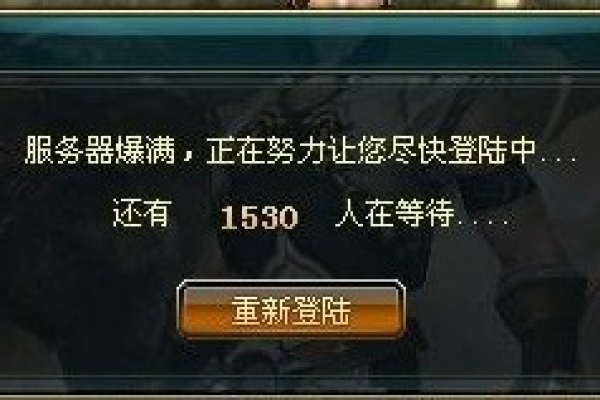

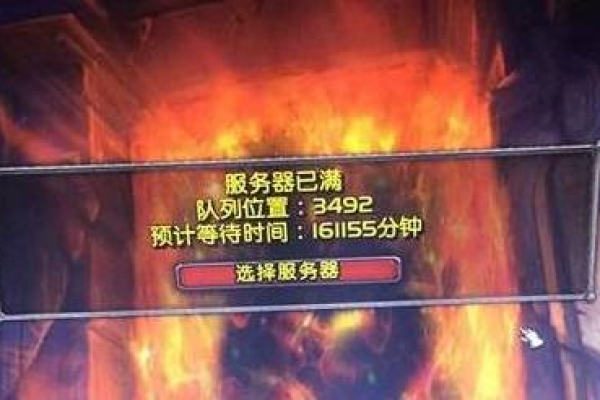

并发玩家过多:当大量玩家尝试在同一时间登录游戏,请求的数量可能超过了服务器的处理极限,结果导致一些玩家无法进入游戏。

技术限制影响:从技术角度来看,每个服务器都有其最大承载量,一旦超出这个限额,新的连接请求就会被拒绝,即使物理资源未完全用尽,这是因为需要预留一定的资源以防服务器崩溃,确保已连接玩家的游戏体验不受影响。

2、维护和更新

定期维护:为了确保游戏服务的稳定性和安全性,金铲铲的服务器会进行定期的维护和更新,在这些时段内,服务器可能会暂时关闭,以进行必要的升级和维护工作。

紧急修复:偶尔会出现突发的故障或安全问题,需要技术团队进行紧急干预,这种情况下,服务器可能需要临时下线,以快速修复问题。

版本更新的更新往往需要服务器的支持,在新版本推出时,服务器可能需要进行更新以确保新内容的正确运行,这也可能导致服务器暂时不可用。

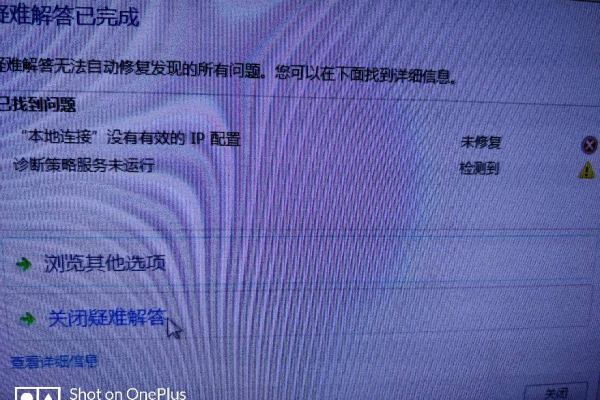

3、网络问题

网络拥堵:在人流高峰期,如节假日或特殊活动期间,网络流量骤增,可能导致服务器响应缓慢甚至无法连接。

连接不稳定:玩家个人的网络连接质量也会影响与游戏服务器的通信,不稳定的网络连接可能导致连接中断或超时。

地理位置因素:地理位置也可能影响连接质量,如果服务器物理位置远离玩家,网络延迟可能增加,影响游戏体验。

4、用户行为

登录高峰:在特定的时间段,如下班后或周末,玩家集体上线的行为会造成短时间内的访问高峰。

社交效应:当游戏因为口碑传播或社交媒体的影响突然爆红时,新老玩家的涌入可能会让服务器瞬间达到承载极限。

持续参与度:金铲铲作为一款有深度和复杂性的游戏,保持了较高的玩家参与度,这也使得服务器常常运行在高负荷状态。

5、客户端问题

软件过时:若玩家的游戏客户端版本过旧,可能无法与当前服务器版本兼容,导致无法进入。

缓存数据问题:客户端的缓存数据如果损坏或过时,也可能影响游戏的正常运行。

6、对策与建议

等待低峰时段:避开用户高峰时段登录游戏,比如午夜或者早晨。

检查网络连接:确保个人网络设备运行正常,网络连接稳定。

面对这些情况,玩家们可以尝试以下几种方法来提高进入游戏的可能性:

确认游戏客户端为最新版本,避免因版本不匹配无法登录。

使用网络诊断工具检查设备与游戏服务器之间的连接质量。

在服务器维护或更新期间,关注官方通知,合理安排游戏时间。

可以归纳金铲铲服务器爆满而无法进入的问题涉及多方面的原因,包括服务器容量、网络问题、用户行为等,理解这些背后的原因有助于玩家更加合理地安排游戏时间,并采取适当措施应对这一问题,游戏开发者也应不断优化服务器性能和扩充设施,以提供更流畅的游戏体验。

FAQs

为什么有时候金铲铲服务器显示爆满,但稍后又不需要排队就可以进入?

这种情况可能是因为服务器达到了短暂的峰值负载,随后部分玩家退出或网络状况改善,从而释放了资源,使得其他玩家得以接入。

如果持续无法进入金铲铲游戏,有哪些官方渠道可以寻求帮助?

玩家可以通过游戏的官方论坛、客服邮箱或社交媒体账号来反馈问题和寻求帮助,官方通常会在这些平台上发布维护信息和解决方案,也会回应玩家的具体问题。