python中max的用法

- 行业动态

- 2024-02-08

- 3

Python中max函数用于返回给定参数的最大值,支持多个参数和可迭代对象。

Python中的max()函数是一个内置函数,用于找出给定参数的最大值,这个函数可以接受任意数量的参数,这些参数可以是数值或者序列(如列表、元组等)。

基本用法

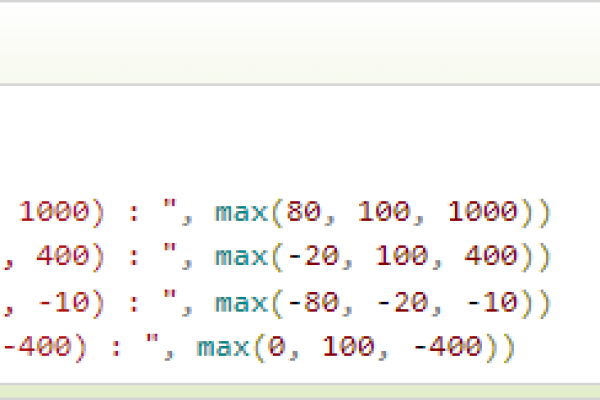

1、当传入的是两个或多个数值时,max()函数会返回其中的最大值。

print(max(3, 5, 7, 9)) 输出:9

2、当传入的是字符串时,max()函数会比较字符串的字典序,并返回最大的那个字符串。

print(max("apple", "banana", "cherry")) 输出:"cherry" 与序列一起使用

1、当传入的是序列(如列表、元组)时,max()函数会返回序列中的最大值。

print(max([1, 2, 3, 4, 5])) 输出:5

2、如果序列的元素是字符串,那么max()函数会返回字典序最大的字符串。

print(max(["apple", "banana", "cherry"])) 输出:"cherry"

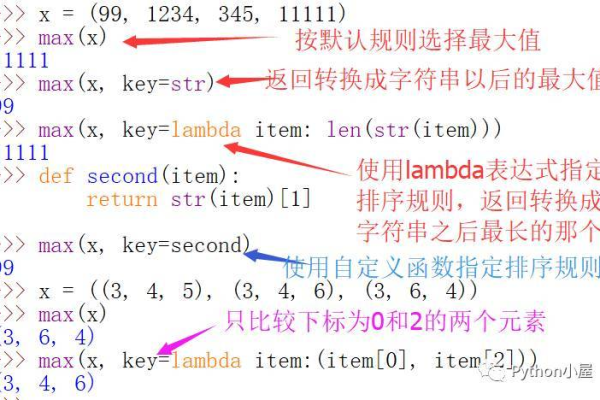

使用关键字参数

max()函数还接受一个可选的关键字参数key,该参数应该是一个函数,用于在比较元素之前对每个元素进行处理,如果我们有一个人员的年龄列表,我们想要找出年龄最大的人的名字,我们可以这样做:

ages = {"Tom": 20, "Jerry": 25, "Spike": 18}

oldest_name = max(ages.items(), key=lambda x: x[1])[0]

print(oldest_name) 输出:"Jerry" 自定义比较

如果你需要自定义比较逻辑,你可以提供一个名为compare的函数作为max()函数的第二个参数,这个函数应该接受两个参数,并返回一个表示这两个参数相对大小的值。

def compare(a, b):

return a b

print(max([1, 2, 3, 4, 5], compare)) 输出:5 相关问题与解答

Q1:如果我想找出列表中的最小值,我该怎么办?

A1:你可以使用Python的内置函数min()来找出列表中的最小值。

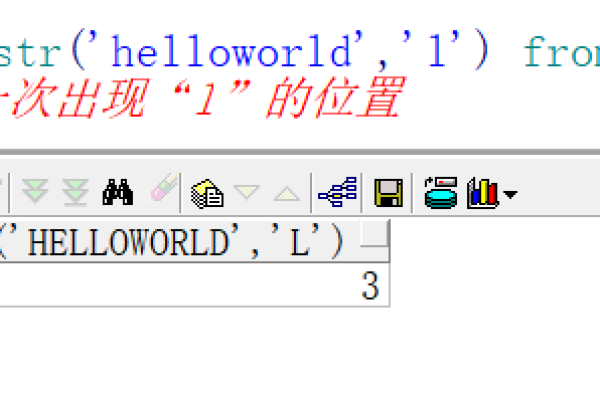

Q2:我可以使用max()函数来找出字符串中的最大字符吗?

A2:不能,max()函数会返回整个字符串中字典序最大的字符串,而不是字符串中的最大字符,如果你想找出字符串中的最大字符,你可以使用max()函数和list()函数一起,如max(list("hello"))。

Q3:我可以在max()函数中使用自定义的比较函数吗?

A3:可以,你可以通过提供compare函数作为max()函数的第二个参数来使用自定义的比较函数。

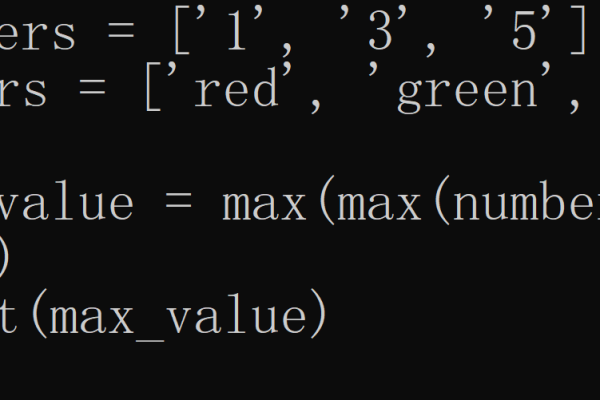

Q4:如果我想找出列表中的最大值和最小值,我需要调用两次max()函数和两次min()函数吗?

A4:不需要,Python提供了一个内置函数sorted(),可以将列表排序后返回,然后你可以直接获取第一个元素(最小值)和最后一个元素(最大值)。