解决Nagios监控问题

- 行业动态

- 2024-04-29

- 5

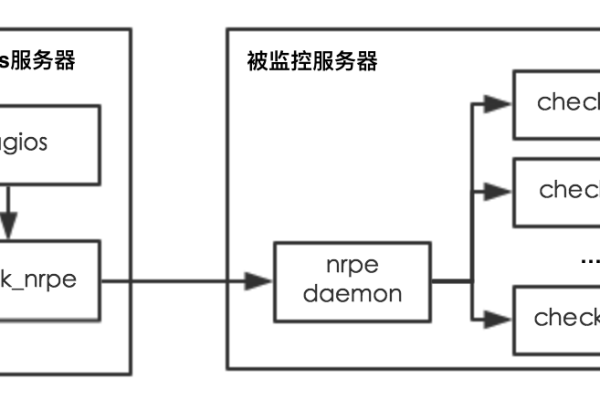

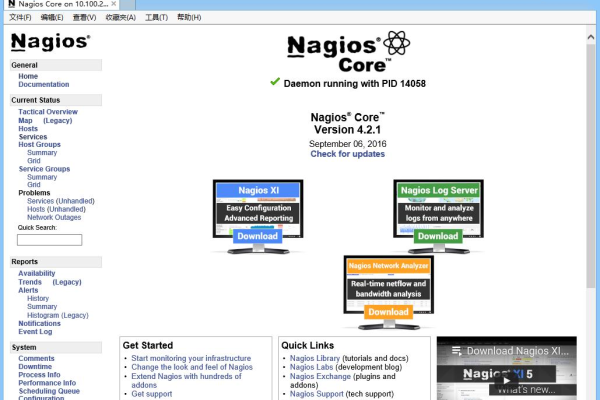

Nagios是一款广泛使用的开源网络监控工具,它能够帮助管理员监测服务器、网络和基础设施的状态,在配置和使用过程中,用户可能会遇到各种问题,影响监控的准确性和效率,以下是一些常见问题的解决方法:

1. Nagios服务无法启动

检查Nagios的配置文件是否正确无误,配置文件通常位于/etc/nagios/nagios.cfg,确保所有的配置项都符合Nagios的语法要求。

接下来,检查日志文件(通常位于/var/log/nagios/目录下),查找是否有错误信息,如果有权限问题,请确保Nagios用户有足够的权限访问所有必要的文件和目录。

检查命令文件和插件是否可执行,在Linux系统中,可以使用chmod命令为它们添加可执行权限。

2. 插件或命令无法正常工作

确保插件的路径已经正确配置在Nagios的主配置文件中,并且插件本身可以独立运行,如果插件需要特定的环境变量,确保这些变量在运行插件时已经被设置。

对于自定义的插件或脚本,务必进行充分的测试,确保它们能够在目标操作系统上正常运行。

3. 警报通知没有发出

检查Nagios的联系人和通知设置,确认联系人的信息(如邮箱地址)是正确的,并且在contacts.cfg文件中有相应的配置。

检查通知命令是否配置正确,例如SMTP服务器的设置、邮件发送命令等。

如果使用电子邮件通知,还要确保邮件服务器没有问题,并且能够正常发送邮件。

4. 监控图形显示不正常

Nagios有一个名为RRDTool的工具用于绘制监控图形,如果图形显示不正常,首先要检查RRDTool是否正确安装,并且Nagios有权限访问RRDTool生成的文件。

检查相关的配置文件,如commands.cfg和object.cfg,确保其中定义的命令和对象与实际需求相符。

5. 性能问题和资源消耗过高

如果Nagios运行缓慢或者消耗大量资源,可能需要优化配置,减少不必要的监控项,合并相似的监控命令,以及调整轮询间隔时间都可以减轻服务器的负担。

还可以考虑升级硬件或者优化系统配置,以提高整体的性能。

6. 升级Nagios后出现问题

在升级Nagios之后,首先检查新版本的发行说明和文档,了解是否有不兼容的变更,确保所有的插件和配置文件都与新版本兼容。

如果遇到具体的错误,可以查找官方论坛或者社区支持,看看是否有其他用户遇到过相同的问题,并提供了解决方案。

归纳

解决Nagios监控问题的关键在于仔细检查和配置每一项资源,从配置文件到插件,再到通知设置和性能优化,每一步都需要细心操作,如果遇到无法解决的问题,不要犹豫寻求社区的帮助或者咨询专业人士,通过不断的实践和学习,你将能够更好地管理和优化Nagios监控系统。