美国服务器适合搭建的网站类型有哪些呢

- 行业动态

- 2024-03-05

- 4

美国服务器适合搭建多种类型的网站,包括电商平台、企业官网、个人博客、论坛社区以及流媒体服务等。

美国服务器因其地理位置、法律环境以及技术成熟度,成为全球众多网站管理员搭建网站的优选,以下是一些适合在美国服务器上搭建的网站类型:

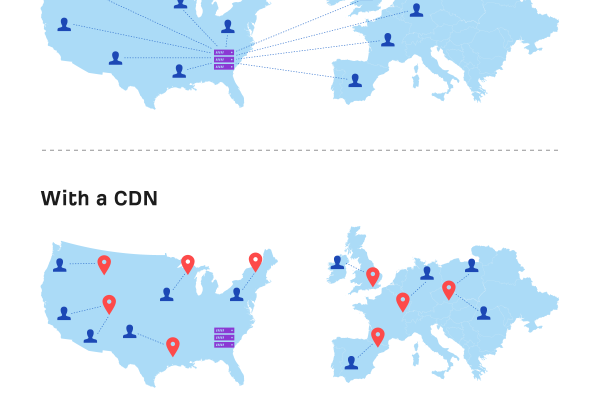

内容分发网络(CDN)节点

美国服务器通常被用作内容分发网络的一部分,因为其具有广泛的网络覆盖和高速的互联网连接,通过在美国设立服务器节点,可以加快内容传输到北美乃至全球用户的速度。

电子商务平台

美国是全球最大的电子商务市场之一,拥有庞大的在线购物人群,在美国服务器上搭建电子商务平台可以提供更好的本地化服务,同时确保快速的页面加载速度和稳定的交易处理能力。

云计算服务

美国服务器在云计算领域占据重要位置,无论是提供基础设施即服务(IaaS)、平台即服务(PaaS)还是软件即服务(SaaS),都可以依托美国强大的数据中心和技术支撑来实现。

媒体和视频流服务

对于需要大带宽和高稳定性的媒体及视频流服务,美国服务器是一个不错的选择,它们能够支持高清视频的存储和传输,同时保证低延迟和高并发访问量。

企业和组织官网

对于跨国公司或希望拓展美国市场的企业来说,在美国服务器上搭建官方网站有助于提高当地访问速度,改善用户体验,并有利于SEO优化。

社交平台和论坛

美国服务器可以为社交媒体平台和在线论坛提供可靠的技术支持,这些社交网站往往要求实时互动和数据更新,需要服务器具备高性能的处理能力和稳定的运行时间。

科技研究和开发

美国的科技环境成熟,许多科技公司选择在美国服务器上进行软件开发、数据分析和机器学习等研究工作,以利用当地的计算资源和技术优势。

游戏服务器

游戏行业在全球范围内有着庞大的市场,美国服务器由于其优越的网络条件和高性能硬件配置,非常适合搭建在线游戏服务器,为用户提供流畅的游戏体验。

相关问题与解答

1、问: 使用美国服务器对网站SEO有什么影响?

答: 使用美国服务器可以提高网站在北美地区的访问速度,从而可能正面影响搜索引擎排名,因为网站速度是搜索引擎排名算法中的一个因素。

2、问: 美国服务器是否无需备案?

答: 是的,美国没有类似中国的ICP备案要求,这使得搭建网站更加便捷。

3、问: 美国服务器的安全性如何?

答: 美国服务器提供商通常提供高水平的安全措施,包括防火墙、DDoS防护等,但网站管理员也需采取必要措施保护网站安全。

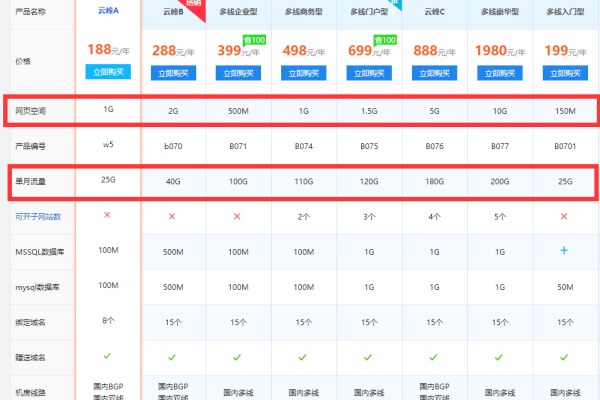

4、问: 如何选择适合自己需求的美国服务器?

答: 应考虑服务器的性能、价格、支持的服务类型、数据中心的可靠性和客户服务等因素,并根据网站的具体需求和预算做出选择。