如何为用户制定访问MySQL数据库的方案,以支持Spark作业?

- 行业动态

- 2024-10-25

- 1

在现代数据驱动的世界中,Spark作为一个强大的分布式数据处理框架,经常需要与各种数据源进行交互,MySQL作为广泛使用的关系型数据库管理系统,常被用于存储业务数据,本文将详细介绍如何配置Spark作业访问特定的MySQL数据库,并确保只有指定的用户能够访问该数据库。

环境准备

1.1 安装必要的软件

Java Development Kit (JDK): Spark运行需要JDK支持。

Apache Spark: 可以从[Apache Spark官网](https://spark.apache.org/downloads.html)下载并安装。

MySQL Server: 确保MySQL服务器已安装并正在运行。

MySQL Connector/J: 这是MySQL的Java连接器,用于Spark通过JDBC连接MySQL,可从[MySQL官网](https://dev.mysql.com/downloads/connector/j/)下载。

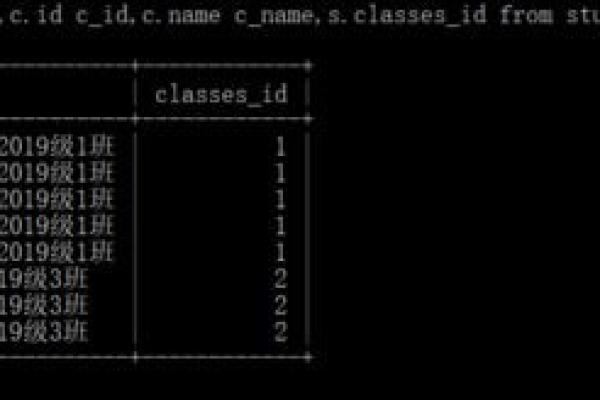

1.2 配置MySQL数据库

假设我们已经有一个名为example_db的数据库,并且希望创建一个用户spark_user来访问这个数据库,以下是创建用户和授权的命令:

CREATE USER 'spark_user'@'%' IDENTIFIED BY 'secure_password'; GRANT SELECT, INSERT, UPDATE, DELETE ON example_db.* TO 'spark_user'@'%'; FLUSH PRIVILEGES;

Spark作业配置

2.1 添加MySQL Connector/J到Spark Classpath

将下载的MySQL Connector/J jar文件添加到Spark的classpath中,可以通过以下方式之一实现:

将jar文件复制到$SPARK_HOME/jars/目录下。

在提交Spark作业时,使用jars参数指定jar文件的位置。

sparksubmit class com.example.MainClass jars /path/to/mysqlconnectorjava.jar yourapplication.jar

2.2 编写Spark作业代码

以下是一个简单的Spark作业示例,它连接到MySQL数据库并执行一些基本的CRUD操作。

import org.apache.spark.sql.{SparkSession, DataFrame}

import java.util.Properties

object MySparkJob {

def main(args: Array[String]): Unit = {

val spark = SparkSession.builder()

.appName("MySQL Integration Example")

.getOrCreate()

// MySQL连接属性

val properties = new Properties()

properties.put("user", "spark_user")

properties.put("password", "secure_password")

properties.put("driver", "com.mysql.cj.jdbc.Driver")

// 读取数据

val df = spark.read

.format("jdbc")

.option("url", "jdbc:mysql://localhost:3306/example_db")

.option("dbtable", "your_table_name")

.option("properties", properties.asInstanceOf[java.util.Map[_, _]])

.load()

df.show()

// 写入数据

df.write

.mode("append")

.format("jdbc")

.option("url", "jdbc:mysql://localhost:3306/example_db")

.option("dbtable", "your_table_name")

.option("properties", properties.asInstanceOf[java.util.Map[_, _]])

.save()

spark.stop()

}

}

安全性考虑

为了确保数据安全,可以考虑以下几点:

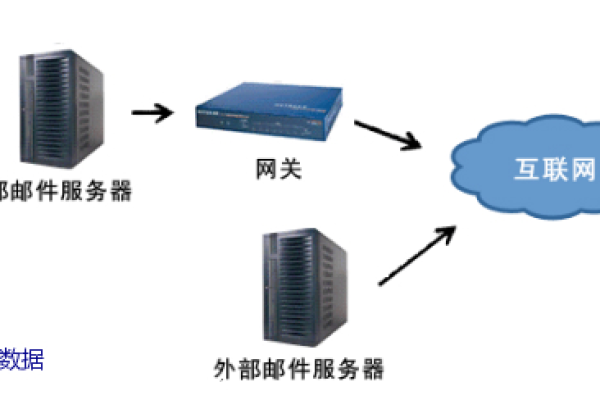

使用SSL/TLS加密连接:在MySQL和Spark之间建立安全的通信通道。

最小权限原则:仅授予spark_user所需的最低权限。

定期审查日志:监控和审计数据库访问日志,以便及时发现异常活动。

性能优化建议

分区策略:根据数据量大小选择合适的分区策略,以提高查询效率。

索引优化:确保对频繁查询的字段建立索引。

缓存机制:利用Spark的内存缓存功能,减少重复计算。

常见问题解答 (FAQs)

Q1: 如果遇到“无法加载主类”的错误怎么办?

A1: 这种错误通常是由于类路径设置不正确导致的,请检查以下几点:

确保所有依赖的jar文件都已正确添加到classpath中。

使用正确的命令行参数指定classpath。

如果使用的是IDE(如IntelliJ IDEA或Eclipse),请确保项目配置中的classpath包含所有必需的库。

Q2: 如何更改Spark作业使用的MySQL用户名和密码?

A2: 要更改Spark作业中使用的MySQL用户名和密码,只需修改上述代码中的properties对象即可,如果你想使用新的用户名new_user和新密码new_password,则可以这样设置:

properties.put("user", "new_user")

properties.put("password", "new_password")

记得同时更新相应的授权信息,以确保新用户有足够的权限访问目标数据库。

通过上述步骤,您可以成功地配置Spark作业以访问特定的MySQL数据库,并确保只有指定的用户能够访问该数据库,这不仅提高了数据处理的效率,还增强了系统的安全性。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/8832.html