服务器上跑爬虫

- 行业动态

- 2025-02-25

- 3

在服务器上运行爬虫可以有效地进行大规模的数据采集,但同时也需要注意合法性、效率和服务器的负载能力,以下是一些详细的指导步骤:

准备工作

选择服务器:确保服务器性能足够,包括CPU、内存和带宽等。

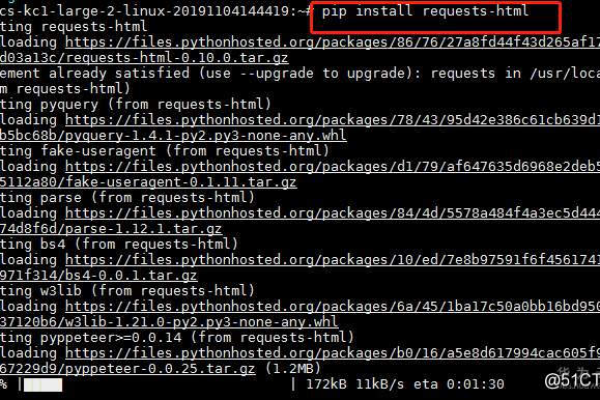

安装必要软件:如Python、Pip(Python包管理器)、Git等。

选择爬虫框架:常用的有Scrapy、BeautifulSoup、Selenium等。

环境配置

| 软件/库 | 版本 | 安装命令 |

| Python | 3.6+ | sudo apt update && sudo apt install python3 |

| Pip | 最新 | sudo apt install python3-pip |

| Scrapy | 最新 | pip3 install scrapy |

| BeautifulSoup4 | 最新 | pip3 install beautifulsoup4 |

| Requests | 最新 | pip3 install requests |

| Selenium | 最新 | pip3 install selenium |

编写爬虫脚本

使用Scrapy:创建一个Scrapy项目并定义爬虫逻辑。

使用Requests和BeautifulSoup:编写自定义爬虫脚本。

使用Selenium:处理JavaScript渲染的页面。

运行爬虫

定时任务:使用Crontab或其他任务调度工具来定期运行爬虫。

监控与日志:记录爬虫运行状态和错误信息,便于调试和维护。

数据存储与处理

数据库:将采集到的数据存储到MySQL、PostgreSQL或MongoDB等数据库中。

文件系统:以CSV、JSON或XML格式保存数据。

遵守法律法规

robots.txt:尊重网站的爬虫协议。

隐私政策:避免采集敏感信息,如个人隐私数据。

合法使用:确保数据采集行为符合当地法律法规。

优化与维护

性能优化:通过多线程、异步请求等方式提高爬虫效率。

异常处理:增加重试机制和错误处理,确保爬虫稳定运行。

更新维护:定期检查网站结构变化,更新爬虫代码。

FAQs

Q1: 如何在服务器上安装Scrapy?

A1: 首先确保服务器上安装了Python和Pip,然后通过命令pip3 install scrapy来安装Scrapy。

Q2: 如何设置爬虫的定时任务?

A2: 可以使用Crontab来设置定时任务,每天凌晨2点运行爬虫的命令可以是:0 2 * * * /usr/bin/python3 /path/to/your_spider.py。

小编有话说

在服务器上跑爬虫是一项技术活,需要综合考虑性能、合法性和稳定性,合理规划和细心维护,可以让你的爬虫项目更加高效和可靠,记得始终遵守法律法规,尊重网站的爬虫协议,这样才能长久地运行你的爬虫项目。