如何在Linux系统上有效监控MySQL数据库的性能和状态?

- 行业动态

- 2024-11-22

- 12

在当今的信息化时代,数据库系统的稳定性和性能对于企业的正常运营至关重要,作为世界上最流行的开源关系型数据库管理系统之一,MySQL广泛应用于各种规模的企业中,为了确保MySQL的高效运行和及时响应潜在问题,监控其状态成为了一项必不可少的任务,本文将介绍如何在Linux环境下对MySQL进行有效监控,包括使用命令行工具、第三方监控软件以及编写简单的脚本来实现自动化监控。

使用命令行工具监控MySQL

1.1 查看MySQL服务状态

在Linux系统中,可以通过以下命令检查MySQL服务的状态:

systemctl status mysqld

或者对于某些发行版:

service mysql status

这些命令可以显示MySQL服务的当前状态,如是否正在运行、启动时间等信息。

1.2 使用mysqladmin工具

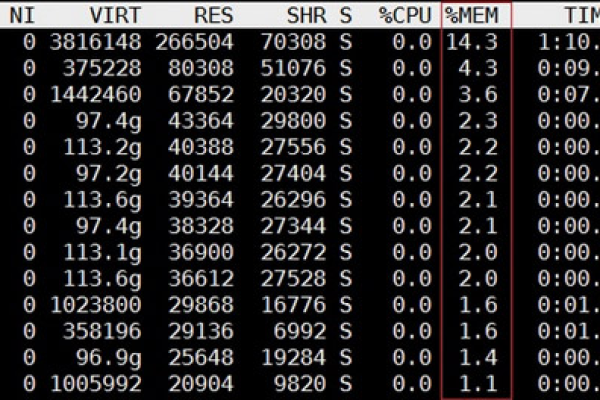

mysqladmin是MySQL自带的一个管理工具,可以用来执行多种管理任务,包括监控,要获取服务器的状态信息,可以使用:

mysqladmin -u root -p status

这将提示你输入root用户的密码,然后显示MySQL服务器的状态,包括连接数、线程数、内存使用情况等。

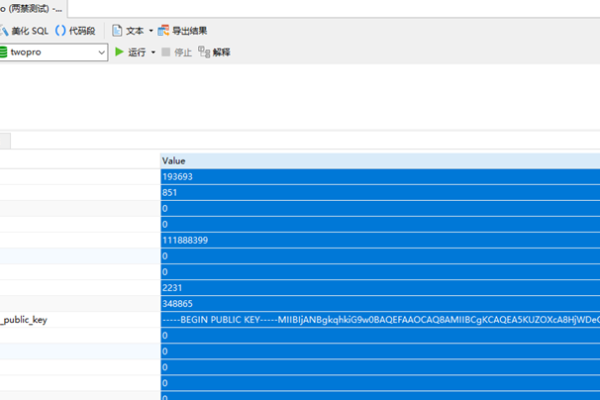

1.3 使用SHOW STATUS命令

登录到MySQL后,可以通过执行SHOW STATUS命令来查看服务器的各种状态变量:

SHOW GLOBAL STATUS LIKE 'Threads%';

这条命令会显示与线程相关的所有状态变量,如线程缓存命中率、创建的线程数等。

使用第三方监控工具

2.1 Zabbix

Zabbix是一个企业级的开源监控解决方案,它可以监控各种参数、日志文件和网络服务,通过安装Zabbix Agent在MySQL服务器上,并配置相应的模板,可以实现对MySQL的全面监控。

2.2 Prometheus + Grafana

Prometheus是一个强大的监控系统和时间序列数据库,而Grafana则是一个开源的数据可视化工具,结合使用这两者,可以创建一个功能强大的监控平台,需要在MySQL服务器上部署Prometheus的MySQL导出器(如prometheus-mysqld-exporter),然后在Prometheus中配置抓取规则,最后在Grafana中创建仪表板来展示数据。

编写脚本实现自动化监控

除了使用现有的工具外,还可以通过编写Shell脚本或Python脚本来实现更定制化的监控需求,一个简单的Shell脚本可以定期检查MySQL的连接数,并在超过阈值时发送警告邮件:

#!/bin/bash

MYSQL_USER="root"

MYSQL_PASSWORD="password"

THRESHOLD=100

获取当前的连接数

CONNECTIONS=$(mysql -u$MYSQL_USER -p$MYSQL_PASSWORD -e "SHOW STATUS LIKE 'Threads_connected';" | awk '{print $2}')

如果连接数超过阈值,则发送警告邮件

if [ $CONNECTIONS -gt $THRESHOLD ]; then

echo "Warning: MySQL connection count exceeded threshold." | mail -s "MySQL Alert" admin@example.com

fi 这个脚本需要根据实际情况调整用户名、密码和阈值。

FAQs

Q1: 如何更改MySQL监控脚本中的电子邮件地址?

A1: 在脚本中找到发送邮件的命令行部分,通常是这样的格式:mail -s "Subject" recipient@example.com,将recipient@example.com替换为你希望接收警告的实际电子邮件地址。

Q2: 如果我想监控更多的MySQL指标,应该怎么办?

A2: 你可以根据需要扩展脚本,添加更多的mysqladmin命令或SHOW STATUS查询来获取额外的指标,也可以考虑使用更高级的监控工具,如Zabbix或Prometheus,它们提供了丰富的插件和模板,可以轻松添加新的监控项。

通过上述方法,你可以在Linux环境下有效地监控MySQL的性能和健康状况,无论是通过命令行工具、第三方软件还是自定义脚本,选择合适的工具和方法可以帮助你及时发现并解决潜在的问题,确保数据库系统的稳定运行。

到此,以上就是小编对于“linux 监控mysql”的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位朋友在评论区讨论,给我留言。