上传速度和下载速度哪一个重要些

- 行业动态

- 2024-02-06

- 3

上传速度和下载速度都重要,但根据使用场景决定哪个更关键。

上传速度和下载速度哪一个重要?

在数字时代,互联网已经成为我们日常生活的一部分,无论是工作、学习还是娱乐,网络的速度都直接影响着我们的体验,通常,当我们讨论网络速度时,会提到两个关键指标:上传速度和下载速度,理解它们之间的区别及各自的重要性是评估和使用网络服务的基础。

上传速度与下载速度的概念

上传速度指的是数据从你的设备传输到网络服务器的速度,通常用于发送文件、视频通话或在任何在线平台上发布内容,而下载速度则是数据从网络服务器传输到你的设备的速度,常用于浏览网页、观看视频、听音乐或下载文件。

上传速度的重要性

上传速度在以下场景中尤为重要:

1、视频通话:进行视频会议或远程授课时,良好的上传速度能确保音视频数据的即时传输,避免通话延迟和画面卡顿。

2、内容创建:对于博主、视频制作者等创作者来说,快速上传速度意味着更高效的内容发布和分享。

3、在线游戏:某些游戏需要玩家上传数据以通知游戏服务器他们的动作,快速的上传速度可以减少游戏中的延迟。

4、远程工作:上传大型文件或文档至云端或公司服务器时,较快的上传速度可以节省时间,提高工作效率。

下载速度的重要性

下载速度在以下场景中至关重要:

1、媒体消费:观看高清视频、电影、电视剧或听音乐时,较高的下载速度可以提供流畅的播放体验,减少缓冲时间。

2、软件更新与下载:下载或更新大型软件和游戏时,较快的下载速度可以显著减少等待时间。

3、大文件下载:从云端备份或下载大文件时,高速的下载能力能够大幅提高数据传输效率。

4、网页浏览:虽然文本和小型图片不需要很高的下载速度,但现代网页常常包含大量的多媒体内容,因此快速的下载速度有助于改善网页加载时间。

平衡上传和下载速度

尽管上传速度和下载速度在不同场景下各有其重要性,但理想情况下,用户应寻求两者的平衡,家庭用户可能需要同时进行视频通话(依赖上传速度)和流媒体播放(依赖下载速度),在这种情况下,一个均衡的网络连接将确保所有活动都能顺畅进行。

无法一概而论上传速度和下载速度哪一个更重要,因为它们在不同的使用场景中扮演着不同的角色,用户在选择网络服务时应根据个人需求和使用习惯来决定对上传速度和下载速度的需求比重。

相关问题与解答

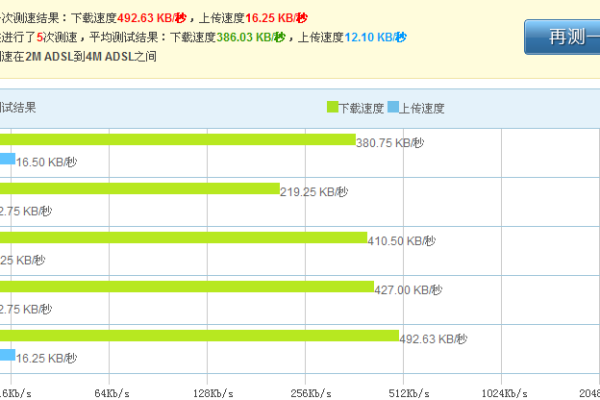

Q1: 我应该如何测试我的上传速度和下载速度?

A1: 你可以使用在线速度测试工具,如Speedtest by Ookla或Fast.com,这些工具能够快速测量你的当前上传和下载速度。

Q2: 为什么有时候我感觉实际的上网体验和我测得的速度不符?

A2: 实际体验可能会受到网络拥堵、Wi-Fi信号干扰、设备性能等多种因素的影响,网络服务提供商定义的速度是理论上的最高速度,并不意味着你随时都能达到这个速度。

Q3: 如何提升我的上传速度和下载速度?

A3: 可以尝试更换更快的网络套餐、使用有线连接代替无线连接、优化路由器设置、升级网络设备、关闭不必要的后台应用等方式来提升速度。

Q4: 对于游戏玩家来说,上传速度和下载速度哪个更重要?

A4: 对于大多数游戏玩家来说,下载速度更为重要,因为它影响到游戏数据的加载时间和媒体内容的流畅播放,对于需要快速反应的多人在线游戏,良好的上传速度同样重要,以确保玩家的动作能够及时被服务器接收。