dnn深度学习

- 行业动态

- 2025-02-04

- 9

深度神经网络(DNN)是人工智能领域中的一种重要模型,它通过模拟人脑神经网络的结构和工作原理,实现了对复杂数据的处理和决策,以下是对DNN的详细解析:

1、基本概念:

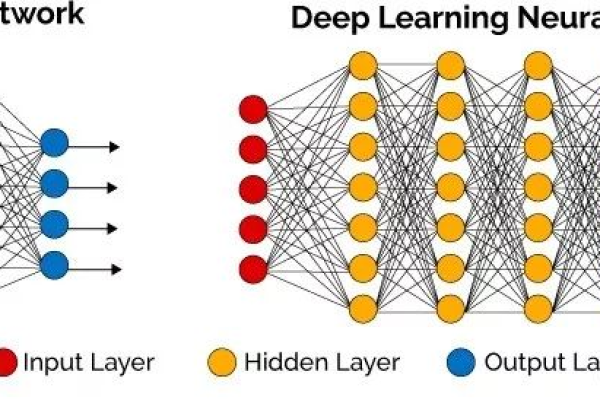

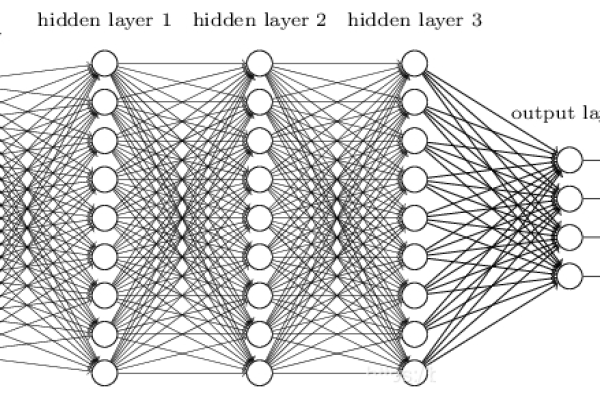

DNN是一种具有多个隐藏层的神经网络模型,其核心在于其深度,即包含多个隐藏层,这些隐藏层通过非线性变换,使得模型能够捕捉到数据中的复杂关系和模式。

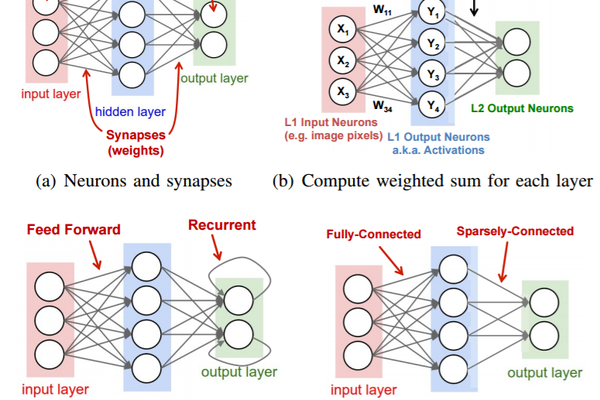

DNN通常由输入层、隐藏层和输出层组成,每一层都包含多个神经元,神经元之间通过权重和偏置进行连接。

2、结构特点:

输入层负责接收原始数据,如图像像素值、文本编码、传感器数据等。

隐藏层位于输入层和输出层之间,是DNN的核心部分,一个DNN可以包含一个或多个隐藏层,每个隐藏层由多个神经元(或称为节点)组成,每个神经元接收来自前一层的输出作为输入,通过加权求和和激活函数变换后产生自己的输出。

输出层负责生成网络的最终输出,其结构和激活函数取决于具体任务的需求,对于分类任务,输出层通常包含与类别数相等的神经元,并使用Softmax激活函数将输出转换为概率分布;对于回归任务,输出层可能只包含一个神经元,并使用线性激活函数或ReLU等非线性激活函数。

3、工作原理:

前向传播:DNN从输入层到输出层的信息传递过程,在前向传播过程中,输入数据通过每一层的神经元进行加权求和和激活函数变换,最终生成输出。

损失函数:用于衡量DNN预测结果与真实标签之间的差距,常见的损失函数包括均方误差(MSE)、交叉熵损失等。

反向传播:DNN训练过程中的一种算法,用于计算损失函数关于权重和偏置项的梯度,这些梯度随后用于更新权重和偏置项,以最小化损失函数。

4、训练过程:

DNN的训练过程是一个权重学习和优化的过程,在训练开始时,网络中的权重和偏置是随机初始化的,通过前向传播计算网络的预测输出,并与真实标签进行比较,计算损失函数,利用反向传播算法计算损失函数关于每个权重和偏置的梯度,并根据这些梯度更新权重和偏置,以最小化损失函数,在DNN的训练中,常用的优化算法包括梯度下降(Gradient Descent)及其变种(如批量梯度下降、随机梯度下降、小批量梯度下降)和更先进的优化算法(如Adam、RMSProp、Adagrad等)。

5、优缺点:

优点:强大的特征学习能力、万能近似能力、并行计算能力和广泛的应用场景。

缺点:过拟合风险、计算量大、模型解释性差和数据依赖性强。

6、应用场景:

DNN已广泛应用于各种复杂问题的域中,如图像识别、语音识别、自然语言处理、推荐系统等多个领域,并取得了显著成效。

7、代码实践:

以下是一个简单的DNN分类模型的代码演示,使用Python和PaddlePaddle框架实现:

import paddle

from paddle import nn, optimizer, tensor

# 定义DNN模型

class MyDNN(nn.Layer):

def __init__(self):

super(MyDNN, self).__init__()

self.fc1 = nn.Linear(784, 256) # 输入层到隐藏层1

self.fc2 = nn.Linear(256, 128) # 隐藏层1到隐藏层2

self.fc3 = nn.Linear(128, 10) # 隐藏层2到输出层

def forward(self, x):

x = paddle.tanh(self.fc1(x)) # 隐藏层1使用tanh激活函数

x = paddle.tanh(self.fc2(x)) # 隐藏层2使用tanh激活函数

x = self.fc3(x) # 输出层不使用激活函数,直接输出预测结果

return x

# 加载数据、构建模型、定义损失函数和优化器(略)

# ...

# 训练模型

for epoch in range(epochs):

for batch_id, data in enumerate(train_loader()):

# 获取数据并转换为Paddle Tensor格式(略)

# ...

# 前向传播

logits = model(x)

# 计算损失函数值

loss = criterion(logits, y)

# 反向传播并更新权重和偏置值(略)

# ...

# 打印训练信息(略)

# ... 以上代码仅为演示目的,实际使用时需要根据具体任务和数据集进行相应的调整,为了简化演示过程,代码中省略了部分实现细节,在实际应用中,还需要考虑如何加载数据、如何定义合适的损失函数和优化器等问题,为了提高模型的泛化能力,还可以使用正则化、批量归一化等技巧对模型进行优化,还可以使用交叉验证、早停等技术来防止过拟合现象的发生,在实际应用中还需要对模型进行充分的测试和评估以确保其性能达到预期要求。

FAQs

1、什么是深度神经网络(DNN)?

深度神经网络(Deep Neural Network,简称DNN)是机器学习领域中的一个重要分支,它通过构建多层次的神经网络结构,使得模型能够更好地学习和理解复杂的数据,从而实现更精确的分类、预测和识别等功能。

2、DNN的基本原理是什么?

DNN的基本原理包括前向传播、损失函数计算和反向传播三个主要步骤,在前向传播过程中,数据从输入层开始,逐层经过隐藏层的非线性变换,最终到达输出层,损失函数用于衡量预测结果与真实标签之间的差距,反向传播则是通过计算损失函数关于每个参数的梯度,并使用这些梯度来更新参数,以最小化损失函数。

小编有话说

深度神经网络(DNN)作为人工智能领域的重要技术之一,以其强大的特征学习能力和非线性处理能力,在众多领域取得了显著的成果,DNN也面临着一些挑战,如过拟合、计算量大和模型解释性差等,随着技术的不断发展和应用需求的不断增长,DNN将在更多领域发挥其潜力,为人类社会带来更多的便利和进步。