腾讯会议能录屏吗

- 行业动态

- 2024-02-05

- 5

腾讯会议支持录屏功能,用户可以在会议中进行屏幕录制。

腾讯会议作为一款流行的在线视频会议软件,被广泛应用于远程工作、在线教育和商务会谈中,随着用户对会议内容记录和分享的需求增加,录屏功能成为了一个重要需求点,腾讯会议能录屏吗?答案是肯定的,腾讯会议提供了录屏功能,允许用户将会议内容录制下来以便于后续的回顾和分析。

录屏功能介绍

腾讯会议的录屏功能能够让用户方便地记录整个会议过程,包括视频画面和音频内容,录制的文件可以用于存档、制作教学材料或是会议纪要,使用该功能时,用户可以在会议进行中随时开始和停止录制,非常灵活。

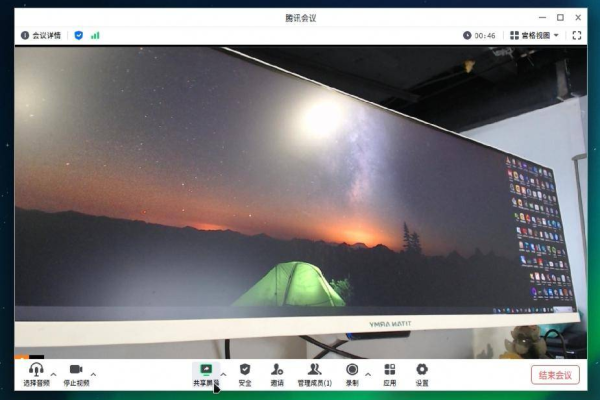

如何开启录屏

1、确保权限:在开始录屏之前,请确保您拥有相应的权限,通常只有会议主持人或管理员有权限启动录制。

2、查找录屏选项:在腾讯会议界面中,找到并点击工具栏上的“更多”按钮,选择“录制”功能。

3、选择录制内容: 您可以选择录制屏幕共享、录制视频或同时录制两者,根据需要选择相应选项。

4、开始录制:点击开始录制按钮后,会有提示告知参会者正在录制,确保透明度与隐私保护。

5、暂停与结束:在录制过程中,您可以随时暂停或结束录制,暂停时不会丢失已录制的内容。

6、保存录制文件:录制结束后,您可以选择保存录制文件到本地,或者上传至云端存储。

录屏技术要点

1、文件格式与质量:录制的视频通常是MP4格式,保证了良好的兼容性与清晰度,用户可以根据需要选择不同的录制质量。

2、存储空间:请注意录屏文件可能会占用较大的存储空间,确保您的设备或云端存储有足够的空间来保存这些文件。

3、网络要求:为了保证录制过程中的稳定性,建议在网络状况良好的情况下使用录屏功能。

安全性与隐私

在使用录屏功能时,需要特别注意的是安全性与隐私问题,确保所有参会者都知晓并同意录制,录制的文件应妥善保管,避免泄露敏感信息。

相关问题与解答

Q1: 腾讯会议的录屏功能是否对所有用户免费开放?

A1: 腾讯会议的基本录屏功能对所有用户提供,但某些高级功能可能需要付费版本才能使用。

Q2: 录制的文件保存在哪里?

A2: 录制的文件默认保存在用户的本地设备上,用户也可以选择将其上传到腾讯会议提供的云存储服务。

Q3: 是否可以编辑录制后的视频?

A3: 腾讯会议提供的是基础的录屏功能,不包含视频编辑功能,如果需要编辑,可以使用第三方视频编辑软件来进行剪辑、添加字幕等操作。

Q4: 如果我是参会者,我能否知道自己是否正在被录制?

A4: 当会议开始录制时,所有参会者都会收到明确的提示,告知他们会议正在进行录制,以确保透明性。

通过上述介绍,我们了解到腾讯会议确实支持录屏功能,并且用户可以根据自己的需求来选择不同的录制选项,不过,使用时应注意遵守相关的法律法规以及公司政策,尊重参与者的隐私权。