如何制作iso文件

- 行业动态

- 2024-02-05

- 5

制作ISO文件需使用刻录软件,选择源文件,进行文件打包成ISO镜像。

制作ISO文件,本质上是将光盘镜像或者特定文件夹及其内容打包成一个单一的文件,这个文件可以用于刻录到光盘上,或者在虚拟机中使用,以下是详细步骤和相关技术介绍:

准备工作

在开始制作ISO文件之前,你需要准备以下几样东西:

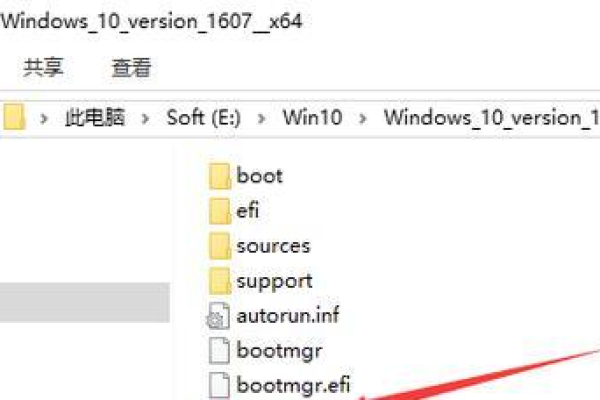

1、原始文件或文件夹:这可以是你要刻录到光盘的数据,比如音频、视频、图片或软件安装包等。

2、ISO制作软件:市面上有很多免费和付费的软件可以用来创建ISO文件,如UltraISO、PowerISO以及开源的mkisofs等。

3、足够空间的硬盘:确保你的硬盘有足够的空间来存放生成的ISO文件。

制作过程

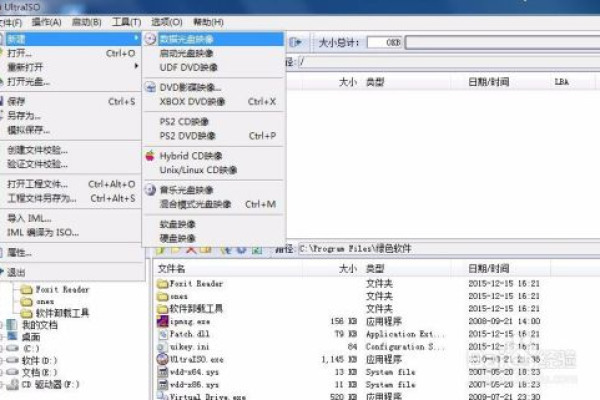

选择软件

根据个人需求选择一个合适的ISO制作软件,对于初学者来说,图形界面的软件可能更容易上手,而命令行工具则对高级用户来说更加灵活。

添加文件

打开你选择的ISO制作软件,将需要制作成ISO文件的文件或文件夹添加到软件中,大多数软件都支持拖放操作,这会让过程变得非常简单。

设置参数

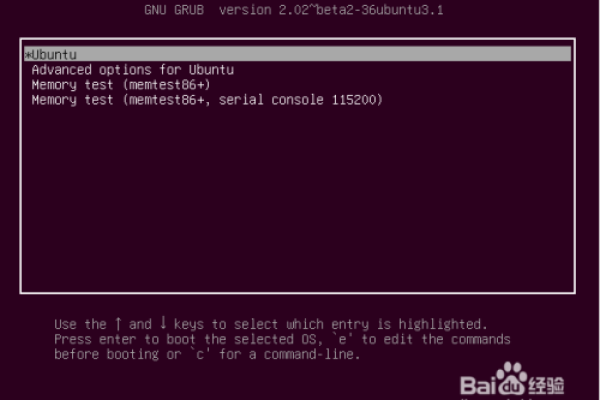

在这一步,你可以设置ISO文件的各种参数,比如文件系统类型(通常为ISO 9660)、卷标、引导信息等,如果你打算创建一个可启动的ISO文件,那么引导信息尤为重要。

创建ISO

确认所有设置无误后,点击“创建”或“生成”按钮开始制作ISO文件,这个过程可能需要一些时间,具体取决于源文件的大小和计算机的性能。

校验ISO

创建完成后,建议使用MD5、SHA1等校验工具对ISO文件进行校验,确保文件没有在创建过程中损坏。

高级技巧

优化大小

有些软件提供压缩选项,可以在不损失数据质量的情况下减小ISO文件的体积。

多会话支持

如果你有多个版本的同一文件或文件夹需要更新,可以使用多会话ISO功能,它允许你在同一个ISO文件中更新或添加内容。

加密与密码保护

为了安全性考虑,有些软件支持为ISO文件添加密码,这样只有知道密码的人才能访问其中的内容。

相关问题与解答

Q1: 制作ISO文件时需要注意哪些版权问题?

A1: 当你制作包含第三方软件或数字内容的ISO文件时,务必确保你有权这么做,未经授权复制和分发版权受保护的内容可能会违反法律。

Q2: 如何验证ISO文件的完整性?

A2: 你可以通过计算并对比ISO文件的哈希值(如MD5或SHA1)来验证其完整性,许多网站在提供ISO下载的同时也会提供相应的哈希值供用户校验。

Q3: 是否可以将多个ISO文件合并成一个?

A3: 是的,存在专门的工具和软件可以将多个ISO文件连接起来形成一个新的ISO文件,但这通常要求各个ISO文件具有相同的结构,并且能够连续读取。

Q4: 制作ISO文件是否会影响原始数据?

A4: 正常情况下,制作ISO文件是一个只读过程,不会影响原始数据,如果过程中出现错误或者使用了某些写入操作,那么原始文件可能会受到影响,在制作ISO文件之前最好备份重要数据。