如何从零开始搭建小程序服务器?

- 行业动态

- 2024-08-29

- 5

搭建小程序服务器是一个涉及多个技术层面的过程,包括服务器选择、环境配置、后端开发、数据库管理以及与小程序前端的接口对接等,以下是详细的步骤和建议:

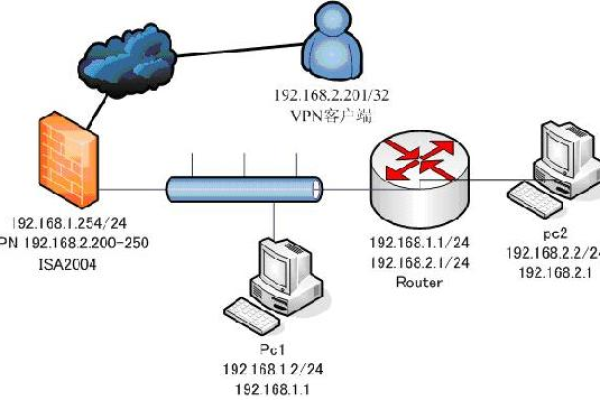

1. 服务器选择

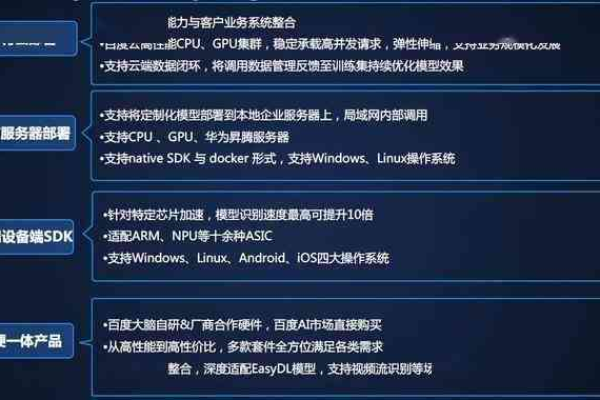

首先需要选择一个适合的服务器,服务器可以是物理服务器或者云服务器,对于大多数小程序开发者来说,云服务器因其灵活性、可扩展性和成本效益而成为首选。

云服务商: 阿里云、腾讯云、AWS、Google Cloud等都提供云服务器服务。

服务器类型: 根据预算和需求选择合适的服务器类型,如计算优化型、内存优化型等。

地域选择: 选择靠近目标用户的服务器地域可以减少延迟,提升用户体验。

2. 环境配置

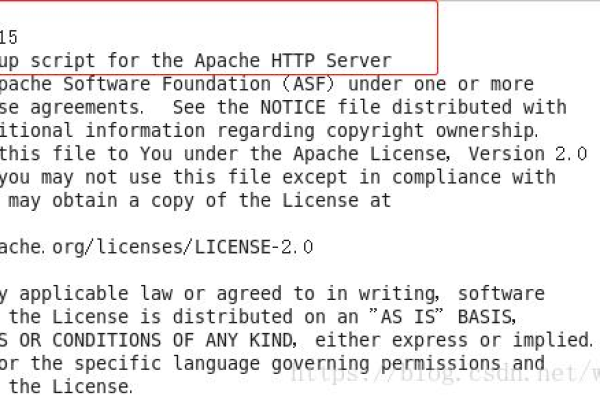

服务器选定后,需要进行环境配置,这通常包括操作系统的选择、必要的软件安装等。

操作系统: Linux或Windows Server是常见的选择,其中Linux更受开发者青睐因其开源和灵活性。

语言环境: 根据后端开发语言(如Node.js、PHP、Java等)安装相应的运行环境和库。

数据库: 安装数据库服务器,如MySQL、MongoDB等,并进行基本配置。

3. 后端开发

后端开发是实现小程序功能的核心部分,涉及到编写处理业务逻辑的代码和与数据库交互的代码。

框架选择: 根据语言选择适合的开发框架,如Express(Node.js)、Laravel(PHP)、Spring Boot(Java)等。

API开发: 设计RESTful API或GraphQL API供小程序前端调用,实现数据交换和功能操作。

安全性考虑: 实现用户认证(如JWT)、数据加密和防御常见网络攻击(如SQL注入、XSS攻击)的措施。

4. 数据库管理

数据库用于存储小程序的数据,如用户信息、内容数据等。

数据库设计: 根据应用需求设计合理的数据库结构。

性能优化: 索引优化、查询优化等,保证数据的快速读写。

备份与恢复: 定期进行数据备份,以防数据丢失。

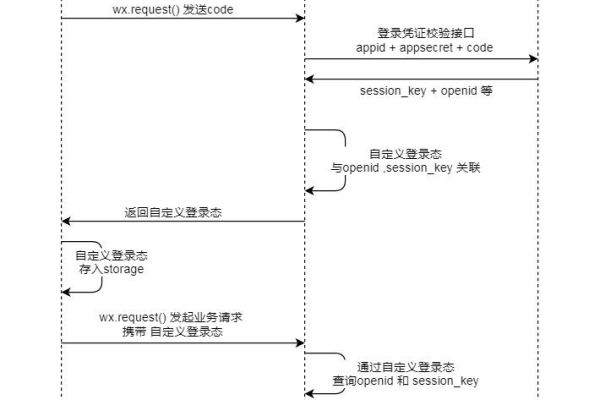

5. 接口对接

最后一步是将小程序前端与服务器后端通过接口进行对接。

接口文档: 提供详尽的接口文档供前端开发者使用。

测试: 进行全面的接口测试,确保接口的稳定性和数据的正确性。

监控与日志: 实施接口调用监控和错误日志记录,便于问题追踪和性能分析。

相关问题与解答

Q1: 如何选择服务器的配置?

A1: 服务器的配置应根据小程序的预期负载和功能复杂度来选择,对于初创项目或小型应用,可以选择较低配置的服务器以节约成本,随着用户量的增长再逐步升级配置,主要考虑CPU核心数、内存大小和带宽。

Q2: 如何保证小程序服务器的安全性?

A2: 保证服务器安全性的措施包括:使用强密码和SSH密钥登录、定期更新系统和应用软件、配置防火墙规则、使用HTTPS、实施数据加密、进行安全破绽扫描和修复等,对敏感操作进行日志记录,以便事后分析和追踪也是重要的安全措施。