大模型训练背后的神秘硬件,服务器的真实面貌是什么?

- 行业动态

- 2024-09-02

- 1

大模型训练的服务器通常配置有高性能的CPU、大容量的内存和高速的硬盘,以及专业的图形处理器(GPU)或者张量处理器(TPU)来加速计算。它们往往放置在具有良好散热和稳定电力供应的环境中,以确保持续高效的运算能力。

大模型训练的服务器通常是指高性能计算(HighPerformance Computing, HPC)服务器,它们具备强大的计算能力、大量的内存和存储空间以及高速的网络连接,这些服务器被设计用来处理复杂的科学计算、数据分析、机器学习和深度学习任务,包括大规模神经网络的训练,小编将详细介绍这种服务器的特点和配置。

硬件配置

处理器(CPU)

大模型训练服务器通常配备有多个高性能的中央处理单元(CPU),这些CPU可能是多核心的高端服务器级处理器,例如Intel Xeon或AMD EPYC系列,它们提供了大量的计算资源来并行处理数据。

图形处理器(GPU)

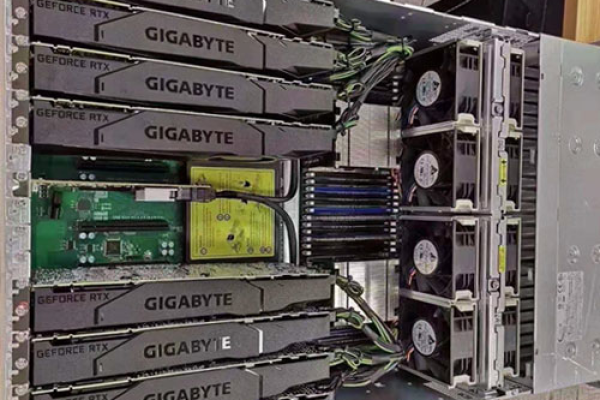

对于深度学习和神经网络的训练而言,图形处理器(GPU)是至关重要的,NVIDIA的Tesla或Quadro系列GPU因其在并行计算方面的优势而被广泛用于大模型训练,一个服务器可能会装备多个GPU以提升计算性能。

内存(RAM)

大模型训练需要巨大的内存容量,因此这类服务器通常会配备TB级别的随机存取存储器(RAM),以便快速读写数据,支持模型训练过程中的数据密集型操作。

存储系统

为了存储大量的训练数据和模型参数,这些服务器往往配备有快速的固态硬盘(SSD)或更大容量的硬盘阵列,使用高速接口如NVMe可以提高数据的读写速度。

冷却系统

由于高性能计算产生的热量巨大,服务器通常配备有高效的冷却系统,这可能包括液冷或先进的风扇和散热片设计。

软件与网络

操作系统和软件栈

大模型训练服务器通常运行Linux操作系统,这是因为Linux提供了良好的支持和优化,适合高性能计算任务,服务器上会安装必要的软件栈,如CUDA和cuDNN库,以支持GPU加速的深度学习框架。

网络连接

为了保证数据传输效率,这些服务器经常通过高速以太网或InfiniBand网络连接在一起,实现节点间的快速通信,这对于分布式训练和数据传输尤为重要。

数据中心布局

大模型训练服务器通常被安置在专业的数据中心内,这些数据中心具有稳定的供电、优秀的冷却系统和物理安全措施,服务器可能会被组织成集群,共享存储和网络资源,以提高整体的运算能力和灵活性。

相关问题与解答

Q1: 如何确保大模型训练服务器的能效比?

A1: 确保高能效比的方法包括使用最新的硬件技术、优化的算法和合理的资源调度策略,选择能效更高的处理器和GPU、实施动态电压频率调整(DVFS)和使用更高效的冷却系统等。

Q2: 大模型训练时,如何平衡计算资源和成本?

A2: 平衡计算资源和成本可以通过多种方式实现,例如选择性价比较高的硬件、利用云计算服务根据需求动态分配资源,以及采用混合精度训练来降低对高精度计算资源的需求,还可以通过优化模型结构和训练流程来减少所需的计算量。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/7969.html