迅雷CDN,它如何改变我们的网络体验?

- 行业动态

- 2024-10-09

- 14

1、概述

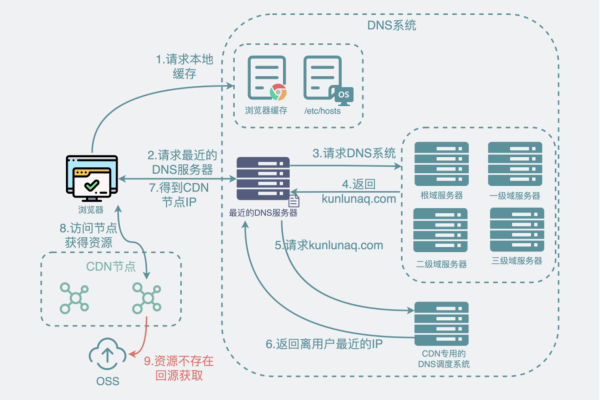

定义:迅雷CDN(Content Delivery Network)是一种通过多个分散的服务器节点提供内容分发服务的网络技术,旨在提高数据传输速度和稳定性。

2、特点

无限节点:迅雷CDN采用独特的无限节点布局,通过连接至千万个家庭路由的赚钱宝设备,将散布于无数家庭的末梢带宽联结起来,形成一张节点均匀密布于全网的带宽资源调度库,实现了对现有CDN行业节点数量高达百倍级的增长。

低成本:由于采用了个人节点,迅雷能够以较低的成本采购到用户的上传带宽,从而大幅降低高质量带宽资源库的成本,实现了相较传统CDN腰斩式的价格下调。

高连通率:迅雷CDN能够提供廉价且连通率极高的CDN资源,满足视频网站、下载、页游、网游等互联网产品的核心服务对象需求。

3、优势

技术创新:迅雷CDN在技术上彻底终结了既有CDN节点瓶颈问题,为移动互联网和互联网+时代的复杂应用满足提供了无限可能。

商业模式革新:迅雷CDN的无限节点布局模式将带动CDN商业模式的全面革新,赋予CDN更符合移动互联网和互联网+时代的全新定义。

服务质量:得益于无限且分布均匀的个人节点,迅雷CDN能够在保证质量的基础上提供更具竞争力的价格和服务。

4、应用场景

视频网站:对于视频公司而言,核心竞争力之一就是带宽成本的降低,这需要CDN技术的支持,并且视频的CDN需要一些针对性的优化。

游戏下载与升级:在游戏下载、升级等场景需要通过CDN技术来提升用户体验。

电商网站:在双十一等高峰期,电商网站的CDN需求其实很高。

5、挑战

稳定性与速度:由于CDN的来源是个人用户,所以稳定性、速度跟传统CDN相比都存在差距,需要技术手段提升。

安全性问题:需要占用机器的上传和存储,可能会引发用户对安全性的担忧。

6、未来展望

推动行业发展:随着技术的不断进步和市场需求的变化,迅雷CDN有望继续推动CDN行业的发展,为更多企业和个人用户提供高效、稳定的内容分发服务。

迅雷CDN以其独特的无限节点布局、低成本和高连通率等优势,在CDN领域展现出强大的竞争力,面对稳定性、速度和安全性等方面的挑战,迅雷CDN仍需不断创新和完善。

| 特征 | 迅雷CDN (内容分发网络) 描述 |

| 定义 | 迅雷CDN是一种基于P2P技术的全球加速网络,旨在提供快速、稳定的互联网内容分发服务。 |

| 服务对象 | 主要面向网站、移动应用、视频、游戏、软件等互联网内容提供商。 |

| 核心技术 | P2P技术、智能路由、负载均衡、内容缓存等。 |

| 优势 | 加速效果显著:通过P2P技术实现节点之间的内容共享,降低网络延迟,提高访问速度。覆盖范围广:全球节点分布,覆盖亚洲、欧洲、美洲、大洋洲等地区。成本效益高:相比传统CDN,成本更低,性价比更高。 |

| 应用场景 | 网站加速:提高网站访问速度,提升用户体验。视频点播:实现视频的快速播放,降低播放卡顿现象。移动应用加速:提高移动应用的下载速度,提升用户满意度。游戏加速:降低游戏延迟,提高游戏体验。 |

| 服务特点 | 智能路由:根据用户地理位置,智能选择最优节点,提高访问速度。负载均衡:合理分配访问请求,确保节点稳定运行。内容缓存:缓存热门内容,减少访问请求,提高网络效率。 |

| 合作案例 | 腾讯视频:通过迅雷CDN加速,实现视频内容的快速播放。爱奇艺:利用迅雷CDN提升视频点播速度,降低卡顿现象。网易游戏:借助迅雷CDN实现游戏加速,提高游戏体验。 |