gpu云服务器如何收费(gpu云服务器如何收费使用)

- 行业动态

- 2024-03-04

- 10

GPU云服务器的收费通常基于所选GPU型号、服务器配置、使用时长和数据流量,可能还包括操作系统和软件许可费用。

随着人工智能、深度学习和高性能计算的兴起,GPU云服务器成为了这些领域研究者和开发者的重要工具,GPU云服务器是指配备了高性能图形处理单元(GPU)的云计算资源,能够提供强大的并行处理能力,尤其适用于需要大量计算的任务,用户可以根据自己的需求租用这些服务器,但了解其收费方式对于合理规划使用成本至关重要。

计费方式

GPU云服务器的收费通常基于以下几个维度:

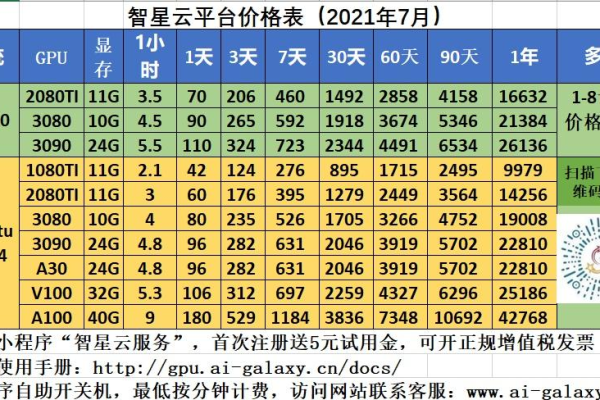

1、按使用时长计费:这是最常见的计费模式,即按照用户实际占用并使用GPU服务器的时间进行收费。

2、按性能等级计费:不同的GPU型号和配置会有不同的收费标准,高端的NVIDIA Tesla V100 GPU会比中端的NVIDIA P4 GPU收费更高。

3、预付费和后付费:用户可以选择预先支付一定费用来获得一定量的使用时间,也可以在使用后根据实际用量进行结算。

4、长期承诺优惠:许多云服务提供商对长期租用GPU服务器的用户给予一定的折扣。

使用策略

为了有效控制成本,用户可以采取以下几种策略:

1、选择合适的GPU类型:根据应用的需求选择性价比最高的GPU型号。

2、优化任务执行效率:通过算法优化和并行计算技术提高GPU利用率,减少运行时间。

3、利用Spot实例:某些云服务如Amazon AWS提供的Spot实例可以在不影响性能的前提下节约成本。

4、预留实例:如果计划长期使用,可以考虑购买预留实例来享受更低的小时费率。

5、监控资源使用情况:实时监控GPU的使用情况,避免资源浪费。

实例分析

以Amazon Web Services (AWS)为例,其GPU云服务器的收费包括以下部分:

1、实例费用:根据所选的GPU实例类型和数量计费。

2、运行时间费用:按小时计费,精确到秒。

3、数据传输费用:在数据传入和传出时可能会产生额外费用。

4、存储费用:使用的SSD或HDD存储空间也会产生费用。

5、操作系统和软件许可:某些特殊的操作系统或软件可能涉及额外的许可费。

相关问题与解答

Q1: 如何估算我的GPU云服务器使用成本?

A1: 您可以通过云服务提供商提供的定价计算器,结合您的具体需求和使用时长来估算成本,确保考虑到所有相关的费用组成部分。

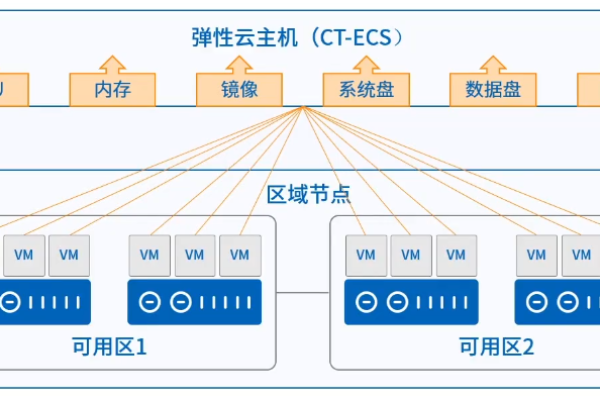

Q2: 是否可以随时增加或减少GPU资源?

A2: 是的,大多数云服务提供商支持弹性伸缩,允许用户根据需要随时调整资源规模。

Q3: 我应该如何选择合适的GPU云服务器配置?

A3: 这取决于您的具体应用场景,如果您需要进行大量的图形渲染,可能需要高性能的图形卡;而如果是机器学习训练,则需要高计算能力的GPU,考虑性能、成本和可用性来决定最佳选择。

Q4: 使用GPU云服务器有哪些典型的应用场景?

A4: 包括AI模型训练、科学计算模拟、视频渲染、数据分析等高性能计算任务。

GPU云服务器提供了灵活且强大的计算资源,但也伴随着一定的成本,用户在选择和使用时需仔细评估自己的需求,并利用各种策略和工具来优化成本效益。