上一篇

在HTML中创建两列表格,需使用`

标签嵌套

定义行,每行内放置两个`单元格分别承载左右列内容,通过逐行添加双单元格结构即可实现分列效果。

在HTML中创建两列表格是展示结构化数据的常见需求,无论是产品对比、数据统计还是信息分类都很实用,下面详细说明实现方法及注意事项:

基础表格结构(使用 <table>

通过HTML原生表格标签即可快速创建两列布局:

<table>

<tr> <!-- 第一行 -->

<td>第一列内容</td>

<td>第二列内容</td>

</tr>

<tr> <!-- 第二行 -->

<td>新行第一列</td>

<td>新行第二列</td>

</tr>

</table>

<tr> 定义表格行(每行包含两列)<td> 定义单元格(每行两个 <td> 即形成两列)

添加表头提升可访问性

使用 <th> 标签定义列标题,增强语义化和SEO友好性:

<table>

<tr>

<th>属性名称</th> <!-- 第一列标题 -->

<th>属性值</th> <!-- 第二列标题 -->

</tr>

<tr>

<td>颜色</td>

<td>蓝色</td>

</tr>

</table> 通过CSS优化样式

添加基础样式使表格更易读:

table {

width: 100%; /* 表格宽度 */

border-collapse: collapse; /* 合并边框 */

}

td, th {

border: 1px solid #ddd; /* 单元格边框 */

padding: 12px; /* 内边距 */

text-align: left; /* 文本对齐 */

}

th {

background-color: #f2f2f2; /* 标题背景色 */

} 响应式适配技巧

在移动端折叠为单列布局(使用媒体查询):

@media (max-width: 600px) {

tr {

display: block; /* 行转为块级元素 */

}

td {

display: block; /* 单元格堆叠显示 */

width: 100%!important;

}

} 替代方案(非表格场景)分栏,推荐CSS布局:

<div class="two-columns">

<div>左侧内容</div>

<div>右侧内容</div>

</div>

<style>

.two-columns {

display: grid;

grid-template-columns: 1fr 1fr; /* 等宽两列 */

gap: 20px; /* 列间距 */

}

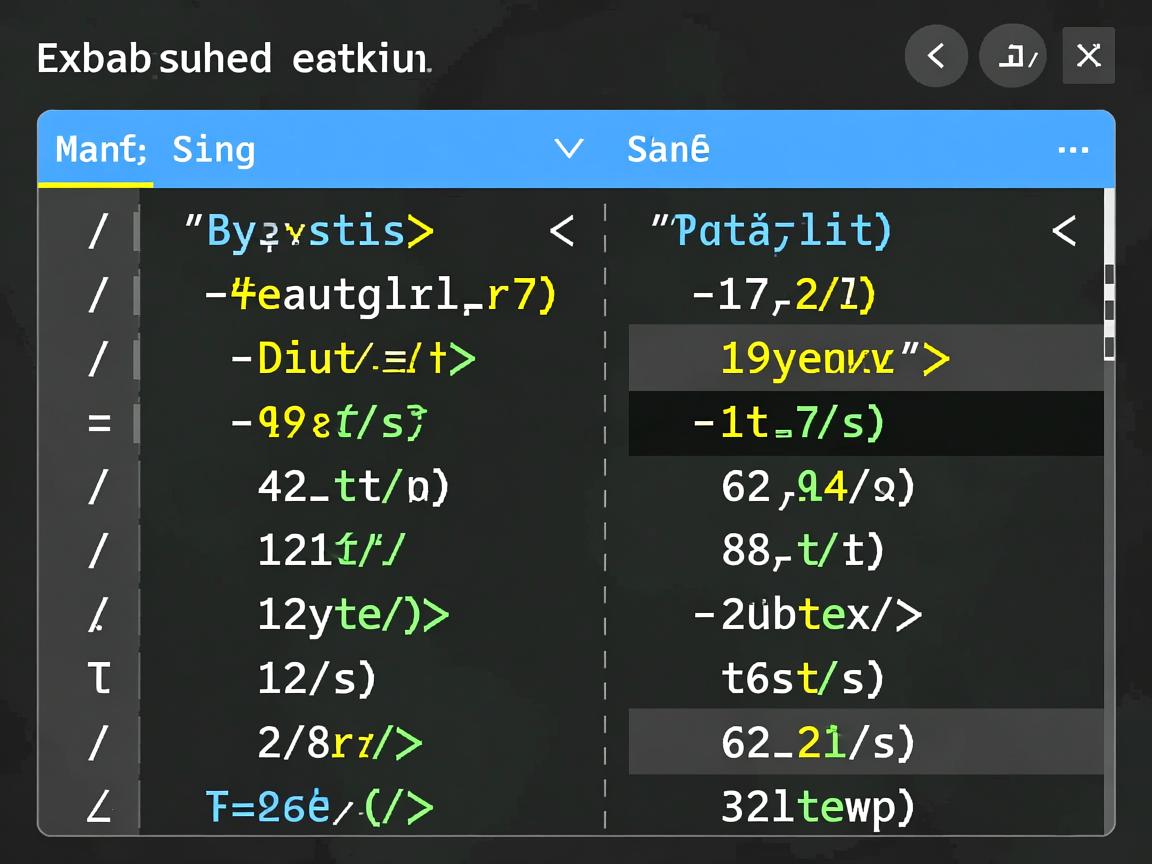

</style> 最佳实践与SEO建议

- 语义化优先:仅数据类内容使用表格,布局场景用CSS必选**:

<th> 标签帮助搜索引擎理解列含义

- 避免嵌套:复杂结构影响加载速度和SEO评分

- ARIA属性:添加

role="table" 提升无障碍访问

引用说明:本文内容参考MDN Web文档-表格基础及W3C表格技术标准,代码遵循Web语义化规范。

通过HTML原生表格标签即可快速创建两列布局:

<table>

<tr> <!-- 第一行 -->

<td>第一列内容</td>

<td>第二列内容</td>

</tr>

<tr> <!-- 第二行 -->

<td>新行第一列</td>

<td>新行第二列</td>

</tr>

</table>

<tr>定义表格行(每行包含两列)<td>定义单元格(每行两个<td>即形成两列)

添加表头提升可访问性

使用 <th> 标签定义列标题,增强语义化和SEO友好性:

<table>

<tr>

<th>属性名称</th> <!-- 第一列标题 -->

<th>属性值</th> <!-- 第二列标题 -->

</tr>

<tr>

<td>颜色</td>

<td>蓝色</td>

</tr>

</table> 通过CSS优化样式

添加基础样式使表格更易读:

table {

width: 100%; /* 表格宽度 */

border-collapse: collapse; /* 合并边框 */

}

td, th {

border: 1px solid #ddd; /* 单元格边框 */

padding: 12px; /* 内边距 */

text-align: left; /* 文本对齐 */

}

th {

background-color: #f2f2f2; /* 标题背景色 */

} 响应式适配技巧

在移动端折叠为单列布局(使用媒体查询):

@media (max-width: 600px) {

tr {

display: block; /* 行转为块级元素 */

}

td {

display: block; /* 单元格堆叠显示 */

width: 100%!important;

}

} 替代方案(非表格场景)分栏,推荐CSS布局:

<div class="two-columns">

<div>左侧内容</div>

<div>右侧内容</div>

</div>

<style>

.two-columns {

display: grid;

grid-template-columns: 1fr 1fr; /* 等宽两列 */

gap: 20px; /* 列间距 */

}

</style> 最佳实践与SEO建议

- 语义化优先:仅数据类内容使用表格,布局场景用CSS必选**:

<th>标签帮助搜索引擎理解列含义 - 避免嵌套:复杂结构影响加载速度和SEO评分

- ARIA属性:添加

role="table"提升无障碍访问

引用说明:本文内容参考MDN Web文档-表格基础及W3C表格技术标准,代码遵循Web语义化规范。