cdn平台优点

- 行业动态

- 2025-03-12

- 4

CDN 平台优点全解析

一、加速内容分发

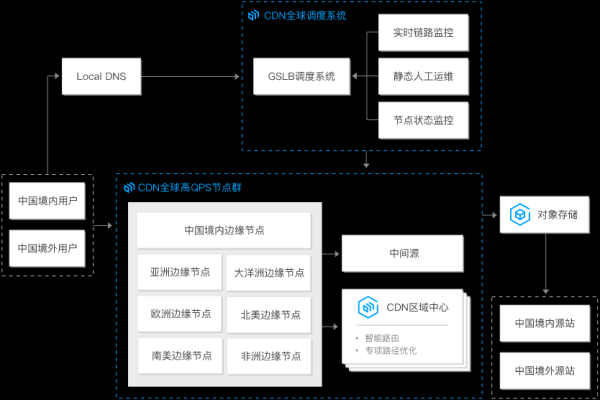

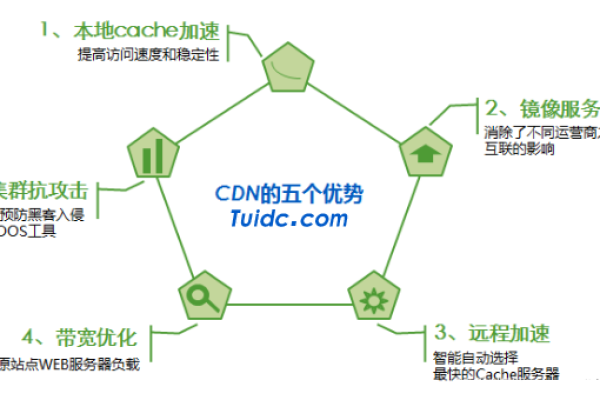

CDN(内容分发网络)通过在全球多个节点存储和分发内容,极大地缩短了用户与服务器之间的物理距离,当用户请求某个内容时,CDN 能够智能地将请求定向到离用户最近的节点,从而显著减少数据传输时间,加快内容的加载速度,一个位于亚洲的用户访问位于欧洲的服务器上的图片,如果未使用 CDN,可能需要经过多个网络节点的跳转,传输延迟较高;而使用 CDN 后,该图片可能在亚洲本地的节点就有缓存,几乎可以瞬间呈现给用户,大大提升了用户体验。

| 对比维度 | 未使用 CDN | 使用 CDN |

| 内容传输时间 | 较长,受地理位置限制大 | 极短,就近获取内容 |

| 用户体验 | 加载缓慢,可能导致用户流失 | 快速加载,提升用户满意度 |

二、减轻源服务器负载

源服务器在面对大量用户并发请求时,往往承受着巨大的压力,CDN 平台能够分担源服务器的流量压力,大部分用户的请求由 CDN 节点直接响应,只有当 CDN 节点没有命中所需内容时,才会回溯到源服务器获取,这就好比一场大型音乐会的售票,源服务器是总售票处,如果没有 CDN,所有观众都涌向总售票处买票,会造成拥堵;而有了 CDN,就像在各个城市设立了分售票点,大部分观众可以在分售票点买到票,只有少数特殊情况才需要去总售票处,有效避免了源服务器因过度负载而崩溃的情况。

三、提高内容可用性

CDN 具有分布式的特点,即使某个地区的网络出现故障或 CDN 节点出现问题,其他地区的节点仍然可以正常为用户提供服务,这意味着内容不会因为局部的网络问题而无法访问,保障了内容的高可用性,某地区遭受自然灾害导致网络中断,未使用 CDN 的网站在当地可能完全无法访问;而使用 CDN 的网站,用户可以通过其他地区的节点继续访问,不影响正常的业务运营。

| 情况 | 未使用 CDN | 使用 CDN |

| 局部网络故障 | 网站无法访问 | 可通过其他节点正常访问 |

| 节点故障 | 部分或全部服务中断 | 其他节点仍可提供服务 |

四、增强安全性

CDN 平台通常具备一定的安全防护机制,如 DDoS(分布式拒绝服务)攻击防御,它可以识别并过滤掉反面流量,保护源服务器免受攻击,CDN 还可以对传输的数据进行加密处理,确保数据在传输过程中的安全性,一家电商企业在促销活动期间容易受到 DDoS 攻击,使用 CDN 后,CDN 能够及时拦截大量的反面攻击流量,保证网站的正常访问,避免因攻击导致的业务损失,并且保障用户的支付等敏感信息安全。

五、利于搜索引擎优化(SEO)

网站加载速度是搜索引擎排名的重要因素之一,使用 CDN 能够加快网站内容的加载速度,从而提高网站在搜索引擎中的排名,更快的加载速度意味着搜索引擎爬虫能够更高效地抓取网站内容,也有利于提高网站的曝光率和流量,两个内容相似的网站,使用 CDN 加速后的网站在搜索引擎结果页面中可能会更靠前,吸引更多的用户点击访问。

| 因素 | 未使用 CDN | 使用 CDN |

| 网站加载速度 | 较慢,影响排名 | 较快,有助于提升排名 |

| 搜索引擎爬虫抓取效率 | 低 | 高 |

相关问题与解答

问题 1:CDN 是否适合所有类型的网站?

答:虽然 CDN 有很多优点,但并非对所有网站都是绝对必要的,对于小型个人博客或流量较低的网站,如果预算有限且对性能要求不是特别高,可能暂时不需要使用 CDN,但对于流量较大、对用户体验要求较高、有全球用户群体的商业网站、电商平台、在线视频平台等,使用 CDN 能够带来显著的性能提升和竞争优势,是非常值得考虑的。

问题 2:使用 CDN 会增加成本吗?

答:使用 CDN 通常会有一定的成本投入,CDN 服务提供商一般会根据流量的使用量、带宽占用、节点数量等因素来收取费用,不过,从长远来看,CDN 带来的性能提升、用户满意度提高以及潜在的业务增长等收益,往往远远超过其成本支出,市场上也有各种不同价格和服务套餐的 CDN 提供商可供选择,企业可以根据自身的需求和预算来挑选适合自己的 CDN 服务。