如何看Apache的端口号(apache的端口号)

- 行业动态

- 2024-03-03

- 4

要查看Apache的端口号,可查看其配置文件httpd.conf中定义的Listen指令,或通过命令行工具如netstat查询正在使用的端口。

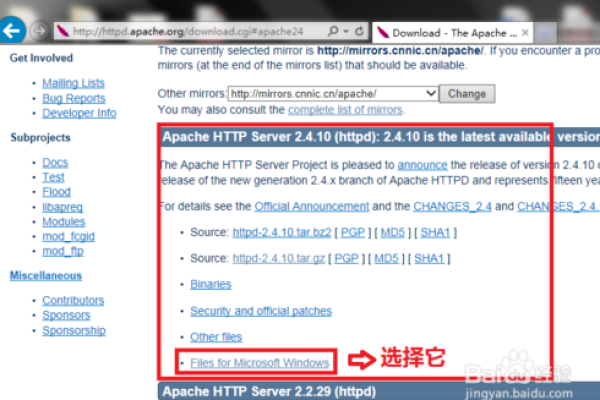

如何查看Apache的端口号

在管理和维护Apache Web服务器的过程中,了解当前Apache服务所使用的端口号是一项基本而重要的技能,端口号是用于区分不同网络服务的标识,确保数据能够正确地流向对应的应用程序,以下是几种查看Apache端口号的方法:

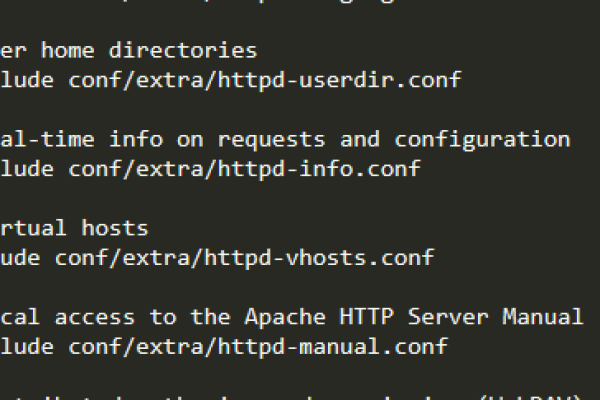

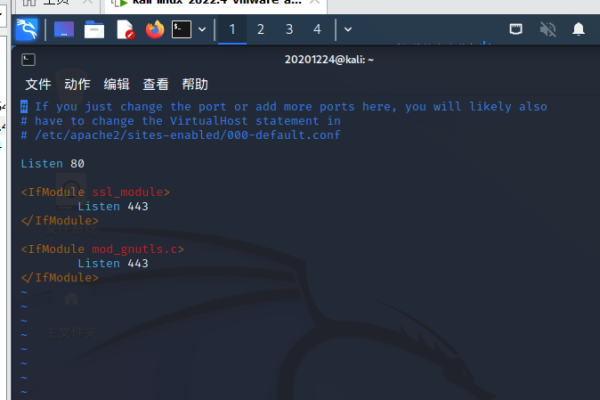

1、查看Apache配置文件

最直接的方法是检查Apache的配置文件,通常位于/etc/httpd/conf/httpd.conf或/etc/apache2/apache2.conf(取决于你的操作系统和Apache安装),在配置文件中,你可以查找到如下类似的行:

Listen 80

这表示Apache监听的是80端口,这是HTTP的默认端口,如果配置了SSL,可能还会看到:

Listen 443 https

这代表Apache同时监听443端口,用于HTTPS通信。

2、使用netstat命令

netstat工具可以显示网络连接、路由表以及网络接口统计信息,通过以下命令,可以查看Apache正在使用的端口:

netstat -tuln | grep apache

或者

netstat -tuln | grep httpd

上述命令中的-tuln选项分别代表TCP协议、UDP协议、监听状态和以数字形式显示服务。grep用来过滤出包含“apache”或“httpd”的行,从而找到相关的端口信息。

3、使用ss命令

ss是netstat的替代工具,它能够提供更快且更详细的输出,使用ss命令查看Apache端口的方式如下:

ss -tuln | grep apache

或者

ss -tuln | grep httpd

4、检查Apache启动脚本

在某些系统中,Apache的启动脚本也可能包含端口信息,在Apache的启动脚本/etc/init.d/httpd或/etc/init.d/apache2中可能会指明端口号。

5、查看运行中的Apache进程

使用ps命令可以查看Apache的进程信息,包括它监听的端口:

ps aux | grep httpd

或者,如果你知道Apache的主进程ID (PID),可以使用:

lsof -i :<端口号> -a -p <PID> -d cwd:/proc/<PID>/fd

替换<端口号>和<PID>为实际的值,来查找特定进程打开的网络连接信息。

相关问题与解答:

Q1: 如果Apache配置文件中没有明确指定端口号怎么办?

A1: 如果在配置文件中未找到明确的Listen指令,那么Apache可能使用的是默认端口80(HTTP)或443(HTTPS),也可以检查是否有其他配置文件包含了端口设置。

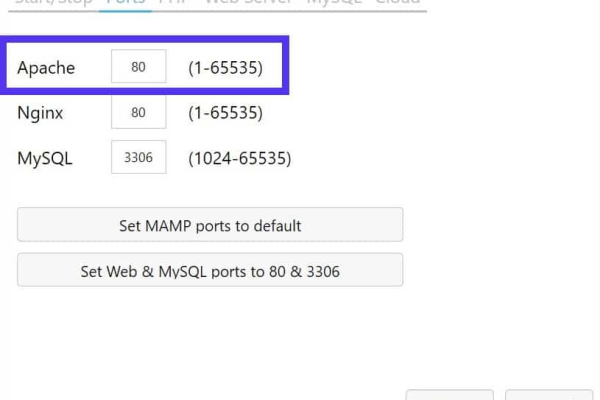

Q2: 如何在Apache中更改监听的端口号?

A2: 要更改Apache监听的端口,需要编辑Apache的配置文件,修改Listen指令的端口号,然后重启Apache服务使更改生效。

Q3: Apache监听的端口被占用怎么办?

A3: 如果Apache想要监听的端口已经被其他服务占用,你需要更改Apache的配置,让其监听另一个未被占用的端口,或者停止占用该端口的服务。

Q4: 如何查看除了Apache之外的其他服务监听的端口?

A4: 你可以使用netstat -tuln或ss -tuln命令查看系统上所有服务的监听端口,不局限于Apache,如果想要查看特定服务的端口,可以通过grep过滤相应的关键字。