Android运行难题解析,如何解决常见运行问题?

- 行业动态

- 2025-03-06

- 5

Android运行问题

1、Gradle构建错误:

原因:Gradle版本不兼容、依赖项冲突或配置错误等。

解决方案:检查Gradle版本与项目兼容性,解决依赖项冲突,清理并重新构建项目。

2、运行时崩溃:

原因:代码错误、内存泄漏或设备兼容性问题。

解决方案:查看日志定位崩溃位置,修复代码错误,确保应用在多种设备上正常运行。

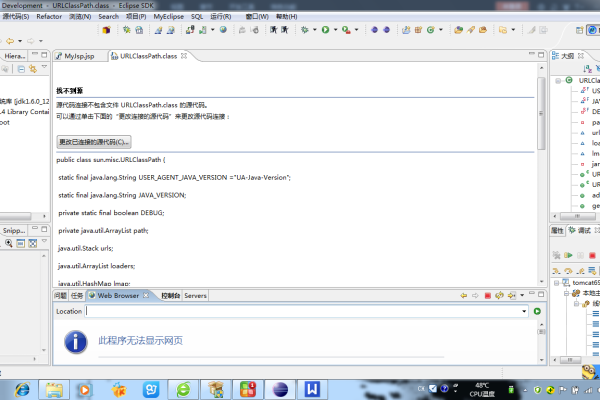

3、布局文件问题:

原因:布局文件语法错误或界面显示异常。

解决方案:检查布局文件语法,使用Android Studio的布局预览功能检查界面效果。

4、权限问题:

原因:未正确配置所需权限。

解决方案:在AndroidManifest.xml中声明权限,并在运行时请求必要权限。

5、设备兼容性问题:

原因:应用未适配不同屏幕尺寸和分辨率。

解决方案:使用不同设备测试,确保应用在各种设备上正常运行。

6、网络连接问题:

原因:网络连接不稳定或无网络连接。

解决方案:检查网络状态,处理网络请求异常,确保应用在无网络时能适当处理。

7、内存泄漏问题:

原因:内存泄漏导致应用性能下降或崩溃。

解决方案:使用Android Studio的内存分析工具检查并优化代码以减少内存使用。

8、应用启动速度慢:

原因:代码优化不当或资源加载过慢。

解决方案:优化代码逻辑,减少不必要的资源加载,使用性能优化工具。

9、依赖项冲突:

原因:项目中存在多个版本的同一个依赖项。

解决方案:检查依赖项冲突,使用合适的依赖项版本管理策略。

相关问题与解答

1、如何检查Android应用的日志输出?

解答:在Android Studio中,可以通过“View” -> “Tool Windows” -> “Logcat”来查看应用的日志输出,日志输出对于定位运行时错误和崩溃非常重要。

2、如何解决Android应用在特定设备上显示异常的问题?

解答:确保使用了适当的布局和资源文件来支持不同的屏幕尺寸和分辨率,在不同设备上进行测试,使用Android Studio的布局检查器来预览应用在不同设备上的显示效果,如果问题仍然存在,可以针对特定设备进行自定义布局调整。