墨白cdn

- 行业动态

- 2025-03-12

- 7

墨白 CDN:全方位解析

一、墨白 CDN

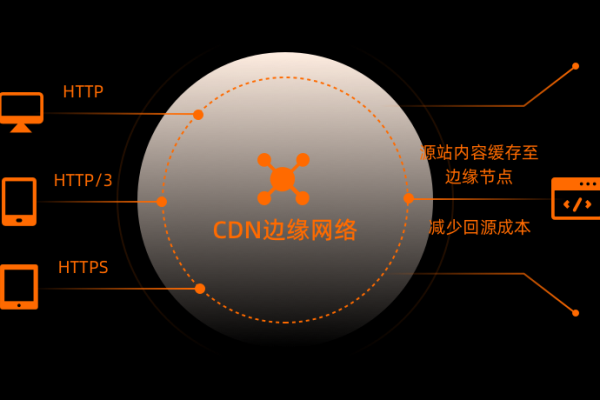

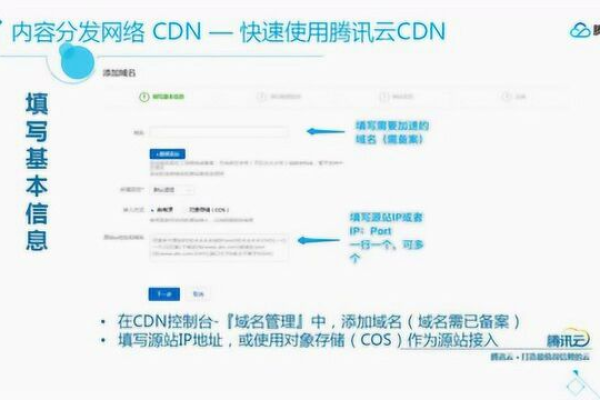

墨白 CDN 是一种内容分发网络服务,旨在通过在多个地理位置分布的服务器节点缓存和分发内容,提高用户访问网站或应用程序的速度和性能,它能够将源站的内容高效地传输到不同区域的用户终端,减少数据传输延迟,提升用户体验。

| 特点 | 描述 |

| 分布式架构 | 墨白 CDN 拥有广泛的节点网络,覆盖全球多个地区,确保内容能够快速、稳定地传输到用户所在位置。 |

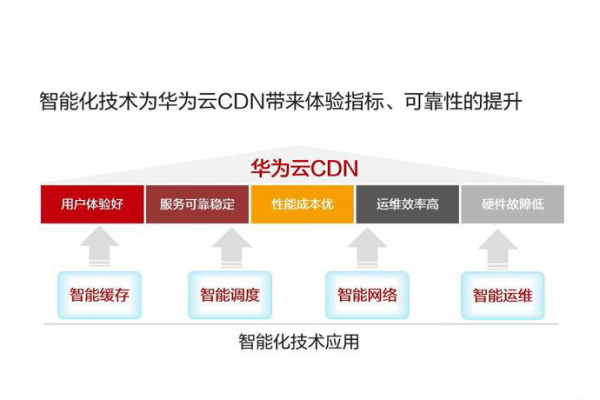

| 智能缓存机制 | 能够根据内容的热度、更新频率等因素,智能地缓存数据,提高缓存命中率,进一步提升访问速度。 |

| 高可靠性 | 具备冗余设计和故障转移机制,即使部分节点出现故障,也能保证服务的连续性,确保用户的访问不受影响。 |

二、墨白 CDN 的工作原理

1、内容缓存

当用户首次请求某个资源时,墨白 CDN 会从源站获取该资源,并在距离用户较近的节点上进行缓存。

后续用户请求相同资源时,CDN 节点可以直接提供缓存的内容,无需再次从源站获取,大大缩短了响应时间。

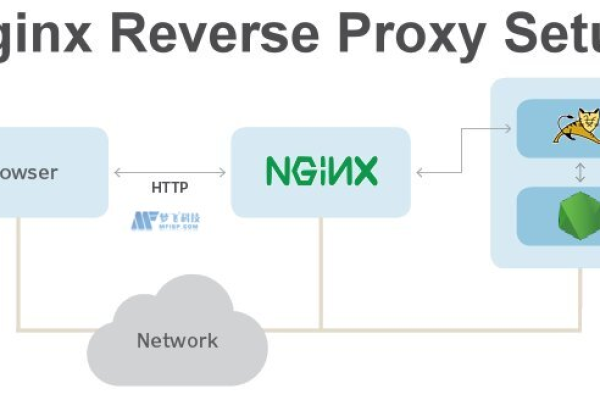

2、请求路由

墨白 CDN 会根据用户的地理位置、网络状况等信息,将用户的请求路由到最合适的节点。

这样可以确保用户能够以最快的速度获取所需内容,提高访问效率。

3、回源处理

对于未缓存的内容或缓存过期的内容,墨白 CDN 会代表用户向源站发起请求,获取最新的内容。

然后将新内容缓存到节点上,以便后续用户访问。

三、墨白 CDN 的优势

1、提升网站性能

显著加快页面加载速度,减少用户等待时间,研究表明,页面加载时间每缩短 1 秒,用户满意度可提高约 10%。

优化图片、视频等多媒体资源的传输,提高播放流畅度。

2、减轻源站压力

分担源站的带宽需求,降低源站服务器的负载,在高流量时期,CDN 能够有效地应对流量高峰,防止源站崩溃。

减少源站的网络攻击风险,因为 CDN 节点可以分散攻击流量,保护源站安全。

3、可用性

确保在全球范围内用户都能稳定访问内容,不受地域限制,无论用户身处何地,墨白 CDN 都能为其提供快速的服务。

提高内容的抗干扰能力,即使在部分网络故障的情况下,也能通过其他节点为用户提供服务。

四、墨白 CDN 的应用场景

1、网站加速

各类企业网站、电子商务网站、新闻媒体网站等都可以通过墨白 CDN 提升访问速度,吸引更多用户,提高业务转化率。

一个电商网站使用墨白 CDN 后,页面加载时间从原来的 5 秒缩短到 1 秒,购物车放弃率降低了 20%。

2、移动应用加速

对于移动应用程序,墨白 CDN 可以优化图片、视频、音频等资源的加载,提高应用的响应速度和用户体验。

一款视频播放应用使用墨白 CDN 后,视频缓冲时间明显减少,用户观看时长增加了 30%。

3、在线游戏加速

降低游戏的延迟和卡顿,提高游戏的流畅性和稳定性,在游戏中,毫秒级的延迟都可能影响玩家的体验,墨白 CDN 能够帮助游戏开发者解决这些问题。

五、墨白 CDN 的相关问题与解答

1、问题:墨白 CDN 如何确保数据的安全性?

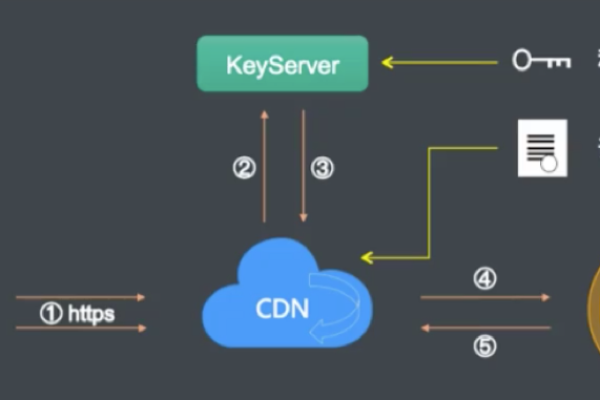

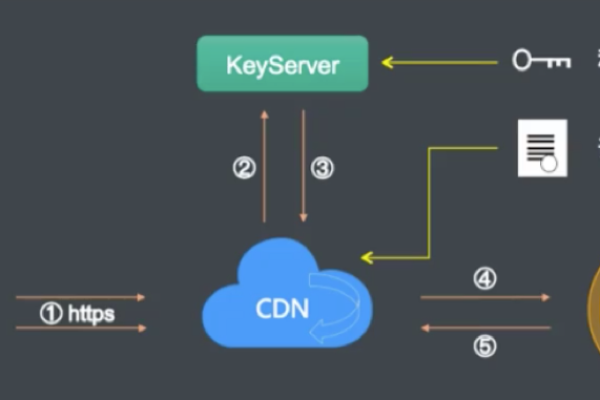

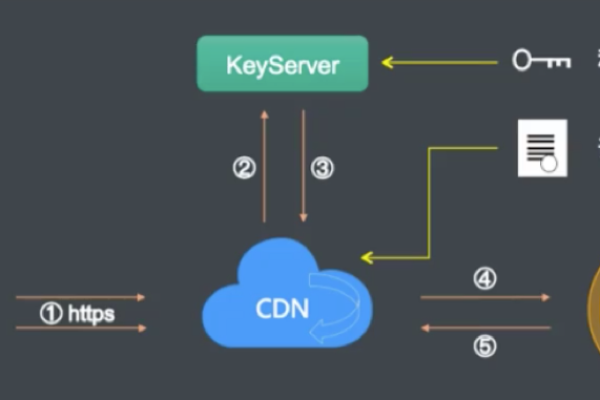

解答:墨白 CDN 采用多种安全技术来保障数据安全,数据传输过程中使用加密协议,如 HTTPS,防止数据被窃取或改动,对缓存的数据进行定期验证和更新,确保数据的一致性和准确性,还具备访问控制机制,只有授权的用户才能访问特定的内容,墨白 CDN 会不断监测网络安全威胁,及时采取防护措施,应对各种攻击。

2、问题:使用墨白 CDN 会增加成本吗?

解答:从短期来看,使用墨白 CDN 可能会有一定的成本投入,主要包括 CDN 服务费用等,从长期来看,它带来的收益远远超过成本,通过提升网站性能和用户体验,可以增加用户的留存率和业务转化率,从而带来更多的收入,相比因网站性能差导致的用户流失和业务损失,使用墨白 CDN 的成本是非常值得的,墨白 CDN 的收费模式通常比较灵活,可以根据不同的需求和使用量进行调整,以满足不同用户的成本预算。

墨白 CDN 作为一种强大的内容分发网络服务,具有诸多优势和广泛的应用场景,它能够为网站和应用程序提供高效、稳定、安全的加速服务,帮助企业提升竞争力,为用户提供更好的体验,在选择和使用墨白 CDN 时,用户可以根据自己的实际需求进行合理的配置和优化,以充分发挥其作用。