如何在Linux中查看帮助信息?

- 行业动态

- 2024-11-20

- 8

man 命令查看帮助文档, man ls。

在Linux操作系统中,查看帮助文档是用户学习和掌握命令行工具的重要途径,本文将详细介绍如何在Linux系统中查看各种帮助信息,包括命令帮助、配置文件帮助和编程接口帮助等。

一、查看命令帮助

1、--help选项:大多数Linux命令都支持--help选项,用于显示该命令的简短帮助信息,要了解ls命令的用法,可以运行以下命令:

ls --help

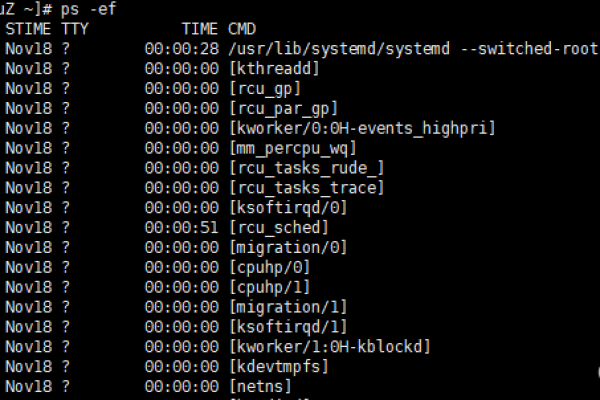

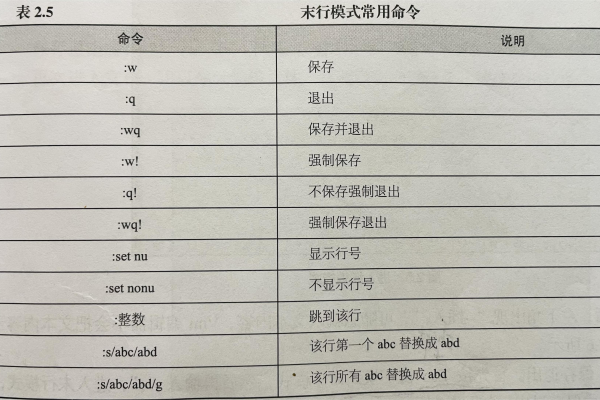

2、man命令:man命令是Linux中最常用的帮助命令之一,它可以显示命令或系统调用的手册页,手册页分为多个部分,每个部分包含不同类型的信息,要查看ls命令的手册页,可以使用:

man ls

手册页通常包括命令的描述、选项说明、示例和相关命令等信息。

3、info命令:info命令提供了一种比man更加友好的帮助界面,它支持超链接和搜索功能,要查看某个命令的info页面,可以使用:

info command_name

查看ls命令的info页面:

info ls

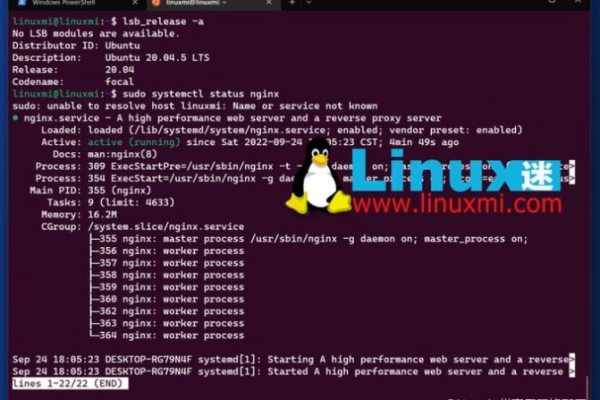

4、--version选项:许多命令支持--version选项,用于显示该命令的版本信息,这对于了解命令的功能和兼容性非常有用,查看gcc编译器的版本:

gcc --version

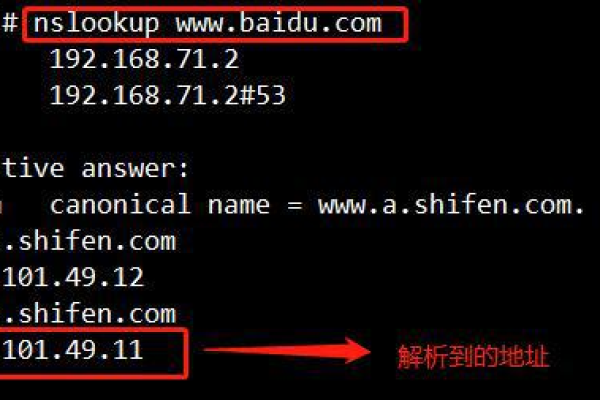

5、在线资源:除了本地帮助系统外,还可以通过互联网查找Linux命令的帮助文档,访问官方文档网站或使用搜索引擎搜索相关命令的使用方法。

二、查看配置文件帮助

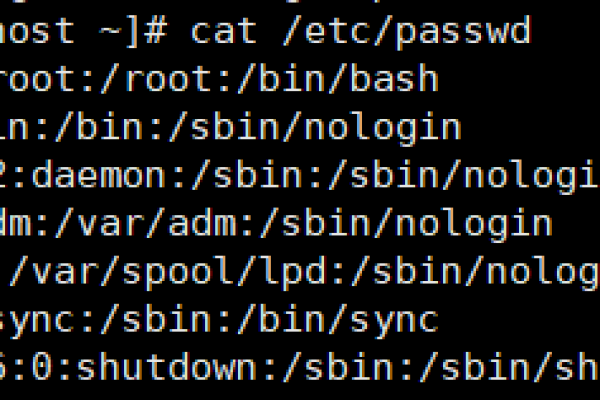

1、配置文件注释:许多Linux配置文件中都包含注释,解释各个配置项的作用,阅读这些注释可以帮助用户理解配置文件的内容和格式。

2、配置文件手册页:一些常用的配置文件也有相应的手册页,可以通过man命令查看,查看/etc/fstab文件的手册页:

man fstab

3、官方文档和社区指南:对于复杂的配置文件,可以参考官方文档或社区编写的指南,这些资源通常提供详细的配置示例和最佳实践。

三、查看编程接口帮助

1、头文件注释:在C语言等编程语言中,头文件通常包含函数和数据结构的注释,解释它们的用途和用法,阅读这些注释可以帮助开发者理解和使用这些接口。

2、API文档:许多编程语言和库都提供了API文档,详细说明了各个函数和类的用法,Python的官方文档(https://docs.python.org/)就是一个全面的API参考。

3、在线资源和社区论坛:除了官方文档外,还可以通过互联网查找编程接口的帮助信息,许多开发者社区和技术论坛都有丰富的讨论和教程,可以帮助解决具体问题。

在Linux系统中查看帮助文档是学习和使用各种工具的关键步骤,通过合理利用上述方法和资源,用户可以快速掌握命令行工具、配置文件和编程接口的使用方法,提高工作效率和技能水平。

FAQs

Q1: 如何更改Linux命令帮助的语言?

A1: 在大多数Linux发行版中,帮助文档的语言取决于系统的默认语言设置,要更改帮助文档的语言,可以修改系统的locale设置,要将帮助文档的语言设置为中文,可以编辑/etc/locale.conf文件(或使用localectl命令),将LANG环境变量设置为zh_CN.UTF-8,然后重新启动系统或重新登录,帮助文档就会以中文显示。

Q2: 如果man命令无法找到某个命令的帮助页面怎么办?

A2: 如果man命令无法找到某个命令的帮助页面,可能有以下几种原因:该命令没有安装手册页;手册页安装在非标准位置;或者手册页名称有误,解决方法包括:确保该命令已正确安装并包含手册页;使用man -w命令查找手册页的实际位置;或者检查手册页名称是否正确,如果问题依然存在,可以尝试使用其他帮助命令(如--help、info)或在线资源获取帮助信息。

到此,以上就是小编对于“linux 查看 帮助”的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位朋友在评论区讨论,给我留言。