如何优化MySQL数据库语句以提高性能?

- 行业动态

- 2024-09-01

- 12

在数据库的应用过程中,尤其是面对大数据量时,优化数据库语句显得尤为重要,优化不仅能提升查询效率,还可以提高整体系统的性能,下面将详细探讨如何优化MySQL数据库语句的方法:

1、合理设计数据表

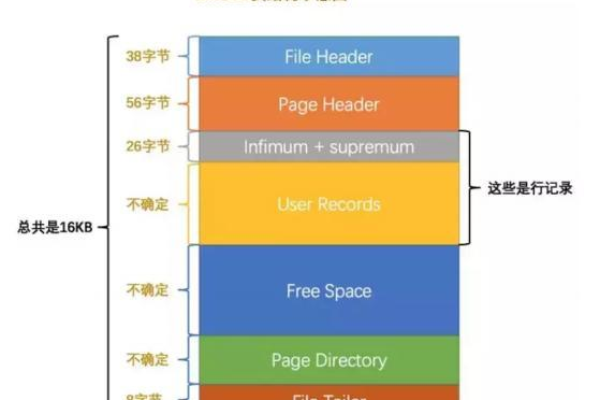

选择适当的数据类型和长度:选取最适用的字段属性对数据库性能至关重要,邮政编码可以使用CHAR(6)而不是VARCHAR,并避免使用过大的长度,如CHAR(255),这样可以显著减少存储空间,提高查询速度,对于整型数据,使用MEDIUMINT代替BIGINT可以节省空间并提高数据处理速度。

尽量避免NULL值:在可能的情况下,尽量设置字段为NOT NULL,这样在查询时,数据库不用去比较NULL值,这可以加速查询过程。

2、索引优化

合理创建索引:索引能显著提高查询速度,但过多或不当的索引会增加写入负担和占用更多存储空间,关键是要在查询频繁的字段上创建索引,并定期检查和清理不再使用或效用低下的索引。

选择合适的索引类型:了解不同类型索引的使用场景,如BTree索引,哈希索引等,根据数据的特点和查询需求选择最合适的索引类型。

3、查询语句优化

避免使用SELECT:从数据库中检索数据时,应避免使用SELECT * 查询所有字段,而应指定需要的字段,这样可以减少数据传输量,提高查询效率。

使用JOIN代替多个查询:在涉及多表查询时,使用JOIN可以减少查询次数,提高查询效率。

4、数据库参数优化

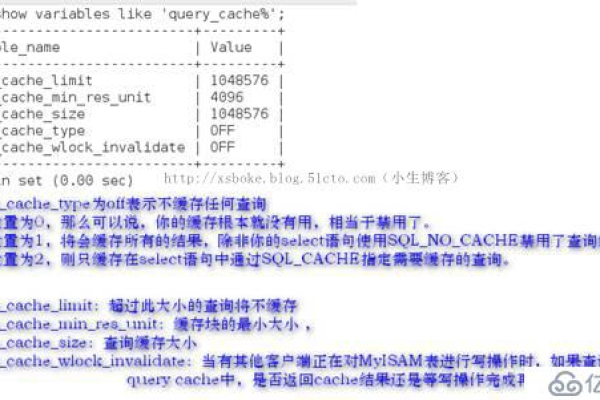

缓存优化:利用MySQL的查询缓存特性,对于频繁执行且结果集不常变的查询,可以设置合适的缓存策略,以减少磁盘访问次数,提高查询速度。

参数调优:调整MySQL的配置参数,如innodb_buffer_pool_size、query_cache_size等,根据服务器的硬件资源和应用场景的需求进行优化。

5、硬件与系统优化

升级硬件:增强服务器的硬件配置,如增加RAM、使用更快的硬盘(例如SSD),可以显著提升数据库性能。

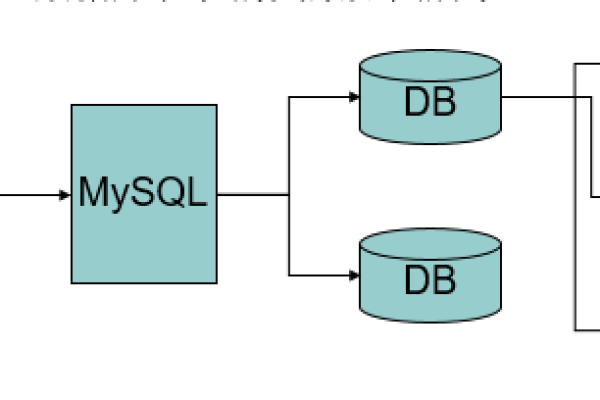

优化操作系统和存储引擎:选择合适的操作系统和存储引擎,如使用InnoDB或MyISAM,根据数据访问模式和事务需求来选择最合适的存储引擎。

6、维护与清理

定期清理垃圾数据:删除不再使用的数据和表格,定期进行数据归档,可以有效地减少数据库的体积,提高访问与处理速度。

冷热数据分离:将频繁访问的数据(热数据)和不常访问的数据(冷数据)分开存放,可以提高数据读取速度并优化存储使用。

在了解以上内容后,以下还有一些其他建议:

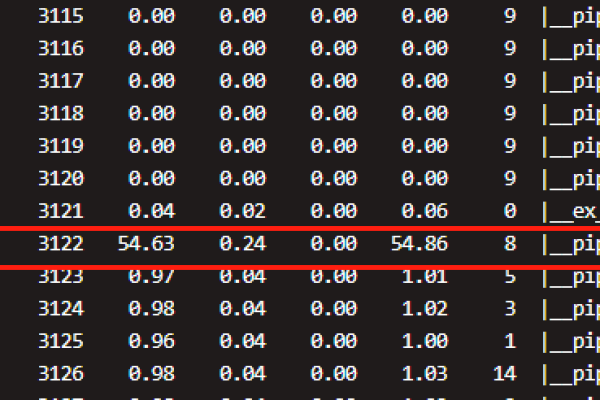

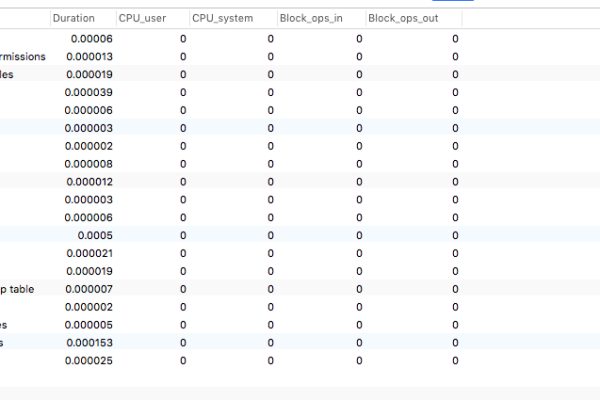

监控和分析:持续监控数据库的性能指标,如响应时间、查询频率等,以便及时发现问题并进行调整。

安全性考虑:在优化查询和提升性能的同时,不应忽视数据的安全性和备份。

优化MySQL数据库语句是一个综合性的过程,涉及到从数据表的设计到查询语句的编写,再到数据库参数和系统的优化,通过实施上述策略,不仅可以提升数据库的运行效率,还能增强用户的数据访问体验,每一步优化都应根据实际的业务需求和数据特性来定制实施,以达到最佳效果。