如何修改Linux系统的字体?

- 行业动态

- 2024-11-19

- 13

在Linux操作系统中,字体修改是一个常见的任务,无论是为了美化界面还是解决某些字体显示问题,本文将详细介绍如何在Linux系统中进行字体的安装、配置和修改。

安装新字体

我们需要获取新的字体文件,这些文件通常以.ttf(TrueType Font)或.otf(OpenType Font)格式提供,你可以从互联网上下载这些文件,或者使用系统自带的包管理器安装额外的字体包。

方法一:手动安装

1、下载字体文件:从可信来源下载所需的字体文件。

2、解压并复制字体文件:如果下载的是压缩包,先解压,然后将字体文件复制到~/.fonts 目录中,如果该目录不存在,可以创建它。

mkdir -p ~/.fonts

cp fontfile.ttf ~/.fonts/

3、刷新字体缓存:运行以下命令以更新字体缓存。

fc-cache -fv

方法二:使用包管理器

不同的Linux发行版有不同的包管理器,以下是一些常见发行版的示例:

Debian/Ubuntu:

sudo apt-get install fonts

要安装文泉驿字体:

sudo apt-get install fonts-wqy-zenhei

Fedora:

sudo dnf install *fonts

配置字体

安装完字体后,我们可以通过修改配置文件来更改系统或应用程序的默认字体设置。

修改全局字体设置

全局字体设置通常存储在/etc/fonts/local.conf 文件中,编辑这个文件,添加或修改相应的条目,要设置全局默认字体为 "Noto Sans":

<?xml version="1.0"?> <!DOCTYPE fontconfig SYSTEM "fonts.dtd"> <fontconfig> <match target="pattern"> <test qual="any" name="family"><string>Noto Sans</string></test> </match> <dir>="/usr/share/fonts" /> <dir prefix="xdg">~/.fonts</dir> </fontconfig>

保存文件并重新生成字体缓存:

fc-cache -fv

修改应用程序特定字体设置

有些应用程序允许用户通过其配置文件或设置界面更改字体,对于GNOME桌面环境,可以通过GNOME Tweaks工具更改系统字体。

验证字体修改

完成上述步骤后,可以通过以下方式验证字体是否已正确安装和配置:

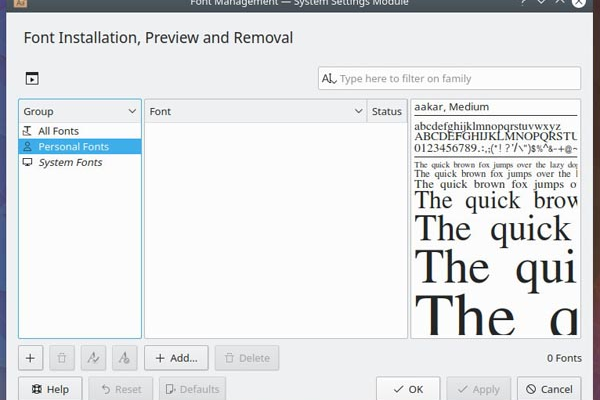

1、使用字体查看器:大多数Linux发行版都带有字体查看器,如fc-list,可以用来列出所有可用的字体。

fc-list :family | sort -u

2、检查应用程序:打开一个文本编辑器(如Gedit或VSCode)或其他支持自定义字体的应用程序,查看新字体是否出现在字体选择列表中。

相关问答FAQs

Q1: 如何删除不再需要的字体?

A1: 你可以通过删除~/.fonts 目录中的字体文件来移除不再需要的字体,重新生成字体缓存:

fc-cache -fv

Q2: 如果字体显示不正确怎么办?

A2: 如果字体显示不正确,可以尝试以下几个步骤:

确保字体文件没有损坏,并且是完整的。

检查字体配置文件是否正确无误。

尝试重新安装或更新字体。

如果问题依然存在,可能需要检查应用程序或系统的其他设置。

以上内容就是解答有关“linux 字体修改”的详细内容了,我相信这篇文章可以为您解决一些疑惑,有任何问题欢迎留言反馈,谢谢阅读。