如何在Linux系统中进行有效的账号管理?

- 行业动态

- 2024-11-19

- 9

Linux账号管理是系统管理员的重要职责,它涉及到用户账号的添加、删除和修改,本文将详细介绍Linux系统中的用户账号管理,包括用户账号文件、用户账号设置以及用户组的管理。

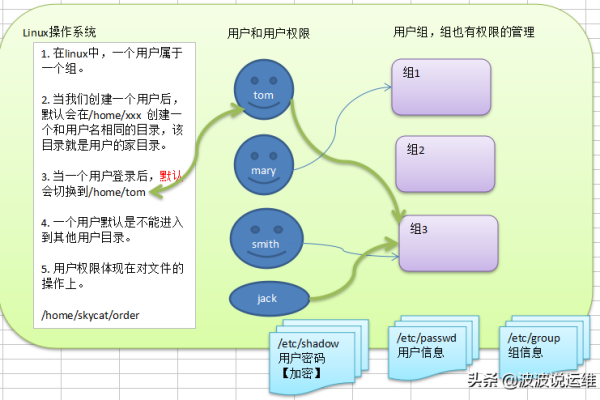

一、用户账号文件

在Linux系统中,所有用户账号的信息都保存在/etc/passwd文件中,而密码信息则保存在/etc/shadow文件中。

1、/etc/passwd文件:这个文件包含了用户的基本信息,如用户名、UID、GID、全名、家目录和登录Shell等,每一行代表一个用户账户,字段之间用冒号(:)分隔。

root:x:0:0:root:/root:/bin/bash

root是用户名,x表示密码占位符,0是UID,0是GID,root是全名,/root是家目录,/bin/bash是登录Shell。

2、/etc/shadow文件:这个文件包含了加密后的密码信息,以及其他与密码相关的信息,如密码最近修改的日期、密码不可修改的天数、密码需要再次修改的天数等,只有超级用户可以读取这个文件。

二、用户账号设置

用户账号的设置包括添加用户账号、设置/更改用户口令、修改用户账号的属性等。

1、添加用户账号:使用useradd命令可以添加新用户账号,要创建一个名为sam的用户,可以使用以下命令:

useradd -d /home/sam -m sam

这将在/home目录下创建一个名为sam的家目录,并在/etc/passwd和/etc/shadow文件中添加相应的记录。

2、设置/更改用户口令:使用passwd命令可以为用户设置或更改口令,要为sam用户设置口令,可以使用以下命令:

passwd sam

系统会提示输入新的口令并确认。

3、修改用户账号的属性:使用usermod命令可以修改用户账号的属性,如用户号、主目录、用户组、登录Shell等,要将sam用户的登录Shell修改为/bin/ksh,可以使用以下命令:

usermod -s /bin/ksh sam

这将更新/etc/passwd文件中的相关记录。

三、用户组的管理

用户组是将多个用户集合在一起管理的机制,每个用户都有一个基本组和一个或多个附加组。

1、增加一个新的用户组:使用groupadd命令可以创建新的用户组,要创建一个名为developers的用户组,可以使用以下命令:

groupadd developers

这将在/etc/group文件中添加相应的记录。

2、将用户添加到用户组:使用usermod命令可以将用户添加到用户组,要将sam用户添加到developers组,可以使用以下命令:

usermod -aG developers sam

这将在/etc/group文件中更新相关记录。

3、从用户组中移除用户:使用gpasswd命令可以从用户组中移除用户,要将sam用户从developers组中移除,可以使用以下命令:

gpasswd -d sam developers

这将在/etc/group文件中更新相关记录。

四、查询账号信息

Linux提供了一些命令来查询用户账号的信息,如id、groups和finger等。

1、查询用户身份标识:使用id命令可以查询用户的UID、GID和所属的组等信息。

id sam

这将显示sam用户的UID、GID和所属的组。

2、查询用户所属的组:使用groups命令可以查询用户所属的所有组。

groups sam

这将显示sam用户所属的所有组。

3、查询用户帐号的详细信息:使用finger命令可以查询用户的全名、家目录、登录Shell等信息。

finger sam

这将显示sam用户的详细信息。

五、文件/目录的权限和归属

在Linux系统中,每个文件和目录都有明确的权限和归属,用于控制对资源的访问。

1、查看文件/目录的权限和归属:使用ls -l命令可以查看文件或目录的权限和归属。

ls -l /home/sam

这将显示/home/sam目录及其内容的权限和归属信息。

2、设置目录和文件的权限:使用chmod命令可以设置目录和文件的权限,要设置文件file.txt的权限为-rw-r--r,可以使用以下命令:

chmod 644 file.txt

这将设置文件所有者可读写,群组和其他人只可读取。

3、设置目录和文件的归属:使用chown命令可以设置目录和文件的归属,要将文件file.txt的所有者设置为sam,可以使用以下命令:

chown sam file.txt

这将设置文件file.txt的所有者为sam。

Linux账号管理是一个复杂但重要的过程,涉及到用户账号的添加、删除和修改,以及用户组的管理,通过合理地管理用户账号和组,可以确保系统的安全性和资源的有效利用。

小伙伴们,上文介绍了“linux账号管理”的内容,你了解清楚吗?希望对你有所帮助,任何问题可以给我留言,让我们下期再见吧。