Spark中怎么执行SQL数据

- 行业动态

- 2024-03-15

- 9

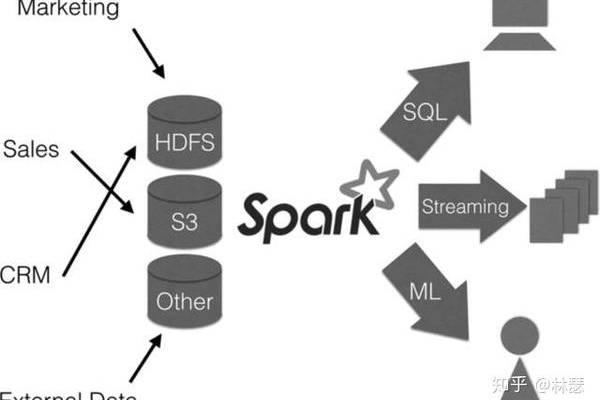

在Spark中执行SQL数据需要先创建SparkSession,然后使用其内置的SQLContext进行SQL查询,可以通过读取数据库、JSON、CSV等格式的数据源来创建DataFrame,进而执行SQL操作。

在Apache Spark中执行SQL数据主要涉及Spark SQL模块,它是Spark的一个核心组件,用于处理结构化和半结构化数据,以下是执行SQL数据的步骤和详细技术介绍:

1. 初始化SparkSession

SparkSession是使用Spark SQL的入口点,它提供了一种方法来配置Spark SQL的各种选项,并可以用作创建DataFrame、执行SQL查询以及访问Hive表等功能的统一入口。

import org.apache.spark.sql.SparkSession

val spark = SParkSession.builder()

.appName("Spark SQL Example")

.config("spark.some.config.option", "value")

.getOrCreate()

2. 创建DataFrame

要执行SQL,首先需要将数据加载到DataFrame中,DataFrame是一种分布式数据集,具有模式(即结构信息),类似于传统数据库中的表。

val df = spark.read.format("csv")

.option("header", "true")

.load("/path/to/your/data.csv")

3. 注册为临时表

一旦有了DataFrame,就可以将其注册为临时表,这样就可以使用SQL语句来查询它了。

df.createOrReplaceTempView("my_temp_table")

4. 执行SQL查询

使用SparkSession的sql()方法,可以执行SQL查询,Spark SQL支持标准的SQL语法以及Hive兼容性。

val result = spark.sql("SELECT * FROM my_temp_table WHERE column = 'value'")

5. 显示结果

查询的结果也是一个DataFrame,可以使用它的show()方法来查看前几行数据。

result.show()

6. 使用自定义函数(UDF)

如果需要在查询中使用自定义逻辑,可以定义用户自定义函数(UDF)并将其注册到SparkSession中,然后在SQL查询中使用它。

import org.apache.spark.sql.functions.udf

val myUdf = udf((input: String) => /* some logic */)

spark.udf.register("my_udf", myUdf)

val resultWithUdf = spark.sql("SELECT my_udf(column) FROM my_temp_table")

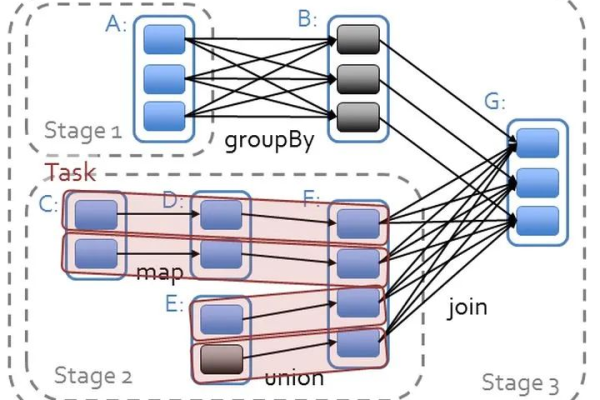

7. 优化查询性能

为了提高查询性能,可以考虑以下策略:

分区:根据数据的大小和查询模式对表进行分区。

缓存:对于经常使用的表,可以使用cache()方法将其缓存起来,以便快速访问。

调整执行计划:使用Catalyst优化器来优化查询计划。

相关问题与解答

Q1: 如何在Spark中处理大型数据集?

A1: 对于大型数据集,可以使用Spark的分区和并行处理功能,通过将数据分布在多个节点上,并利用Spark的分布式计算能力,可以高效地处理大型数据集。

Q2: Spark SQL支持哪些数据源?

A2: Spark SQL支持多种数据源,包括但不限于Parquet、ORC、JSON、JDBC、Hive等,可以通过不同的读取格式来加载这些数据源中的数据。

Q3: 如何调试Spark SQL查询?

A3: 可以使用Spark的explain()方法来查看查询的执行计划,这有助于理解查询是如何被优化和执行的,还可以启用Spark SQL的详细日志记录来跟踪查询的执行情况。

Q4: Spark SQL与关系型数据库有何不同?

A4: Spark SQL是一个大数据处理框架,它提供了对结构化和半结构化数据的处理能力,而关系型数据库主要用于存储和管理结构化数据,Spark SQL支持分布式处理,可以扩展到多台机器上,而关系型数据库通常运行在单个服务器上。