MapReduce的工作原理是什么?

- 行业动态

- 2024-08-02

- 2

MapReduce是一种编程模型,用于大规模数据集(大于1TB)的并行运算,Hadoop MapReduce是一个易于编程并且能在大型集群(上千节点)快速地并行处理大量数据的软件框架,以可靠、容错的方式部署在商用机器上,下面将详细解析MapReduce的基本原理,并使用小标题和单元表格来结构化内容:

基本概念

1、MapReduce的核心思想

两个阶段:MapReduce操作分为Map(映射)和Reduce(归约)两个阶段。

键值对:输入和输出都是基于键值对进行处理。

2、数据流

输入数据:原始数据通常以文本形式存在,并被分割成小块。

输出数据:结果数据同样以文本形式输出,存储在HDFS(Hadoop分布式文件系统)中。

工作原理

1、输入与分割

输入文件:一个MapReduce作业可以处理多个文件,这些文件存储在HDFS中。

文件分割:输入文件会自动分割成一个个小的数据块,每个数据块默认大小为64MB。

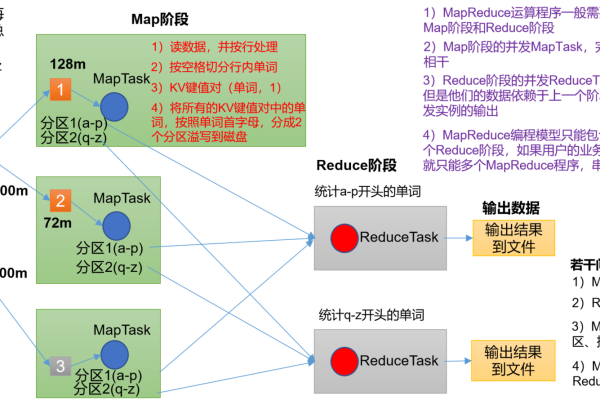

2、Map阶段

键值对生成:每个Map任务会处理一个输入数据块,并将其转换成一系列键值对。

数据处理:Map函数会对每个键值对进行处理,生成一组中间键值对。

3、Shuffle阶段

排序与传输:Shuffle是Map到Reduce之间的过渡阶段,负责对Map输出的键值对进行排序,并将它们传输给对应的Reduce任务。

分组:具有相同键的值会被分组在一起,以便Reduce任务能够批量处理。

4、Reduce阶段

结果输出:Reduce任务会遍历来自Shuffle的键值对,并根据业务逻辑处理数据,最终输出结果键值对。

数据整合:Reducer将具有相同键的值集合合并,通常用于统计或汇总操作。

5、输出

最终结果:Reduce任务的输出是最终的结果,通常会写回到HDFS中。

文件写入:结果可以被存储为单个文件或多个文件,具体取决于应用需求。

MapReduce执行流程

1、提交作业

作业配置:用户需要配置作业,包括设置Mapper、Reducer、输入输出格式等。

作业提交:通过Hadoop客户端提交作业到集群。

2、作业初始化

作业调度:Hadoop集群中的JobTracker负责作业的调度和跟踪。

任务分配:TaskTracker负责执行任务,JobTracker将任务分配给空闲的TaskTracker。

3、任务执行

Map任务执行:每个Map任务独立执行,处理分配给它的数据块。

Reduce任务执行:Reduce任务在Map任务完成后开始执行,处理来自Map任务的输出。

4、结果回写

结果持久化:Reduce任务的结果会直接写回到HDFS,确保数据的持久性和可靠性。

作业完成:所有任务完成后,JobTracker会标记作业为成功完成状态。

优化与容错

1、性能优化

Combiner:在Map阶段后使用Combiner可以减少网络传输的数据量。

Input/Output格式选择:选择合适的输入输出格式可以提升数据处理效率。

2、容错机制

任务失败重试:失败的任务会被重新调度执行,以确保作业的成功完成。

数据备份:HDFS会自动备份数据块,防止因节点故障导致的数据丢失。

MapReduce的基本原理涉及数据的分割、映射、洗牌、归约和输出等关键步骤,通过了解其内部工作机制,用户可以更有效地编写和优化大数据处理任务,Hadoop生态系统提供了丰富的工具和接口,使得MapReduce成为大数据分析的强大工具。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/72728.html