服务器延迟计算公式

- 行业动态

- 2025-02-12

- 10

一、基本概念

服务器延迟通常指数据从客户端发送到服务器,再从服务器返回到客户端所经历的时间,它对在线游戏、实时语音视频通话等应用的体验影响极大。

二、计算公式

1、往返延迟(RTT)计算

公式:RTT = T2 T1

含义:其中T1是客户端向服务器发送请求消息的时间戳,T2是客户端接收到服务器对该请求响应消息的时间戳,在一次网络通信中,客户端在T1时刻发送了一个数据包给服务器,服务器处理后在T2时刻将响应数据包发送回客户端,那么通过计算T2与T1的差值就可以得到这次通信的往返延迟时间,这种计算方法适用于简单的请求 响应模式,能够直观地反映出数据在客户端和服务器之间往返一次所需的时间。

2、单向延迟计算(结合RTT)

公式:单向延迟 = RTT/2

原理:由于RTT是往返双向的总延迟,在理想情况下,假设数据在客户端到服务器和服务器到客户端这两段路径上的传输条件相同(如带宽、网络拥塞情况等),那么单向延迟可以通过将RTT除以2来近似估算,不过实际情况可能较为复杂,因为网络路径可能存在不对称性,比如上行链路(客户端到服务器)和下行链路(服务器到客户端)的带宽、路由跳数等可能不同,所以这种估算只是一个近似值。

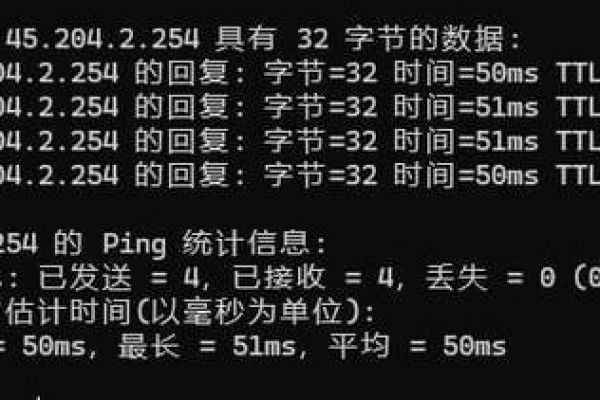

3、考虑网络因素的延迟计算(使用ping命令)

公式:延迟 = 平均往返延迟 = ∑(每次RTT) / n

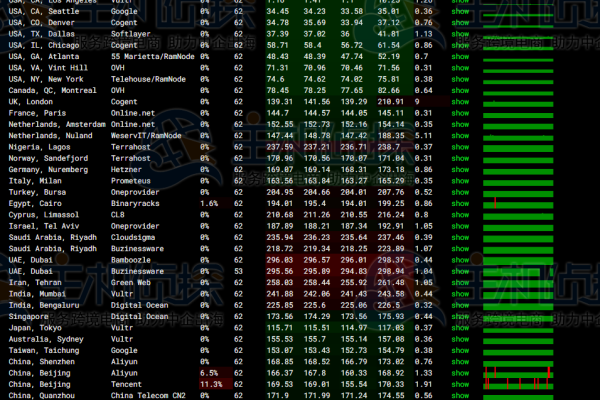

解释:在实际网络环境中,网络状况是动态变化的,为了更准确地衡量服务器延迟,通常会进行多次测量然后取平均值,使用ping命令向服务器发送多个ICMP回显请求数据包(默认一般是4个或更多),每次发送都会记录一个RTT值,然后将这些RTT值相加并除以测量次数n,得到平均往返延迟,这样可以在一定程度上减少因网络瞬间波动(如某个数据包在传输过程中遇到临时的网络拥塞而延迟较大)对延迟测量结果的影响。

三、示例表格展示

| 测量次数 | T1(客户端发送请求时间戳) | T2(客户端接收响应时间戳) | RTT(本次往返延迟) |

| 1 | 0.001s | 0.051s | 0.05s |

| 2 | 0.002s | 0.062s | 0.06s |

| 3 | 0.003s | 0.073s | 0.07s |

| 平均往返延迟 | (0.05 + 0.06 + 0.07)/3 = 0.06s |

四、相关问答FAQs

1、问:为什么实际测量的服务器延迟会比理论计算的要大?

答:实际测量的服务器延迟比理论计算大是因为存在多种因素的影响,网络中的中间设备(如路由器、交换机)在处理数据包时会有处理时间和排队延迟,网络拥塞可能导致数据包在传输过程中需要在队列中等待,尤其是在网络高峰时段,服务器本身的负载情况也会影响响应速度,如果服务器同时处理大量请求,就会导致处理每个请求的时间延长,从而使客户端感受到的延迟增大,客户端和服务器的地理位置距离也会影响延迟,距离越远,数据传输经过的物理链路越长,传输时间也就可能越长。

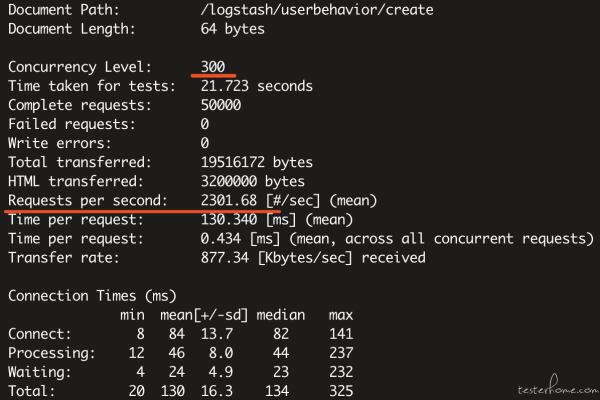

2、问:如何通过优化服务器配置来降低延迟?

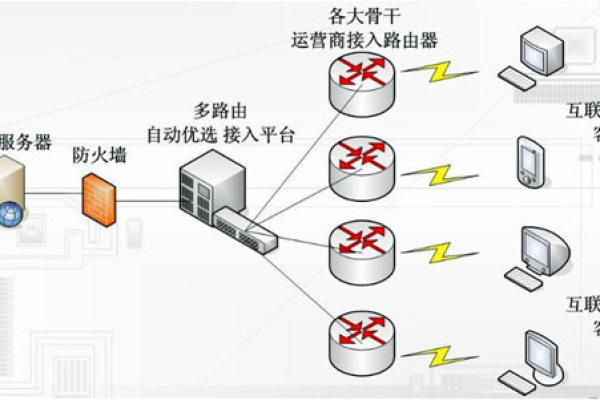

答:可以从多个方面优化服务器配置来降低延迟,一是升级服务器硬件,例如采用更快的处理器可以提高服务器处理请求的速度,增加内存可以减少数据在内存和硬盘之间的交换频率,从而加快数据处理效率,二是优化服务器软件,如调整操作系统的网络参数,合理设置线程池大小以提高并发处理能力,还可以对服务器应用程序进行性能优化,减少不必要的计算和资源占用,三是选择合适的网络服务提供商,确保服务器有足够大的带宽和低延迟的网络连接,以便快速地发送和接收数据。

小编有话说

服务器延迟是一个复杂的指标,受到多种因素的综合影响,准确计算和理解服务器延迟对于优化网络应用的性能至关重要,无论是网络管理员还是普通用户,了解这些延迟计算方法和影响因素,都有助于更好地评估网络服务质量,并采取相应的措施来改善网络体验,在选择服务器托管服务或评估网络应用性能时,一定要重视服务器延迟这个关键因素。