ubuntu怎么安装apache

- 行业动态

- 2024-03-29

- 6

,sudo apt-get update,`

,3. 输入以下命令,安装Apache:,`

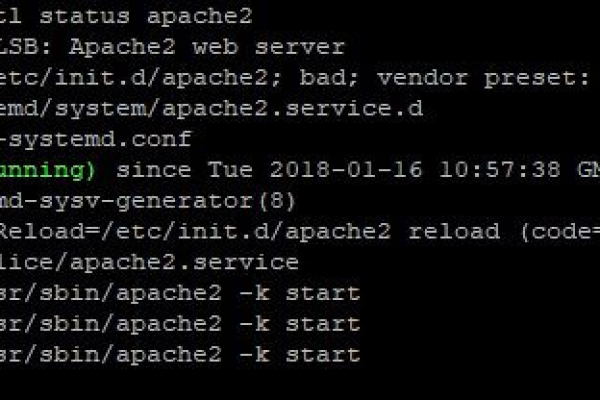

,sudo apt-get install apache2,“,4. 安装完成后,Apache会自动启动。在浏览器中输入服务器的IP地址或域名,即可看到默认的Apache欢迎页面。

在Ubuntu 20.04 LTS上安装和配置Apache的mod_pagespeed模块,可以按照以下步骤进行:

1. 安装依赖项

需要安装一些必要的依赖项,打开终端,然后运行以下命令:

sudo apt update sudo apt install y buildessential libtool autoconf automake pkgconfig libpcre3 libpcre3dev zlib1g zlib1gdev libssldev

2. 下载并编译mod_pagespeed

接下来,从Google的GitHub仓库下载mod_pagespeed源代码,然后编译并安装它,运行以下命令:

cd /tmp git clone https://github.com/apache/incubatorpagespeedmod_pagespeed.git cd incubatorpagespeedmod_pagespeed autogen.sh ./configure withapache=/usr/bin/httpd withapr=/usr/bin/apr1config withaprutil=/usr/bin/apu1config make sudo make install

3. 配置Apache以使用mod_pagespeed

现在,需要配置Apache以使用新安装的mod_pagespeed模块,编辑Apache的配置文件,通常位于/etc/apache2/apache2.conf或/etc/httpd/conf/httpd.conf,在文件末尾添加以下行:

LoadModule pagespeed_module /usr/lib/apache2/modules/mod_pagespeed.so ModPagespeed on ModPagespeedFileCachePath /var/cache/mod_pagespeed

保存并关闭文件,重新启动Apache以应用更改:

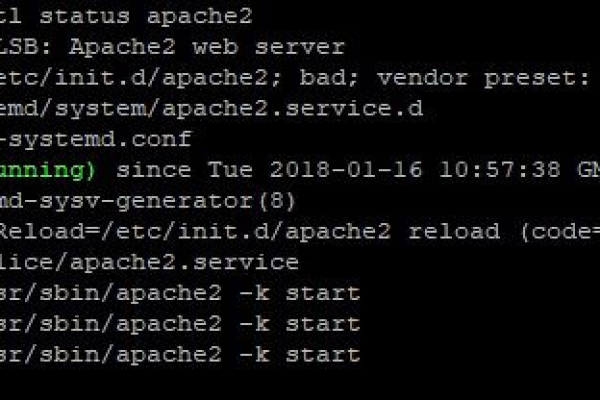

sudo systemctl restart apache2

4. 验证mod_pagespeed是否已启用

可以通过访问Apache服务器并在响应头中查找XPageSpeed来验证mod_pagespeed是否已成功启用,如果Apache服务器正在本地主机上运行,可以在浏览器中访问http://localhost,然后检查网络请求的响应头,如果看到XPageSpeed,则表示mod_pagespeed已成功启用。

5. 优化mod_pagespeed性能

为了获得最佳性能,可以根据需要调整mod_pagespeed的配置,可以在Apache配置文件中添加以下行来设置缓存大小和其他选项:

ModPagespeedMapRewriteDomain http://www.example.com/ ModPagespeedMapRewriteEnabled on ModPagespeedInPlaceRewriteEnabled on ModPagespeedSrcRewriteEnabled on ModPagespeedRewriteBlacklistRegexp ".*.(jpg|jpeg|png|gif|css|js)$" ModPagespeedFileCacheSizeKb 102400 ModPagespeedFileCacheCleanIntervalMs 3600000

这些设置将限制缓存大小为100MB,并将缓存清理间隔设置为1小时,请根据实际需求进行调整。

归纳一下,要在Ubuntu 20.04 LTS上安装和配置Apache的mod_pagespeed模块,需要执行以下操作:

1、安装依赖项

2、下载并编译mod_pagespeed

3、配置Apache以使用mod_pagespeed

4、验证mod_pagespeed是否已启用

5、优化mod_pagespeed性能(可选)