服务器当爬虫

- 行业动态

- 2025-02-24

- 5

原理、实践与注意事项

在当今数字化时代,网络数据的采集与分析变得愈发重要,服务器充当爬虫的角色,能够高效地从互联网上抓取海量数据,为各种应用提供有力支持,以下将详细阐述服务器作为爬虫的相关要点。

一、服务器当爬虫的原理

服务器要实现爬虫功能,核心在于模拟浏览器向目标网站发送请求并解析返回的数据,其基本流程如下:

| 步骤 | 描述 |

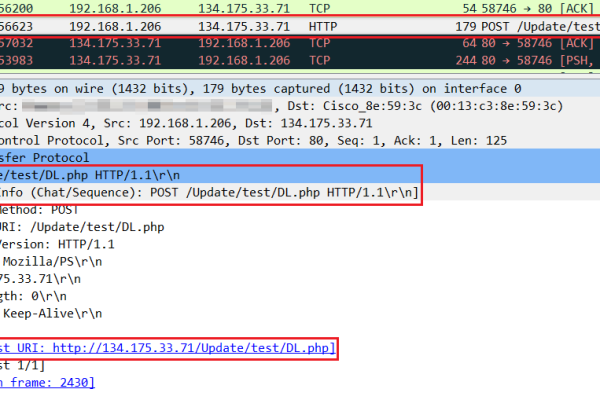

| 发送请求 | 服务器通过特定的编程语言(如 Python 的requests 库、Node.js 的axios 库等)向目标网站的 URL 发送 HTTP 请求,请求头中可包含模拟浏览器的用户代理信息,以降低被识别为爬虫的概率。 |

| 接收响应 | 目标网站服务器接收到请求后,会返回一个包含网页内容的响应,该响应通常遵循 HTTP 协议,包括状态码(如 200 表示成功)、响应头和响应体。 |

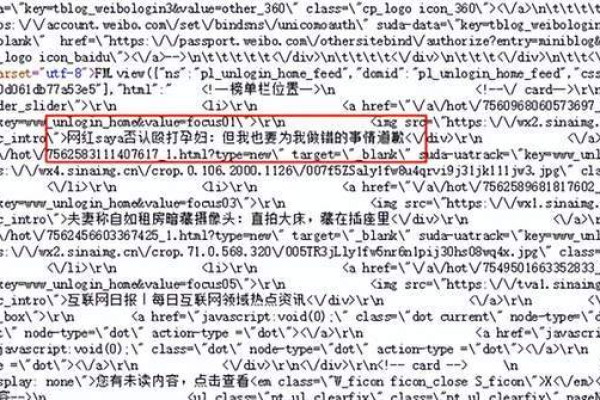

| 解析数据 | 服务器对响应体进行解析,根据目标网站的数据格式(如 HTML、JSON、XML 等),提取所需的数据,对于 HTML 页面,可借助 BeautifulSoup(Python)、cheerio(Node.js)等解析库来定位和提取元素内容。 |

| 数据处理与存储 | 提取的数据需要进行清洗、转换等处理,以便后续的分析和应用,处理后的数据可以存储在数据库(如 MySQL、MongoDB)或文件系统(如 CSV、JSON 文件)中。 |

二、服务器当爬虫的实践案例

以使用 Python 语言和requests、BeautifulSoup 库爬取某新闻网站文章标题为例:

1、环境搭建:首先确保服务器已安装 Python 环境,并使用pip install requests beautifulsoup4 命令安装所需库。

2、代码编写:

import requests

from bs4 import BeautifulSoup

url = 'https://example-news-website.com'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

response = requests.get(url, headers=headers)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

titles = soup.find_all('h2', class_='article-title')

for title in titles:

print(title.text)

else:

print('Failed to retrieve the webpage')

3、运行与结果:在服务器终端运行上述代码,即可看到爬取到的文章标题输出在控制台上。

三、服务器当爬虫的注意事项

1、合法性:确保爬虫行为符合目标网站的服务条款和相关法律法规,未经授权爬取受版权保护或隐私敏感的数据可能导致法律问题。

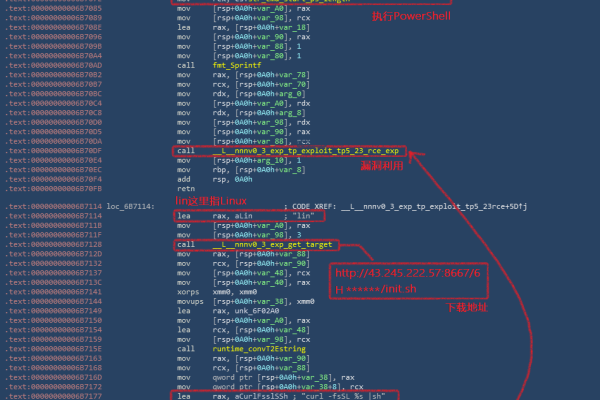

2、反爬虫机制:许多网站设有反爬虫机制,如限制 IP 访问频率、检测异常请求头、验证码验证等,服务器爬虫需要采取相应策略应对,如使用代理 IP 池、随机化请求头、自动识别和处理验证码等。

3、性能与负载:大规模爬虫任务可能对服务器性能产生较大影响,需合理配置服务器资源,优化爬虫代码效率,避免因爬虫导致服务器负载过高而影响其他服务的正常运行。

四、相关问答 FAQs

问题 1:如何避免服务器爬虫被目标网站封禁?

答:可以采取多种措施,一是使用大量高质量的代理 IP,定期切换 IP 以避免单一 IP 频繁访问;二是模拟正常用户的行为模式,如设置随机的请求间隔时间、随机化用户代理字符串等;三是对请求次数和频率进行合理限制,避免过度请求引起目标网站的警觉。

问题 2:服务器爬虫如何处理动态加载的数据?

答:对于通过 JavaScript 动态加载的数据,可以使用工具如 Selenium(适用于 Python 等多种语言),Selenium 能够模拟浏览器的行为,包括执行 JavaScript,从而获取动态加载后的数据,但需要注意的是,Selenium 相对消耗服务器资源,使用时应根据具体情况权衡性能与需求。

小编有话说

服务器当爬虫是一项强大但需要谨慎使用的技术,它在数据采集和分析领域有着广泛的应用前景,但必须在合法合规的前提下进行操作,开发者在使用服务器爬虫时,应充分了解目标网站的规则和法律法规要求,不断优化爬虫策略和技术,以确保数据的高效采集与安全使用,同时也维护网络生态的健康与稳定。